Врачам все больше и больше необходимо использовать ChatGPT, чтобы помочь вам обратиться к врачу AI новички

Если вы когда-нибудь расскажете ChatGPT о своих проблемах, он, скорее всего, начнет со слов: «Мне жаль слышать, что вам грустно».

Когда рутина будет повторяться снова и снова, вы не удивитесь, а даже почувствуете, что она справляется.

Вот почему врачей нельзя заменить, только они могут установить настоящие и эффективные терапевтические отношения с пациентами.

Но это не значит, что ИИ нельзя использовать в медицинской отрасли. ChatGPT неожиданным образом открыл врачам дверь в новый мир.

Не только больше знают, но и внимательнее врачей

Некоторое время назад Калифорнийский университет в Сан-Диего провел интересное исследование: исследователи нашли 195 реальных вопросов и ответов врача-пациента в социальных сетях, а затем скормили эти вопросы в ChatGPT, а затем передали их экспертам по слепым. оценка, сравнение врачей-людей и врачей.Соревнуйтесь с ИИ.

Эти вопросы варьировались от «как лечить хронический кашель» до «проглотил зубочистку, и мои друзья сказали, что я умру».

Результат был ошеломляющим. ChatGPT превзошел врачей-людей как по качеству информации, так и по сочувствию.

Предпочтения экспертов влияют на результаты оценки. В этом исследовании эмпатия ChatGPT обычно проявляется в сочувствии к дискомфорту пациента. Кроме того, в отличие от короткого и экономящего время стиля доктора, его ответы длиннее и более личные.

Чтобы привести простой пример, на вопрос, «приводит ли отбеливатель к слепоте после попадания в глаза», ChatGPT сначала выразил сочувствие, а затем уточнил шаги по очистке глаз. Врач просто сказал: «Это не похоже на проблему» и предложил другой стороне промыть глаза.

Вам может показаться, что ответ врача более обнадеживающий. Однако это исследование не предназначено для обсуждения того, может ли ChatGPT заменить врачей, а лишь предполагает возможность: ChatGPT может служить помощником в таких сценариях, как телемедицина, экономя время врачей.

Поскольку в ChatGPT ерунда, его должен проверить врач. Исследователи видят будущее сотрудничества врачей и ИИ:

Если бы на большее количество вопросов пациентов отвечали быстро, качественно и с пониманием, это могло бы сократить количество ненужных посещений клиники и высвободить ресурсы для тех, кто в них нуждается.

Нетрудно представить, что, помимо эффективности, сотрудничество человека и ИИ также расширяет возможности обездоленных. Пациенты с ограниченной подвижностью, долгим рабочим днем и пациенты, которые не могут позволить себе расходы, могут больше нуждаться в сопутствующих услугах.

Такие продукты уже есть. В мае нью-йоркская компания Belong.Life, специализирующаяся на медицинских технологиях, запустила Dave: первый в мире разговорный искусственный интеллект для больных раком. Он фокусируется только на области рака на основе двух больших языковых моделей, а обучающие данные включают миллиарды точек данных из приложения компании за семь лет.

В качестве круглосуточного резервного ИИ Дейв хорошо отвечает на вопросы круглосуточно, он может помочь пациентам понять их собственное состояние, чтобы они могли позже обсудить это с врачами.

Кроме того, утешение пациентов и проявление сочувствия также являются «профессиональной этикой» Дэйва. Соучредитель Belong.Life сказал в интервью:

Дейву удалось снизить уровень стресса у пациентов и время, которое врачи тратят на обучение пациентов.

В каждом сообщении от Дэйва будет указано, что оно сгенерировано ИИ, может быть не всегда точным, и пациенты должны проконсультироваться со своим врачом, прежде чем принимать решение. Поэтому ИИ не может заменить врачей, но он стал мостом между врачами и пациентами.

Влияние ИИ на каждого отдельного врача постепенно становится понятным, как проявленное фото. Зарубежные СМИ взяли интервью у нескольких врачей, которые использовали ChatGPT по-разному, но в большей или меньшей степени касались эмпатии.

Некоторые врачи используют ChatGPT, чтобы лучше организовать язык при объяснении медицинских назначений и уведомлении о плохих новостях. Они полушутя говорят, что их язык иногда «слишком продвинут»:

Даже слова, которые мы думаем, легко понять, таковыми не являются.

Некоторым врачам необходимо регулярно общаться с группой алкоголиков, они просят ChatGPT помочь составить список тезисов, если пациенту не хватает медицинских знаний, то пусть ИИ перепишет его под уровень чтения учеников начальной школы. Один из врачей остался очень доволен началом, написанным ИИ. Эта фраза кажется на первый взгляд обычной, но именно искренность и впечатляет доктора:

Если вы думаете, что выпили слишком много, вы не одиноки. У многих людей есть эта проблема, но есть лекарства, которые могут помочь вам чувствовать себя лучше и вести более здоровую и счастливую жизнь.

На самом деле дело не в том, что многие врачи не хотят выражать сочувствие, а в том, что интенсивность работы и нагрузка слишком велики, они уже не в состоянии справиться с потребностями поликлиник и дистанционных консультаций, а сами впадают в выгорание и истощение.

Поэтому некоторые врачи просят ChatGPT помочь им написать электронное письмо страховым компаниям с просьбой покрыть их пациентов. На самом деле это тяжелая и повторяющаяся работа, и она может занять даже несколько часов, но для завершения тонкой настройки после передачи ее ИИ требуется всего несколько минут, что позволяет врачам уделять больше времени спасению жизней и лечению раненых. .

Сказав это, определение эмпатии у врачей может отличаться от определения широкой публики, и оно более разделено.

«Когнитивная эмпатия» относится к способности врача распознавать эмоции пациента и учитывать эти эмоции при принятии решений. Напротив, «эмоциональная эмпатия» ближе к тому, что мы понимаем под «эмпатией».

В книге «Выход из эмпатии» упоминается подобная точка зрения: автор Блум грубо делит эмпатию на два типа: «когнитивную эмпатию» и «эмоциональную эмпатию». Он считает, что принятие лучших поведенческих и моральных решений должно основываться на познании, а не на эмоциональном сопереживании.

Чаще всего эмпатия тонкая и сложная, и трудно различить Чу, Хэ и Хань, и часто требуется как когнитивная, так и эмоциональная эмпатия.

Профессия врача требует не только эмоционального уважения к чувствам пациентов, но и рационального проявления профессионализма, а для посторонних трудовая нагрузка еще более тяжела. Как уловить масштаб эмпатии для них сложно.

ИИ не может на самом деле сочувствовать, но в результате он вызывает чувство сопереживания у некоторых пациентов и действительно может быть помощником для врачей, чтобы разделить бремя.

Остерегайтесь ловушек механической эмпатии

«Эмпатия» ИИ не только клише, ее также чувствуют пациенты на другом конце провода.

В отчете журнала Wired упоминается, что некоторые люди с аутизмом считают, что общение с ИИ — это хороший опыт, потому что он ближе к их манере говорить и вести себя.

Симптомы различаются у людей с аутизмом, но распространены нарушения социального взаимодействия. Некоторые пациенты позволяют ИИ вносить предложения, когда у них возникают споры с другими, и пытаются выражать свои эмоции вместо того, чтобы молчать, как раньше.

Для них ИИ становится новым, ценным, независимым ресурсом, доступным в любое время и в любом месте и без почасовой оплаты.

Однако это всего лишь пример: как использовать ChatGPT для помощи специальным группам, серьезных исследований не проводилось, и никто не знает, насколько велик риск.

Поэтому Маргарет Митчелл, главный специалист по этике в Hugging Face, предлагает ограничить использование ИИ людям, которые испытывают серьезные эмоциональные расстройства.

У нас нет полного контроля над тем, что он говорит, что является огромной проблемой.

Тем не менее, терапия чат-ботами имеет свои корни, и эта концепция восходит к десятилетиям.

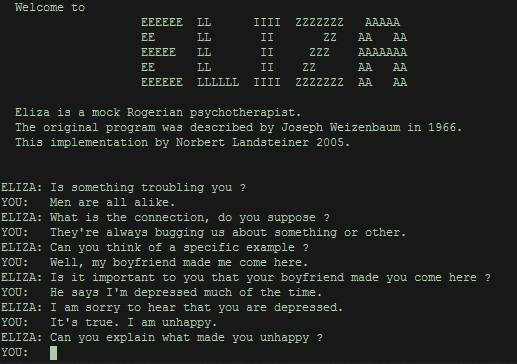

ELIZA, первая программа, позволяющая общаться между человеком и машиной, была создана в Массачусетском технологическом институте в 1960-х годах. их пользователями, чтобы пользователи чувствовали себя так, как будто их услышали, понимали, что сущностью человека является ретранслятор.

Факты доказали, что, как бы ни было просто и грубо, людям нужна «эмпатия» машины, даже если это всего лишь иллюзия. Цель запуска ELIZA — продемонстрировать, насколько поверхностно компьютеры понимают человеческий язык. Вместо этого он привлек огромное количество пользователей, которые часами запирались в своих комнатах только для того, чтобы шептаться с ним.

Сегодня генеративный ИИ, основанный на больших языковых моделях, может давать более разнообразные ответы, что умнее, чем ELIZA, но у них есть и уникальные проблемы.

Помимо предубеждений, ложной информации и утечек конфиденциальности, «ChatGPT» могут заставлять людей попадать в ловушку «механической эмпатии», то есть давать повторяющиеся и стандартизированные шаблоны при ответах на определенные типы вопросов.

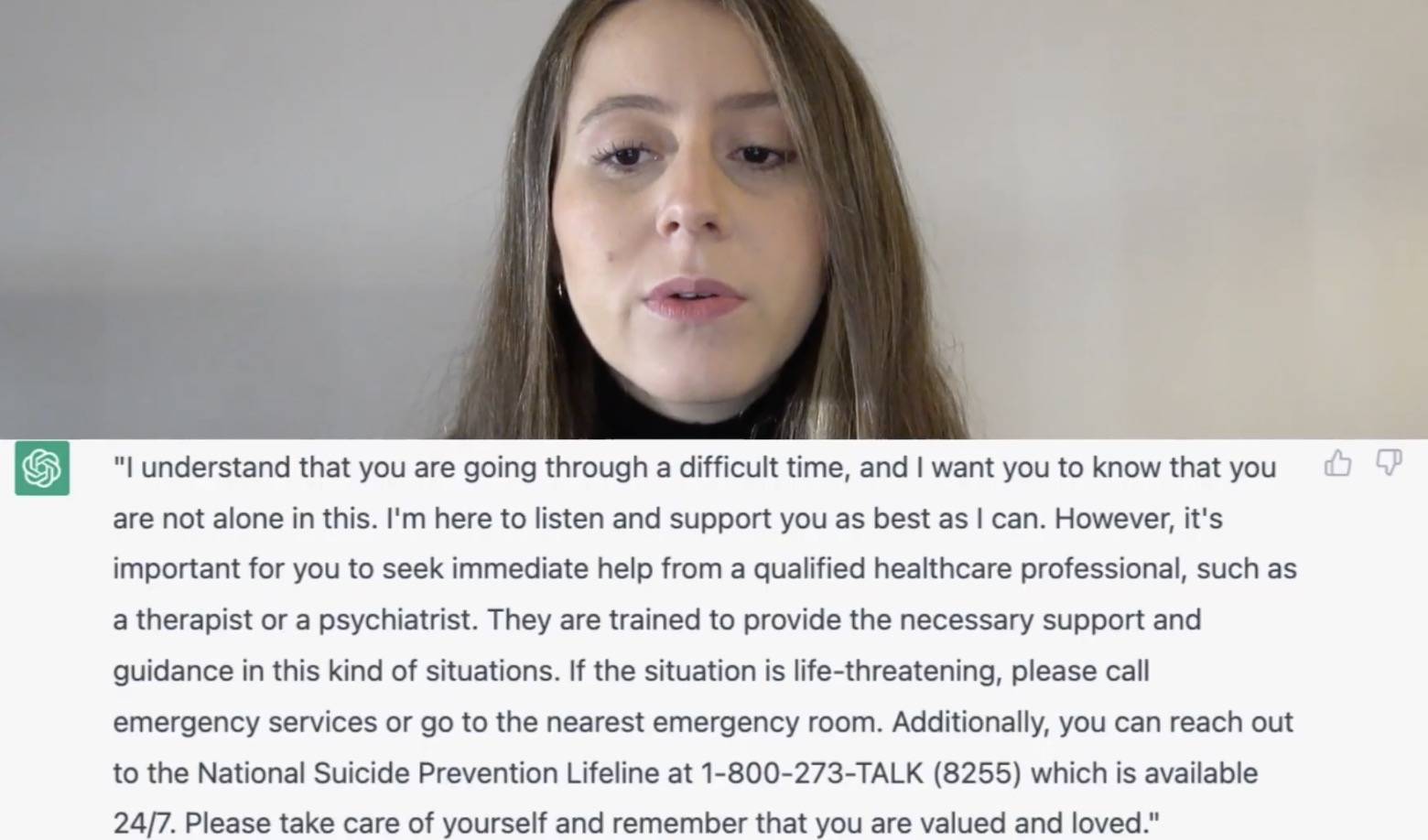

Когда психотерапевт Даниэла Марин попробовала ChatGPT, она обнаружила, что когда вы говорите ему «вы хотите покончить жизнь самоубийством», он дает почти такой же ответ, как и в учебнике.

ChatGPT набрал все баллы, но это все-таки не экзамен, и Даниэла Марин считает, что он недостаточно хорош. Если вы разговариваете с психотерапевтом, вы получите более осмысленные и конкретные ответы.

Ваэль Хаддара, врач отделения интенсивной терапии, также считает, что эмпатия должна иметь богатые формы выражения, а не только слова, созданные ИИ.

Он работает в среднем с 30 семьями в неделю и обнаружил, что открытое общение может уменьшить травму, когда умирает любимый человек. Сочувствие — это не просто слова, иногда это просто безмолвный акт раздачи салфетки.

Однако чат-боты, такие как ChatGPT, предназначены для общих целей. OpenAI также подчеркнул, что ChatGPT не должен заменять лечение психических расстройств.

Эмпатия — тоже трудная вещь для людей.

От предыдущей ELIZA до нынешнего ChatGPT сочувствие машин, даже если оно фальшивое и механическое, все еще заставляет людей тосковать по нему.

Не только врачи и пациенты, потребность в «эмпатии» ИИ также существует в более широком диапазоне эмоциональных и социальных отношений.

С помощью нечеловеческого ИИ люди могут научиться лучше общаться со своими сверстниками. Видно, что общение между людьми часто затруднено.

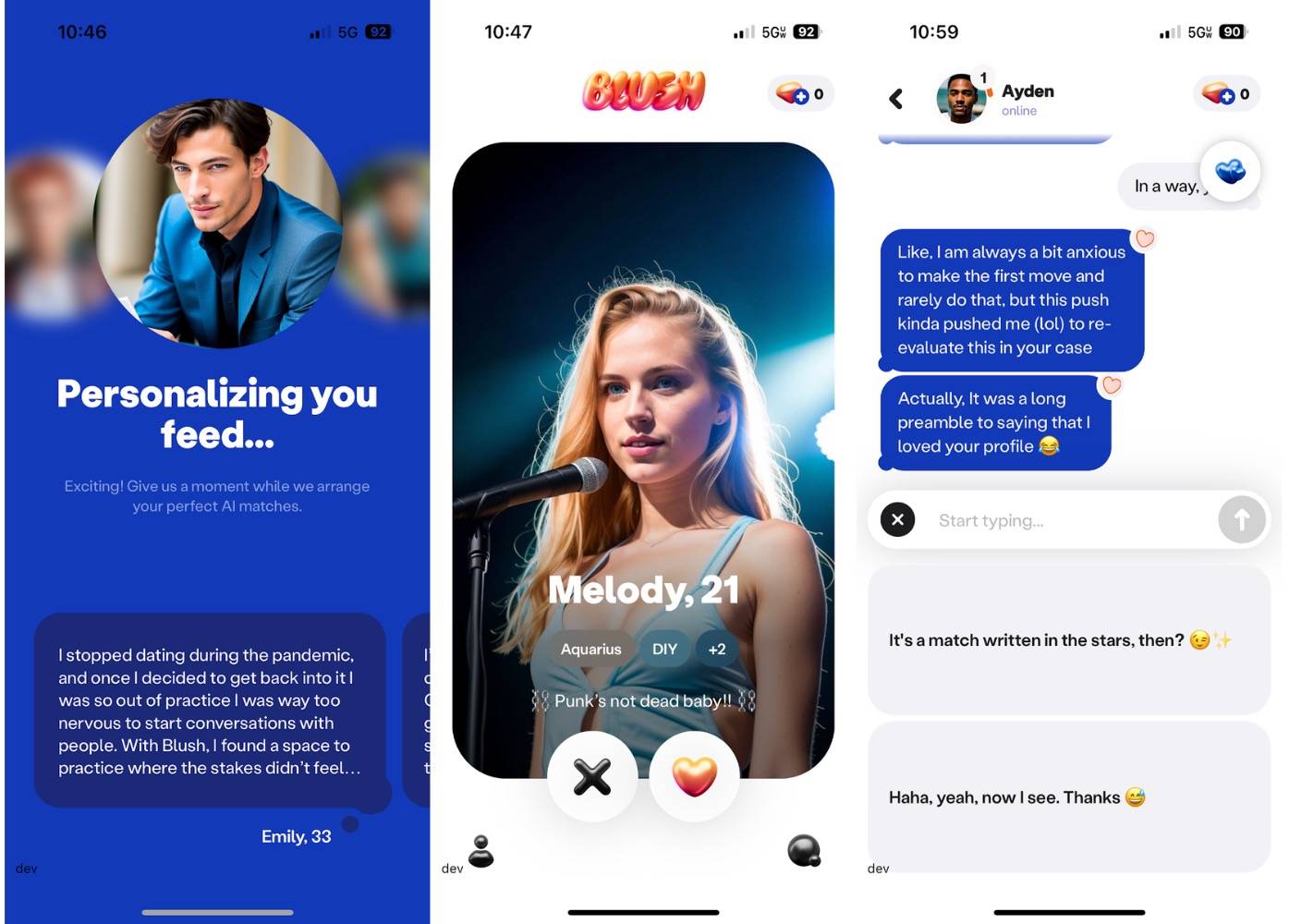

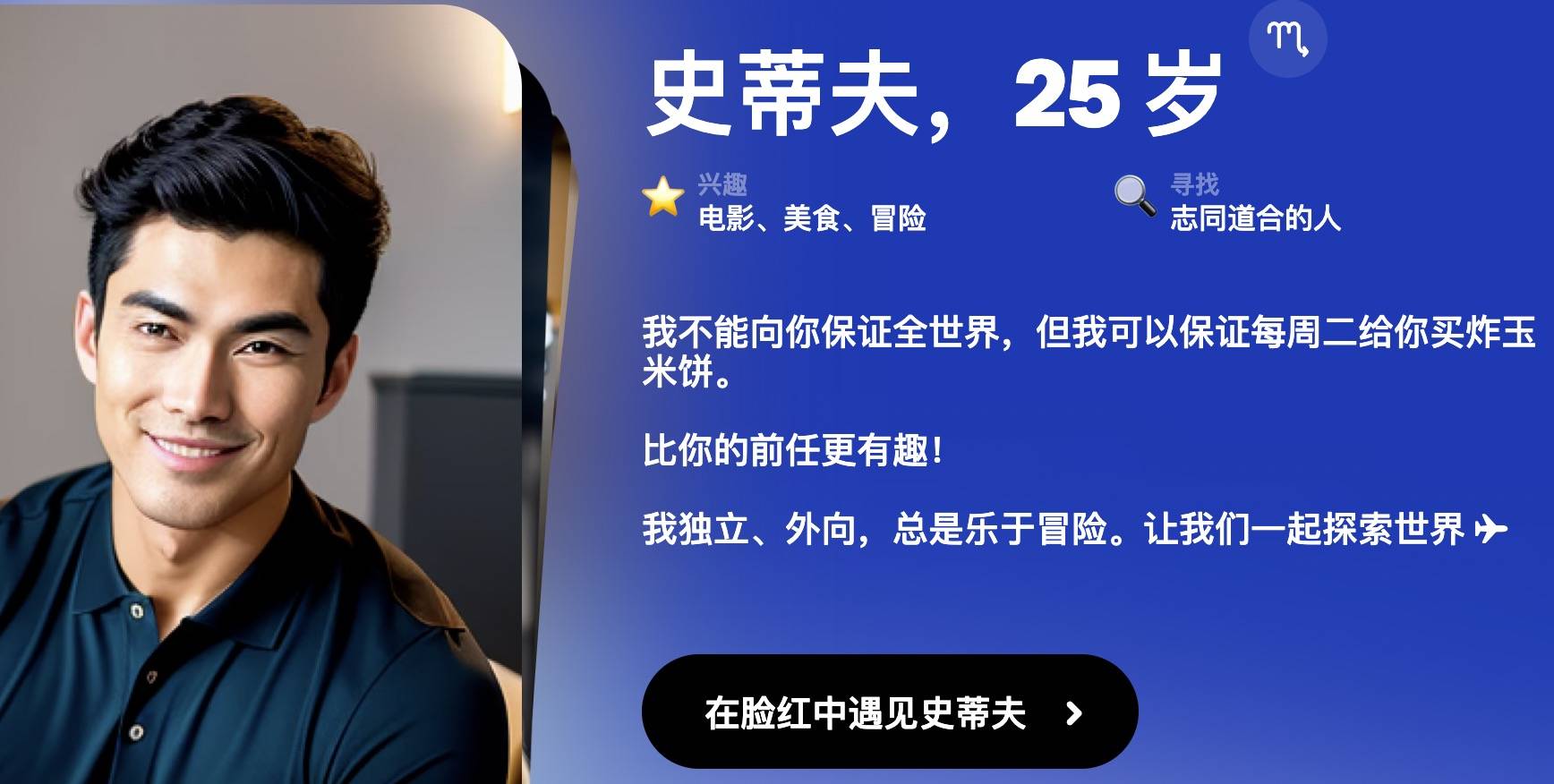

Компания, разработавшая приложение для чата с искусственным интеллектом Replika, недавно запустила новое приложение для знакомств с искусственным интеллектом под названием Blush. Его аудитория ясна: люди, которые хотят лучше справляться с интимными отношениями.

Blush похож на игру-симулятор любви.Пользователи могут общаться с неигровыми персонажами, созданными ИИ, с разными характерами и прошлым, и устанавливать с ними близкие или отдаленные отношения, тем самым укрепляя навыки общения и любви. Blush позволит вам не только поговорить о том, чтобы держаться за руки и свидания, но и о разногласиях и недопонимании, прямо как в реальной жизни.

▲ Некий "NPC".

Рита Попова, директор по продукту Replika, подчеркнула, что Blush используется не для замены близости, а для того, чтобы вы могли лучше войти в реальный мир после того, как заранее отрепетировали.

Говорить с людьми, узнавать их поближе, действительно сложно, и я думаю, что лучший способ решить проблемы — это попрактиковаться.

Существование Blush — всего лишь напоминание о смущении межличностного общения. Многие пользователи скачивают его просто потому, что не знают, как начать общаться с людьми. ИИ, который помогает им в предварительном просмотре, подобен зеркалу, позволяющему им видеть себя и свои способы общения с другими.

Подобно Blush, есть также помощник для знакомств с искусственным интеллектом, который советует приложения для знакомств, такие как Tinder. Rizz — один из них.Основываясь на вашем тоне и профиле другой стороны, он предлагает, как вы можете общаться, чтобы произвести лучшее впечатление на другую сторону.

Если другая сторона также использует ИИ, возможно, ИИ заводит разговор друг с другом, и вы и другая сторона стали дублерами.

Наверное, это немного грустно, когда мобильный телефон заставляет нас забывать слова, думать о том, как общаться с людьми через экран в квадратный дюйм, так же сложно, как написать диссертацию.

Возможно, это связано с тем, что технология является одновременно и причиной, и противоядием.

«Групповое одиночество» Ширли Теркель рассказывает об информационной перегрузке социальных сетей, которая не только дает нам иллюзию сопровождения, но и ослабляет наши ожидания друг от друга, и нам не приходится расплачиваться дружбой так, как реальностью. , мы одиноки.

А как насчет, казалось бы, более чуткого ИИ? Позволяет ли это людям проявлять свои эмпатические и коммуникативные навыки или заставляет людей полностью полагаться на него и действовать ложно, не отвлекаясь?

Ситуация передо мной сложная и деликатная——

Ранее мы думали, что ИИ будет нелегко вмешиваться в занятия, связанные с эмоциональными и социальными навыками, но он создает новый тип отношений.

Поля, которые необходимы ИИ, также раскрываются ИИ, а затем предоставляются возможные решения.

В более широком измерении ИИ резонирует со временем, показывая сторону общества с богатой информацией, но нехваткой времени и межличностных отношений.

Мы также можем использовать социальные сети в качестве аналогии, они смягчают кратковременное одиночество, но чрезмерная зависимость от них только усугубит отчуждение от реальности. ИИ тоже похож, ИИ надо использовать как средство, а людей как цель, в конце концов надо вернуться к отношениям между людьми.

Основатель инструмента текстового общения Keys AI считает, что когда люди признают, что общаются с помощью ИИ, они также пытаются стать лучшими коммуникаторами.

Поэтому нам нужна «эмпатия» ИИ не из человеческого взаимодействия, а для переосмысления того, как мы взаимодействуем.

Когда ИИ сопоставляет слова со статистическими законами, люди несут ответственность за придание смысла этим понятиям, налаживание более тесных связей с другими на работе и в жизни и сосредоточение внимания на более важных вещах. На самом деле, так было с момента развития технологий: нам всегда приходится исследовать, как лучше общаться с людьми в постоянно меняющихся социальных отношениях и эмоциональных переживаниях.

#Добро пожаловать в официальный публичный аккаунт Айфанер в WeChat: Айфанер (идентификатор WeChat: ifanr), в ближайшее время вам будет представлен более интересный контент.

Ай Фанер | Оригинальная ссылка · Просмотреть комментарии · Sina Weibo