За взрывом ChatGPT стоят те, кто помогал ему «отмыться добела»

Успех искусственного интеллекта связан не только с гениями на вершине пирамиды.

ИИ не распознает объекты и требует много данных, чтобы научиться различать черты лица и светофоры.

ИИ не отказывается от информации, полагаясь на людей, которые помогут ему устранить вредоносные части базы данных.

Когда ИИ, наконец, оказывается в центре внимания, аннотаторы данных выполняют свои монотонные, но важные обязанности, а затем исчезают во тьме.

Популярный во всем мире ChatGPT, наверное, тоже история о том, что «успеет один, а все умрут».

«Герои за кулисами» ChatGPT

Само собой разумеется, насколько мощен ChatGPT: он разговаривает с вами на естественном языке, пишет код, пишет работы, сдает экзамены и создает стихи.

По сравнению с предыдущей «искусственной умственной отсталостью», GPT-3, предшественник ChatGPT, также является большим улучшением, но у него есть проблема, заключающаяся в том, что легко выпалить насилие, сексизм и расистские высказывания, поэтому его нельзя по-настоящему популяризировать. .

С учетом уроков, извлеченных из прошлого, чтобы гарантировать, что ChatGPT будет мягким и безвредным, OpenAI создала дополнительный механизм безопасности.

▲ Изображение из: Shutterstock

Основываясь на примерах, связанных с насилием, ненавистью и сексуальным насилием, он обучает ИИ, который может обнаруживать вредоносный контент, а затем использует этот ИИ в качестве детектора, встроенного в ChatGPT, для обнаружения и фильтрации контента до того, как он попадет к пользователям.

В приведенных выше примерах необходимо пройти маркировку данных (Data labeling), что является огромным человеческим трудом, и работники в Кении несут ответственность за маркировку вредоносного контента.

С ноября 2021 года OpenAI отправил аутсорсинговой компании Sama десятки тысяч текстовых фрагментов, большинство из которых отражают самые темные уголки Интернета, связанные с сексуальными надругательствами, самоубийствами, пытками и т. д.

▲ Изображение от: Сама

У маркировщика данных начались повторяющиеся галлюцинации после прочтения неприемлемо вредного контента.

Бремя работы не было заменено превосходным обращением.

Расследование Time показало , что маркировщики данных Sama, работающие на OpenAI, зарабатывают от 1,32 до 2 долларов в час. Работая посменно по девять часов, они читали и комментировали от 150 до 250 абзацев текста от 100 до более 1000 слов каждый.

Но Сама говорит, что работники могут аннотировать 70 абзацев за девятичасовую смену, а не максимум 250, и зарабатывать от 1,46 до 3,74 доллара в час после вычета налогов.

Sama также описывает себя как «этическую компанию искусственного интеллекта», которая вытащила из бедности более 50 000 человек.

Если быть нравственным означает помогать выбраться из бедности, то, может быть, в этом нет ничего плохого, ведь у этих бедных рабочих больше нет выбора.

Но «побочные эффекты» подобны тени, а физические и душевные пытки стали необходимой ценой.

В связи с тем, что у Sama крайне высокие требования к эффективности работы сотрудников, в компании крайне редко проводятся психологические консультации, не говоря уже о том, что сами по себе эти мероприятия бесполезны. Некоторые сотрудники предлагали консультации один на один, но руководство Sama неоднократно отказывалось.

OpenAI также ответила иностранным СМИ Quartz, что они платят почти в два раза больше, чем другие компании по обзору контента в Восточной Африке, и обеспечивают сотрудников льготами и пенсиями.

Хотя стороны имеют разные мнения, основные факты не отличаются.

Чтобы сделать ИИ более безопасным и сделать общий ИИ OpenAI полезным для человечества, большое количество рабочих заплатили много энергии и даже получили травму. Но когда OpenAI оценили почти в 30 миллиардов долларов, о них почти ничего не знали.

терминальные капилляры

Маркировщики данных — не новая работа.

Еще в 2007 году эксперт по компьютерному зрению Фей-Фей Ли нанял группу студентов из Принстона для экспериментов с маркировкой данных за 10 долларов в час.

Сегодня маркировка данных уже превратилась в индустрию, но зарплата значительно снизилась, а главные действующие лица уже не студенты.

Примерно в 2019 году некоторые СМИ сообщали о внутренних маркировщиках данных, которые были разбросаны по городам четвертого и пятого уровня в Хэнани, Шаньдуне, Хэбэе и других местах.

Точно так же штаб-квартира Sama находится в Сан-Франциско, а ее сотрудники работают в Кении, Уганде и Индии. Помимо OpenAI, он также маркирует данные для клиентов Силиконовой долины, таких как Google, Meta и Microsoft.

Однако в последние два года Сама решил «умыть руки в золотом тазу».

В феврале 2022 года Сама решил прекратить сотрудничество с OpenAI. Сотрудникам больше не приходится терпеть боль, но и средства к существованию также сложно поддерживать. «Для нас это способ поддержать нашу семью».

В январе этого года отношение Самы было еще более решительным: он планировал бросить всю работу по обработке естественного языка и анализу контента, заниматься только аннотированием данных компьютерного зрения и расстаться со всеми предприятиями, связанными с конфиденциальным контентом, включая расторжение контракта с Meta в Восточная Африка.

Сотрудники Sama, которые работают на Meta в своем офисе в Найроби в Африке, сосредоточены на просмотре местного контента, обезглавливании, жестоком обращении с детьми и т. д. — это больше, чем они могут вынести. Один сотрудник описал просмотр содержания изображений как «жизнь в фильме ужасов».

Где есть спрос, там и рынок, и недостатка в таких аутсорсинговых компаниях никогда не бывает.

Сообщается, что Majorel, аутсорсинговая компания из Люксембурга, отвечающая за услуги модерации TikTok в Африке, возьмет на себя работу Meta.

Компания также подверглась критике. В августе 2022 года Insider исследовал ситуацию в Мажореле, Марокко, и обнаружил, что рабочие часто работали посменно более 12 часов, отмечали короткие видеоролики, связанные с жестоким обращением с животными, сексуальным насилием и т. д., и имели меньше времени на отдых, чем их американские коллеги. Консультант по здоровью компании помог Ничего не делать.

Как капилляры в конце цепочки технологической отрасли, аннотации данных появляются в большем количестве мест.

В ноябре 2022 года The Verge сообщила , что Amazon наняла работников в Индии и Коста-Рике, которые отвечают за просмотр тысяч видео со складских камер для улучшения системы компьютерного зрения Amazon.

▲ Фото из: Рейтер.

Но от того, что они смотрели на него в течение как минимум восьми часов, у них развилась головная боль, боль в глазах и потеря зрения.

Самоуправляемые автомобили также нуждаются в маркировке данных, чтобы научиться распознавать дорожные знаки, транспортные средства, пешеходов, деревья и мусорные баки, что требует еще более высокой точности маркировки, поскольку может напрямую определять жизнь и смерть людей.

Расследование MIT Technology Review, проведенное в апреле 2022 года, показало, что у компаний, занимающихся беспилотным вождением, включая Tesla, были венесуэльские рабочие, которые комментировали данные о беспилотном вождении за среднюю заработную плату чуть более 90 центов в час.

По крайней мере, на данный момент база данных все еще нуждается в очистке человеком, а распознавание карты ИИ все еще нуждается в людях для рисования кадра. Проблема в том, что по сравнению с той энергией, которую они вкладывают, лечение и психическое здоровье рабочих не так уж идеальны.

те, кто становится все более и более маргинальным

С момента рождения ChatGPT многие люди беспокоились о своей работе, и это может быть очень специфическим ощущением кризиса.

В то же время отношения между ИИ и людьми претерпели тонкие изменения в другом измерении — они изменили способ работы людей и типы существующих рабочих мест, позволив большому количеству рабочих спрятаться за кулисами.

Например, специалисты по маркировке данных, чей служебный порог невысок, часто не предъявляют жестких академических требований и могут быть приняты на работу после нескольких дней обучения. Если вы знаете, что и где отмечать , вы, по сути, только начинаете, а остальное время остается на практику, доведенную до совершенства.

Часто это не обычные сотрудники, а аутсорсинговые формы, такие как кенийские работники, обслуживающие OpenAI.

Это означает, что они живут в более нестабильном мире, с более низкой оплатой, более маргинальным статусом и меньшим голосом на рабочем месте, просто следуя их примеру. Как далеко зайдет ИИ, они могут не знать.

В 2018 году в отчете GQ в разделе «Те, кто работает над искусственным интеллектом» упоминается: «У нас нет возможностей для исследований и разработок, и мы являемся чисто (литейным) Foxconn».

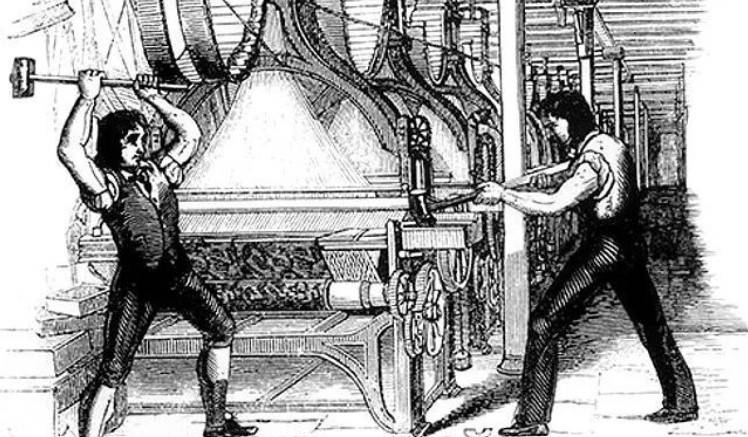

▲ Луддитское движение.

Подобные ситуации были в истории. В Великобритании в начале 19 века автоматические текстильные машины стали популярными, и фабрики предпочли нанимать дешевую неквалифицированную рабочую силу для работы на машинах, что привело к безработице многих квалифицированных рабочих.

Колесо времени продолжает двигаться вперед, и ИИ постепенно заменяет маркировщиков данных, обслуживающих ИИ.

В июне 2022 года Tesla планирует уволить 200 сотрудников из США , которые отвечают за аннотирование видео и помощь в улучшении систем помощи водителю. Причина может заключаться в том, что в последние годы автоматизированная маркировка данных Tesla продвинулась вперед, что может заменить часть работы, выполняемой людьми.

Директор по программному обеспечению Tesla Autopilot однажды сказал на AI Day, что компания может собирать и автоматически маркировать 10 000 видеоклипов продолжительностью от 45 до 60 секунд в неделю. Напротив, «маркировка каждого сегмента вручную может занять месяцы».

В 2020 году Всемирный экономический форум прогнозировал , что к 2025 году 85 миллионов рабочих мест будут заменены машинами, и будет создано 97 миллионов новых рабочих мест.

Позиции, в отношении которых они настроены оптимистично, — это в основном технические таланты, такие как специалисты по искусственному интеллекту и машинному обучению, эксперты по цифровым преобразованиям и аналитики по информационной безопасности.

Напротив, низкодоходные и низкоквалифицированные профессии постепенно уходят со сцены и могут в конечном итоге исчезнуть в тени машин.

#Добро пожаловать, обратите внимание на официальный публичный аккаунт Айфанер в WeChat: Айфанер (идентификатор WeChat: ifanr), более интересный контент будет представлен вам как можно скорее.

Ай Фанер | Оригинальная ссылка · Просмотреть комментарии · Sina Weibo