Как загрузить весь веб-сайт для чтения в автономном режиме

Хотя в наши дни Wi-Fi доступен повсюду, время от времени вы можете оказаться без него. И когда вы это сделаете, могут быть веб-сайты, которые вы хотели бы сохранить, чтобы у вас был доступ к ним в автономном режиме – возможно, для исследований, развлечений или просто для потомков.

Сохранять отдельные веб-страницы для чтения в автономном режиме довольно просто, но что, если вы хотите загрузить весь веб-сайт? Не волнуйтесь, это проще, чем вы думаете. Но не верьте нам на слово. Вот несколько изящных инструментов, которые можно использовать для загрузки любого веб-сайта для чтения в автономном режиме – без каких-либо проблем.

1. WebCopy

WebCopy от Cyotek берет URL-адрес веб-сайта и сканирует его на наличие ссылок, страниц и мультимедиа. При нахождении страниц он рекурсивно ищет больше ссылок, страниц и мультимедиа, пока не будет обнаружен весь веб-сайт. Затем вы можете использовать параметры конфигурации, чтобы решить, какие части загружать в автономном режиме.

В WebCopy интересно то, что вы можете создать несколько проектов, каждый из которых имеет свои собственные настройки и конфигурации. Это упрощает повторную загрузку множества сайтов в любое время и каждый раз одинаково точно.

Один проект может копировать множество веб-сайтов, поэтому используйте их с упорядоченным планом (например, «Технический» проект для копирования технических сайтов).

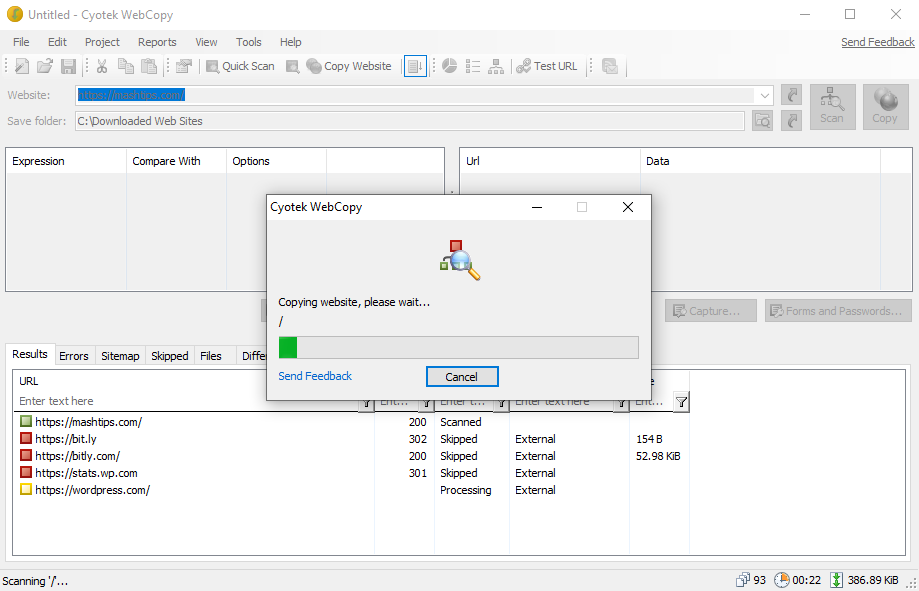

Как загрузить весь сайт с помощью WebCopy

- Установите и запустите приложение.

- Перейдите в File> New, чтобы создать новый проект.

- Введите URL-адрес в поле Веб-сайт .

- Измените поле « Сохранить папку» на то место, где вы хотите сохранить сайт.

- Поэкспериментируйте с Project> Rules… ( узнайте больше о правилах WebCopy ).

- Перейдите в меню «Файл»> «Сохранить как…», чтобы сохранить проект.

- Щелкните Копировать на панели инструментов, чтобы начать процесс.

После завершения копирования вы можете использовать вкладку « Результаты », чтобы увидеть статус каждой отдельной страницы и / или медиафайла. На вкладке « Ошибки » отображаются все проблемы, которые могли возникнуть, а на вкладке « Пропущенные » показаны файлы, которые не были загружены.

Но наиболее важным является карта сайта , которая показывает полную структуру каталогов веб-сайта, обнаруженную с помощью WebCopy.

Чтобы просмотреть веб-сайт в автономном режиме, откройте проводник и перейдите в указанную вами папку для сохранения. Откройте index.html (или иногда index.htm ) в любом браузере, чтобы начать просмотр.

Скачать: WebCopy дляWindows (бесплатно)

2. HTTrack

HTTrack более известен, чем WebCopy, и, возможно, лучше, потому что он имеет открытый исходный код и доступен на платформах, отличных от Windows. Интерфейс немного неуклюжий и оставляет желать лучшего, однако работает хорошо, так что пусть это вас не отпугнет.

Как и WebCopy, он использует проектный подход, который позволяет копировать несколько веб-сайтов и сохранять их все организованными. Вы можете приостанавливать и возобновлять загрузку, а также обновлять скопированные веб-сайты, повторно загружая старые и новые файлы.

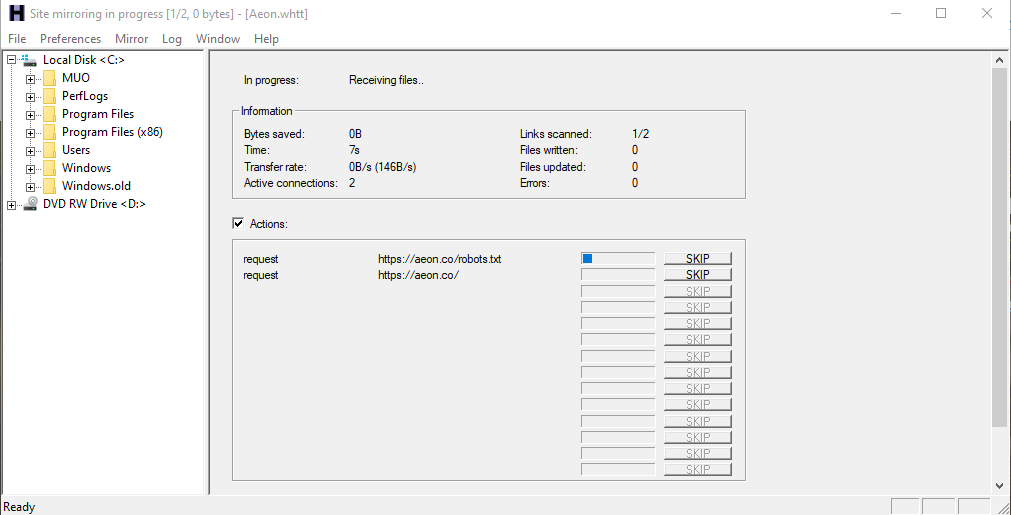

Как загрузить полный сайт с HTTrack

- Установите и запустите приложение.

- Щелкните Далее, чтобы начать создание нового проекта.

- Дайте проекту имя, категорию, базовый путь, затем нажмите Далее .

- Выберите « Загрузить веб-сайты» для «Действие», затем введите URL- адреса каждого веб-сайта в поле « Веб-адреса» , по одному URL-адресу в каждой строке. Вы также можете сохранить URL-адреса в файле TXT и импортировать его, что удобно, если вы хотите повторно загрузить те же сайты позже. Щелкните Далее .

- Если хотите, настройте параметры, затем нажмите « Готово» .

Как только все будет загружено, вы можете просматривать сайт как обычно, перейдя туда, где были загружены файлы, и открыв index.html или index.htm в браузере.

Как использовать HTTrack с Linux

Если вы пользователь Ubuntu, вот как вы можете использовать HTTrack для сохранения всего веб-сайта:

- Запустите Терминал и введите следующую команду:

sudo apt-get install httrack - Он запросит ваш пароль Ubuntu (если вы его установили). Введите его и нажмите Enter . Терминал загрузит инструмент через несколько минут.

- Наконец, введите эту команду и нажмите Enter . Для этого примера мы загрузили популярный веб-сайт Brain Pickings .

httrack https://www.brainpickings.org/ - Это загрузит весь веб-сайт для чтения в автономном режиме.

Вы можете заменить здесь URL-адрес веб-сайта на URL-адрес любого веб-сайта, который вы хотите загрузить. Например, если вы хотите загрузить всю Британскую энциклопедию, вам придется настроить свою команду на это:

httrack https://www.britannica.com/Скачать: HTTrack для Windows и Linux | Android (бесплатно)

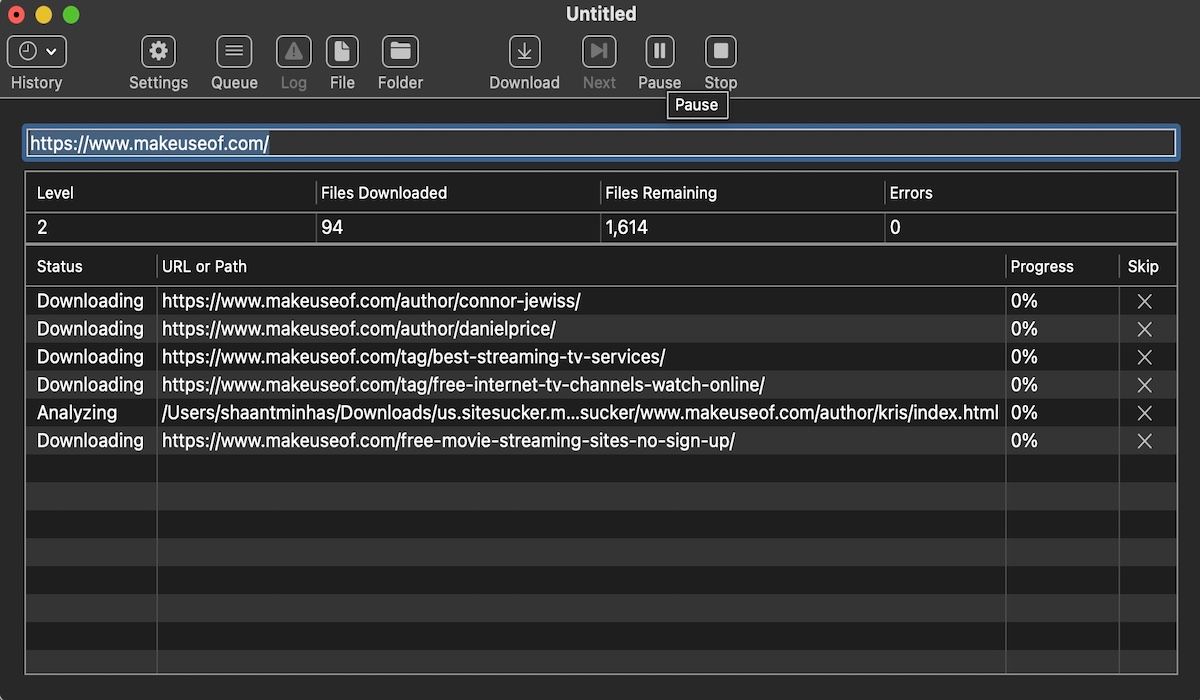

3.SiteSucker

Если вы используете Mac, ваш лучший вариант – SiteSucker . Этот простой инструмент копирует веб-сайты целиком, поддерживает ту же структуру, а также включает все соответствующие файлы мультимедиа (например, изображения, PDF-файлы, таблицы стилей).

У него чистый и простой в использовании интерфейс – вы буквально вставляете URL-адрес веб-сайта и нажимаете Enter .

Одна из замечательных функций – это возможность сохранить загрузку в файл, а затем использовать этот файл для загрузки тех же файлов и структуры снова в будущем (или на другом компьютере). Эта функция также позволяет SiteSucker приостанавливать и возобновлять загрузки.

SiteSucker стоит около 5 долларов и не поставляется с бесплатной версией или бесплатной пробной версией, что является его самым большим недостатком. Для последней версии требуется macOS 11 Big Sur или выше. Старые версии SiteSucker доступны для старых систем Mac, но некоторые функции могут отсутствовать.

Скачать : SiteSucker для iOS | Mac (4,99 доллара США)

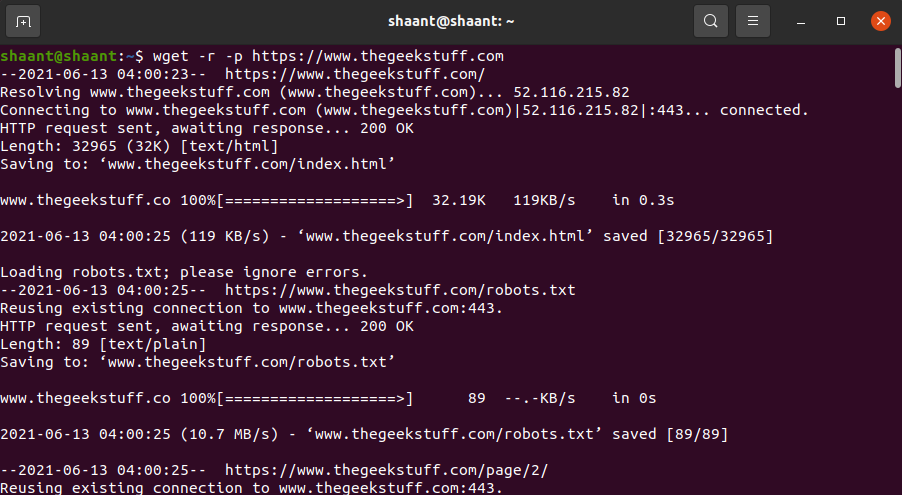

4. Wget

Wget – это утилита командной строки, которая может получать все типы файлов по протоколам HTTP и FTP. Поскольку веб-сайты обслуживаются через HTTP, а большинство файлов веб-мультимедиа доступны через HTTP или FTP, это делает Wget отличным инструментом для загрузки целых веб-сайтов.

Wget входит в состав большинства систем на базе Unix. Хотя Wget обычно используется для загрузки отдельных файлов, его также можно использовать для рекурсивной загрузки всех страниц и файлов, найденных на начальной странице:

wget -r -p https://www.makeuseof.comВ зависимости от размера загрузка всего веб-сайта может занять некоторое время.

Однако некоторые сайты могут обнаруживать и предотвращать то, что вы пытаетесь сделать, потому что копирование веб-сайта может стоить им большой пропускной способности. Чтобы обойти это, вы можете замаскироваться под веб-браузер с помощью строки пользовательского агента:

wget -r -p -U Mozilla https://www.thegeekstuff.comЕсли вы хотите быть вежливым, вам также следует ограничить скорость загрузки (чтобы не перегружать полосу пропускания веб-сервера) и делать паузу между каждой загрузкой (чтобы не перегружать веб-сервер слишком большим количеством запросов):

wget -r -p -U Mozilla --wait=10 --limit-rate=35K https://www.thegeekstuff.comКак использовать Wget на Mac

На Mac вы можете установить Wget с помощью одной команды Homebrew: brew install wget .

- Если у вас еще не установлен Homebrew, загрузите его с помощью этой команды:

/usr/bin/ruby -e "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/master/install)" - Затем установите Wget с помощью этой команды:

brew install wget - После завершения установки Wget вы можете загрузить сайт с помощью этой команды:

wget path/to/local.copy http://www.brainpickings.org/

В Windows вам нужно будет использовать эту портированную версию . Загрузите и установите приложение и следуйте инструкциям, чтобы завершить загрузку сайта.

Легко загружать целые сайты

Теперь, когда вы знаете, как загрузить веб-сайт целиком, вас никогда не поймают без чего-либо для чтения, даже если у вас нет доступа в Интернет. Но помните: чем больше размер сайта, тем больше загрузка. Мы не рекомендуем загружать крупные сайты, такие как MUO, потому что вам понадобятся тысячи МБ для хранения всех медиа-файлов, которые мы используем.