Не позволяйте GPT-4 снова развиваться! Маск первым подписал совместное письмо тысяч людей, настоятельно призывающее лаборатории ИИ немедленно приостановить исследования.

До сих пор мы пережили множество цифровых революций, в том числе появление графических интерфейсов, рождение Интернета и популяризацию мобильного Интернета, но ни одно технологическое изменение не вызывало такой массовой паники, как волна ИИ, вызванная GPT. модель.

С одной стороны, ИИ изменил то, как люди работают и живут, значительно повысив эффективность, с другой стороны, работа и развитие ИИ полны неопределенностей, что запускает естественный механизм защиты человека от неизвестного — страх.

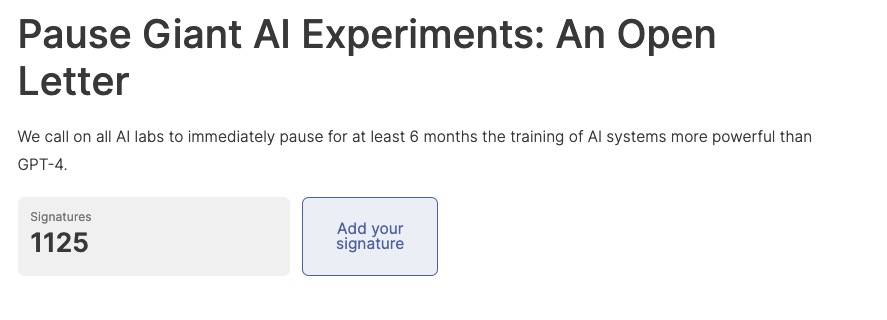

Сегодня в Интернете взорвалось публичное совместное письмо, призывающее ко всем экспериментам с ИИ немедленно приостановить исследования моделей ИИ более совершенных, чем ГПТ-4, как минимум на 6 месяцев, чтобы в будущем убить эти ужасные фантазии.

Скорость прогресса ИИ поражает, но соответствующие методы надзора и аудита не поспевают за ними, а это значит, что никто не может гарантировать безопасность инструментов ИИ и самого процесса использования инструментов ИИ.

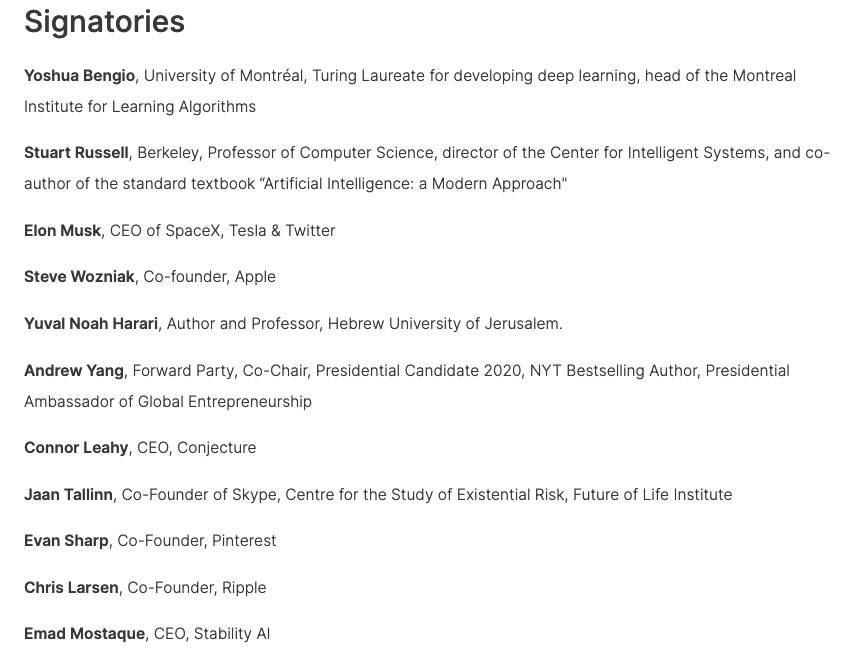

Совместное письмо было поддержано многими известными личностями, включая лауреата премии Тьюринга 2018 года Йошуа Бенжио, Маска, Стива Возняка, соучредителя Skype, соучредителя Pinterest, генерального директора Stability AI и т. д. достиг 1125 до крайнего срока.

Первоначальный текст открытого письма выглядит следующим образом:

Искусственный интеллект обладает интеллектом, способным конкурировать с людьми, что может представлять серьезные риски для общества и людей, что подтверждено большим количеством исследований [1] и признано ведущими лабораториями искусственного интеллекта [2]. Как говорится в широко признанных Принципах искусственного интеллекта Asilomar, передовой искусственный интеллект может представлять собой серьезную трансформацию в истории жизни на Земле, и поэтому его планирование и управление должны осуществляться с соответствующим вниманием и ресурсами.

К сожалению, даже в последние месяцы лаборатории искусственного интеллекта были вовлечены в безудержную гонку по разработке и развертыванию все более мощных цифровых умов, которые никто не может понять, предсказать или надежно контролировать, даже если они сами создатели не могли этого сделать.

Теперь, когда современные системы искусственного интеллекта конкурируют с людьми в выполнении общих задач [3], мы должны задать себе вопрос:

- Должны ли мы позволять машинам наводнять наши информационные каналы, распространяя пропаганду и ложь?

- Должны ли мы автоматизировать все работы, включая те, которые приносят удовлетворение?

- Должны ли мы развивать нечеловеческие умы, которые в конечном итоге могут превзойти и заменить нас?

- Стоит ли рисковать, выходя из-под контроля цивилизации?

Эти решения не должны приниматься неизбранными лидерами технологий. Только когда мы уверены, что влияние системы ИИ положительно, а риски управляемы, мы должны разрабатывать мощные системы ИИ. Эта уверенность должна быть обоснованной и расти вместе с потенциальным воздействием системы. В недавнем заявлении OpenAI об искусственном интеллекте говорится, что «в какой-то момент может возникнуть необходимость получить независимую оценку, прежде чем начинать обучение будущих систем, а также для современных усилий договориться об ограничении скорости роста вычислений, используемых для создания новые модели." Мы согласны. Сейчас тот самый момент.

Поэтому мы призываем к немедленному мораторию на все лаборатории ИИ сроком не менее 6 месяцев на обучение систем ИИ, более мощных, чем GPT-4. Эта приостановка должна быть общедоступной и поддающейся проверке, и в ней должны участвовать все ключевые игроки. Если такой мораторий не может быть введен быстро, правительство должно вмешаться и ввести мораторий.

Лаборатории ИИ и независимые эксперты должны использовать эту паузу для совместной работы над разработкой и внедрением общего набора усовершенствованных протоколов безопасности проектирования и разработки ИИ, которые должны тщательно проверяться и контролироваться независимыми внешними экспертами.

Эти протоколы должны гарантировать, что системы, придерживающиеся их, безопасны без разумных сомнений [4]. Это не означает приостановку разработки ИИ, а просто делает шаг назад от всегда опасной гонки к более крупным, непредсказуемым моделям черного ящика и их новым возможностям.

Исследования и разработки в области искусственного интеллекта должны быть направлены на повышение точности, безопасности, объяснимости, прозрачности, надежности, согласованности, надежности и лояльности существующих надежных, передовых систем.

В то же время разработчики ИИ должны работать с политиками, чтобы значительно ускорить разработку систем управления ИИ. Они должны как минимум включать:

- Новый компетентный регулирующий орган, занимающийся ИИ;

- Надзор и отслеживание высокопроизводительных систем искусственного интеллекта и больших пулов вычислительной мощности;

- Системы провенанса и водяных знаков для отличия реального контента от синтетического, отслеживания утечек моделей;

- Надежная экосистема аудита и сертификации, ответственность за ущерб, причиненный ИИ;

- Адекватное государственное финансирование технических исследований безопасности ИИ;

- Учреждение-ветеран, занимающееся массовыми экономическими и политическими изменениями, которые вызовет ИИ, особенно последствиями для демократий.

Человечество может наслаждаться процветающим будущим с помощью ИИ. Добившись успеха в создании мощных систем ИИ, мы теперь можем наслаждаться «летом ИИ», в течение которого мы пожинаем плоды использования этих систем на благо всех и предоставления обществу возможности адаптироваться.

Общество нажало на кнопку паузы перед лицом других технологий, которые могут иметь катастрофические последствия для общества [5]. Здесь мы можем сделать то же самое. Давайте насладимся долгим ИИ-летом вместо того, чтобы бросаться в осень неподготовленными.

Информационно-справочная:

[1]

Бендер, Э.М., Гебру, Т., Макмиллан-Мейджор, А., и Шмитчелл, С. (2021, март) Об опасностях стохастических попугаев: могут ли языковые модели быть слишком большими?, В материалах конференции ACM 2021 года о справедливости, подотчетности и прозрачности (стр. 610-623).

Бостром, Н. (2016).Сверхразум.Издательство Оксфордского университета.

Бакналл, Б.С., и Дори-Хакоэн, С. (2022, июль). Текущий и ближайший ИИ как потенциальный фактор экзистенциального риска. В материалах конференции AAAI/ACM 2022 года по ИИ, этике и обществу (стр. 119). -129).

Карлсмит Дж. (2022 г.) Является ли стремящийся к власти ИИ экзистенциальным риском?, Препринт arXiv arXiv: 2206.13353.

Кристиан Б. (2020 г.) Проблема выравнивания: машинное обучение и человеческие ценности, Norton & Company.

Коэн, М. и др. (2022).Усовершенствованные искусственные агенты вмешиваются в предоставление вознаграждения.Журнал AI, 43(3) (стр. 282-293).

Элунду Т. и др. (2023 г.) ТШП — это ТШП: ранний взгляд на потенциал воздействия моделей больших языков на рынок труда.

Хендрикс Д. и Мазейка М. (2022 г.) Анализ X-рисков для исследований ИИ, Препринт arXiv arXiv: 2206.05862.

Нго, Р. (2022).Проблема выравнивания с точки зрения глубокого обучения.Препринт arXiv arXiv:2209.00626.

Рассел С. (2019 г.) Совместимость с человеком: искусственный интеллект и проблема контроля // Викинг.

Тегмарк М. (2017 г.) Жизнь 3.0: Быть человеком в эпоху искусственного интеллекта // Кнопф.

Вайдингер, Л. и др. (2021) Этические и социальные риски причинения вреда языковыми моделями, препринт arXiv arXiv: 2112.04359.

[2]

Ордонез, В. и др. (2023, 16 марта).Генеральный директор OpenAI Сэм Альтман говорит, что ИИ изменит общество, признает риски: «Немного боится этого».ABC News.

Перриго Б. (12 января 2023 г.) Генеральный директор DeepMind Демис Хассабис призывает к осторожности в отношении ИИ. Время.

[3]

Бубек С. и др. (2023) Искры общего искусственного интеллекта: ранние эксперименты с GPT-4, arXiv:2303.12712.

OpenAI (2023).Технический отчет GPT-4.arXiv:2303.08774.

[4]

Существует множество юридических прецедентов — например, широко принятые Принципы ИИ ОЭСР требуют, чтобы системы ИИ «функционировали должным образом и не представляли необоснованного риска для безопасности».

[5]

Примеры включают клонирование человека, модификацию зародышевой линии человека, исследования по увеличению функции и евгенику.

В этом открытом письме прикрепленная форма подписи может быть более захватывающей, чем само содержание письма.Вы можете найти здесь много знакомых имен, и каждая подпись выражает сильный скептицизм подписавшего по отношению к ИИ.

Однако некоторые пользователи сети обнаружили, что эти подписи не могут быть полностью достоверными, потому что в списке появились имена генерального директора OpenAI Сэма Альтмана (я запечатал себя?) и актера Джона Уика из фильма «Быстрая погоня». изучаться.

Адрес этого совместного письма прилагается ниже, и заинтересованные друзья также могут подписаться своими именами.

Приостановить гигантские эксперименты с искусственным интеллектом: открытое письмо

#Добро пожаловать, обратите внимание на официальный публичный аккаунт Айфанер в WeChat: Айфанер (идентификатор WeChat: ifanr), более интересный контент будет представлен вам как можно скорее.

Ай Фанер | Оригинальная ссылка · Просмотреть комментарии · Sina Weibo