Отечественная «маленькая стальная пушка», за ночь перевернувшая GPT-4V, может стать ключевым оружием Huawei и Xiaomi в борьбе с ИИ iPhone

Сколько шагов нужно, чтобы поместить большую модель в мобильный телефон?

Если 2023 год станет первым годом бурного развития генеративного искусственного интеллекта, то в этом году различные производители достигли редкого консенсуса — полностью сделав ставку на большие конечные модели.

Будучи новой компанией в области искусственного интеллекта, специализирующейся на «эффективных больших моделях», Wallface Intelligence сегодня снова демонстрирует свои силы, запуская самую мощную конечную мультимодальную модель с открытым исходным кодом MiniCPM-Llama3-V 2.5.

- Самая высокая мультимодальная комплексная производительность на конечной стороне: превосходство мультимодальных гигантов Gemini Pro и GPT-4V

- Возможности оптического распознавания символов SOTA! Пиксели в 9 раз четче, что затрудняет точное распознавание длинных изображений и длинного текста.

- Кодирование изображений происходит в 150 раз быстрее! Первое мультимодальное ускорение на уровне системы

Третья пуля отечественной «малой стальной пушки» уже здесь, превосходящая ГПТ-4В

Подобно тому, как люди полагаются на свои пять чувств при исследовании мира, мультимодальные возможности являются обязательным курсом в эволюции ИИ.

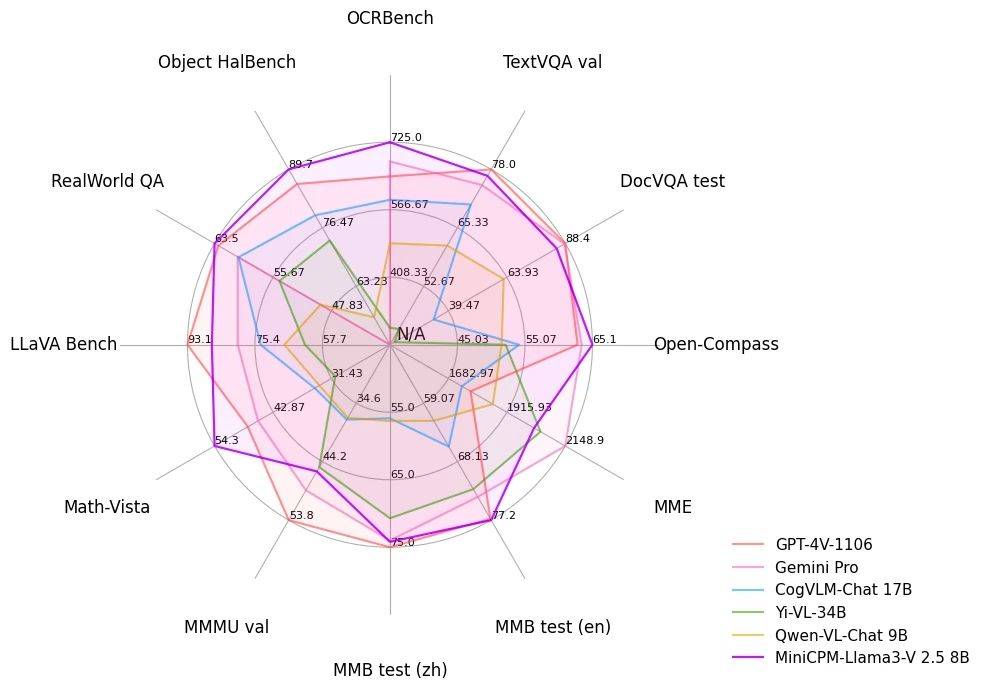

Имея только конечную модель 8B, MiniCPM-Llama3-V 2.5, которая представляет собой «большое с маленьким», набрала 65,1 балла на оценочной платформе OpenCompass. Она не только сравнима с моделью с закрытым исходным кодом Qwen-VL-Max, но и с ней. общая производительность также превосходит тяжеловесов GPT-4V и Gemini Pro.

В комплексном тесте OCR (оптическое распознавание символов) MiniCPM-Llama3-V 2.5 набрал 725 баллов, значительно превзойдя GPT-4V и превзойдя такие модели-чехарды, как Claude 3V Opus.

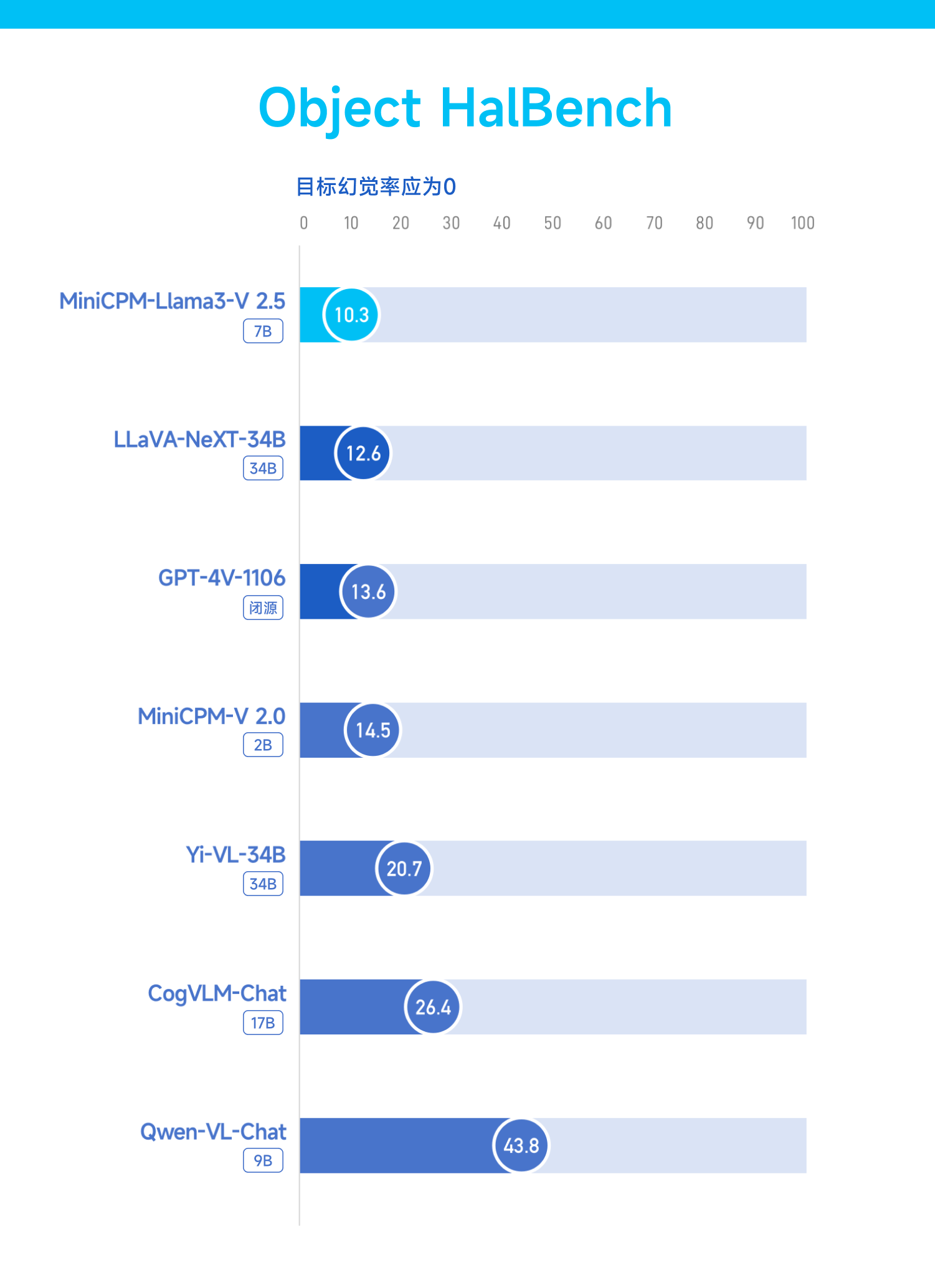

Способность галлюцинировать — самая большая и упорная проблема, с которой сталкиваются большие модели за короткий период времени. MiniCPM-Llama3-V 2.5 также улучшил эту проблему.

Как показал тест Object HalBench, уровень галлюцинаций резко снизился с 14,5 в MiniCPM-V 2.0 (2B) до 10,3, снова превзойдя GPT-4 V и LLaVA-NeXT-34B.

Тест RealWorldQA — это проверка понимания модели реальности.

MiniCPM-Llama3-V 2.5 показал лист ответов 63,5, уступая только InternVL-Chat-V1.5 (26B), но все же превзойдя GPT-4V и Gemini Pro.

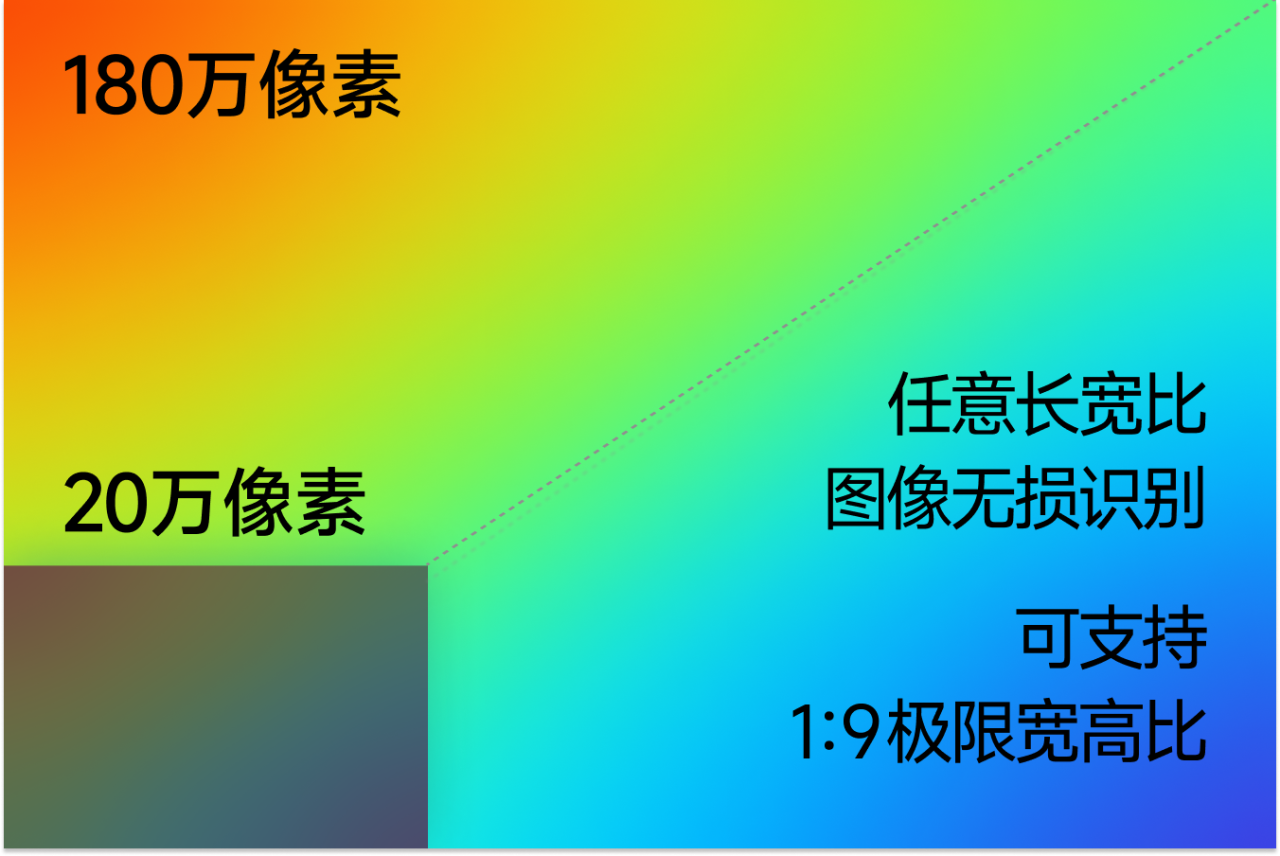

Опираясь на собственную разработанную технологию эффективного кодирования изображений высокой четкости, MiniCPM-Llama3-V 2.5 поддерживает эффективное кодирование и распознавание без потерь 1,8 миллиона изображений высокой четкости, а также поддерживает любое соотношение сторон, даже изображения с экстремальным соотношением 1:9. Для этого это просто кусок пирога.

«Уметь видеть» — это только начало, что еще важнее — уметь «думать». MiniCPM-Llama3-V 2.5 выводит сложные логические способности на новый уровень.

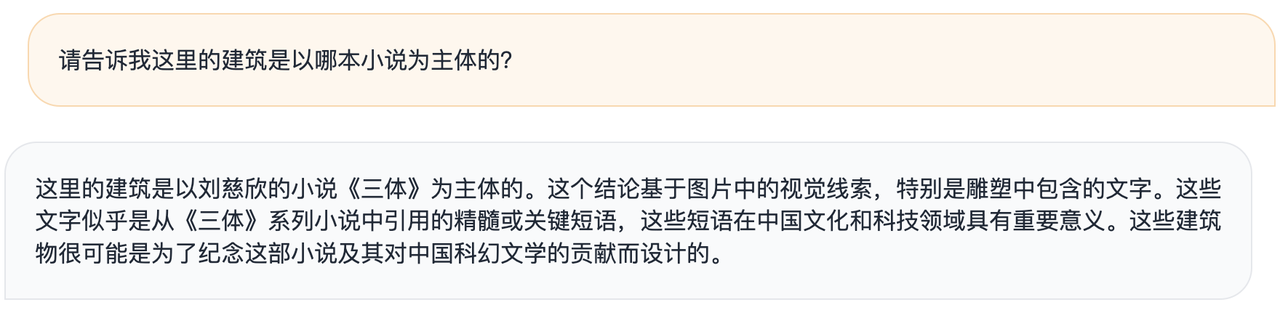

Официальные лица заявили, что на примере художественного здания, на котором выгравированы знаменитые цитаты из «Задачи трех тел», общая большая модель может лишь примерно описать модель изображения, но MiniCPM-Llama3-V 2.5 может связать ее с «Задачей трех тел». Задача трех тел» на основе общепризнанных сведений. кн.

▲MiniCPM-Llama3-V 2.5

▲ГПт-4В

Вы также можете высказать свое мнение: эти здания, вероятно, были построены в память о романе и его вкладе в китайскую научно-фантастическую литературу.

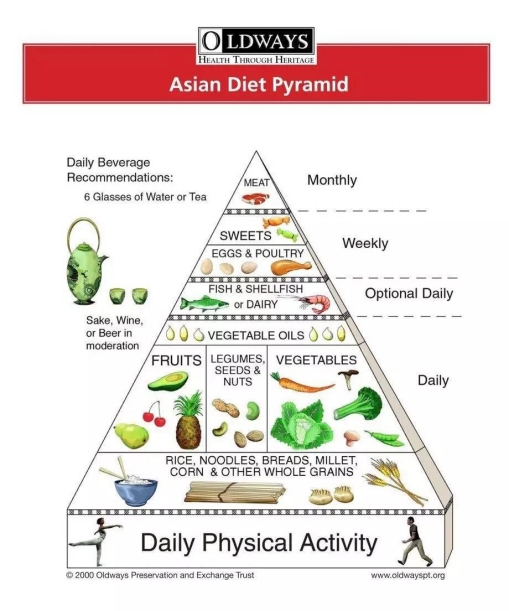

Или дайте ему английскую версию азиатской диетической пирамиды, и он мгновенно сможет стать личным диетологом и составлять рецепты на неделю.

Если вам лень читать длинные статьи, оставьте это MiniCPM-Llama3-V 2.5, а потом задавайте вопросы, он максимально быстро даст ответы.

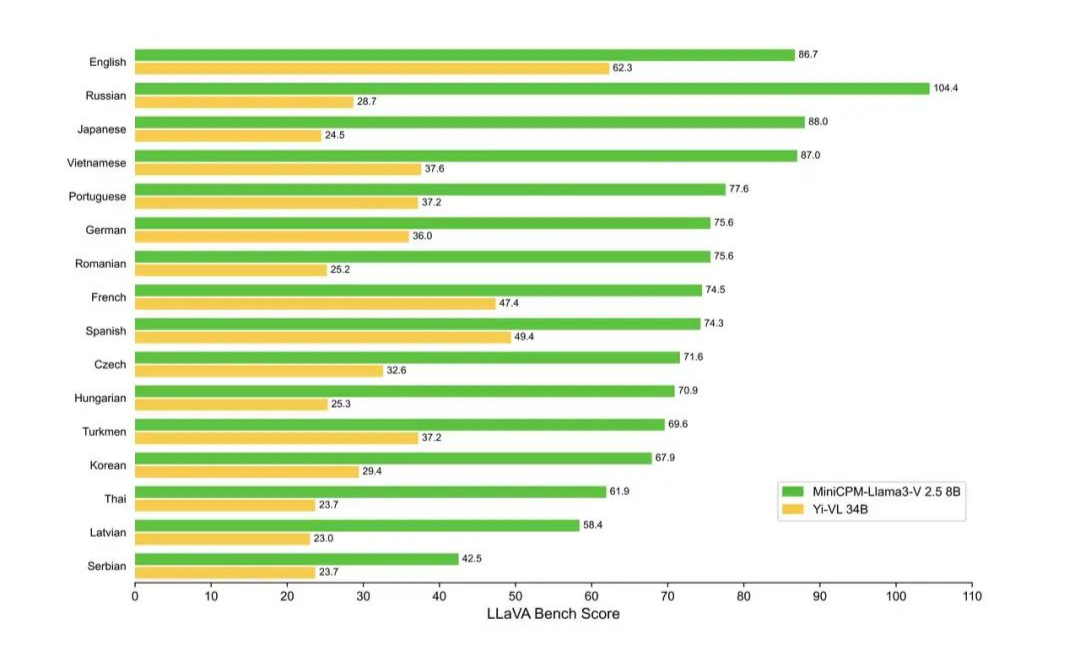

Теперь MiniCPM-Llama3-V 2.5 поддерживает более 30 языков, включая немецкий, французский, испанский, итальянский, русский и другие основные языки. Языки стран «Пояса и пути» практически у вас под рукой.

Следует отметить, что MiniCPM-Llama3-V 2.5 на самом деле представляет собой доработанную модель, основанную на модели с открытым исходным кодом Llama3-8B-Instruct.

В прошлом было большой проблемой позволить ИИ обрабатывать различную информацию, такую как изображения и текст, одновременно и с высокой скоростью. Однако Wall-Facing Intelligence использует структуру ускорения NPU, которая специально разработана для ускорения обработки. обработка изображений, повышающая эффективность работы ИИ на мобильных телефонах.

Согласно официальному сообщению, при облицовке стены впервые возможно ускорение только конечной системы. В настоящее время MiniCPM-Llama3-V 2.5 эффективно развернут на мобильных телефонах и достиг 150-кратного ускорения кодирования изображений.

Например, скорость декодирования языковой модели Llama 3 на мобильном телефоне составляет около 0,5 токена/с, а мультимодальная модель MiniCPM-Llama3-V 2.5 улучшила скорость декодирования языка на мобильном телефоне до 3 за счет многократной оптимизации. такие методы, как ЦП -4 токена/с.

Прилагается адрес с открытым исходным кодом MiniCPM-Llama3-V 2.5:  https://github.com/OpenBMB/MiniCPM-V

https://github.com/OpenBMB/MiniCPM-V

Модель на стороне устройства — поле битвы производителей мобильных телефонов

За последние два года модели на стороне устройства часто появлялись в речевых PPT крупных производителей терминалов.

Так называемые модели конечной стороны — это модели искусственного интеллекта, которые работают на терминальных устройствах. Эти модели обычно разрабатываются так, чтобы быть достаточно легкими, чтобы соответствовать ограничениям вычислительной мощности и ресурсов конечного устройства.

После того, как GPT-4 появился в сети, «Крестный отец искусственного интеллекта» Джеффри Хинтон однажды заметил, что, я думаю, наступит этап, когда мы будем обучаться на компьютерах с большой вычислительной мощностью. Как только модель будет обучена, ее можно будет запускать на устройствах с низким энергопотреблением. .

Характерной чертой конечной модели является то, что она может работать на стороне устройства (например, смартфонов, встроенных систем и т. д.) для обработки данных и принятия решений без отправки данных на удаленный сервер.

Разбивая приведенные выше слова на части, мы можем обнаружить преимущества конечной модели:

- Локальный запуск: модель запускается локально на устройстве, не полагаясь на удаленный сервер.

- Обработка в реальном времени: возможность обработки данных на устройстве в режиме реального времени, обеспечивая быстрый отклик.

- Низкая задержка: поскольку данные не нужно передавать между устройством и сервером, задержка меньше.

- Защита конфиденциальности: данные обрабатываются локально, что снижает риск утечки данных и повышает защиту конфиденциальности.

- Независимость от сети. Конечная модель работает даже без сетевого подключения.

- Оптимизация ресурсов. Конечную модель обычно необходимо оптимизировать, чтобы адаптировать ее к ограниченным вычислительным ресурсам и объему памяти терминального устройства.

- Применимо к различным устройствам: модель на стороне клиента может быть развернута на различных типах терминальных устройств, включая, помимо прочего, смартфоны, устройства «умного дома», носимые устройства и т. д.

- Миниатюризация и оптимизация: модели могут нуждаться в сжатии, сокращении, квантовании и других технических процессах, чтобы уменьшить размер модели и повысить эффективность работы.

Конечно, большая модель на стороне клиента и большая облачная модель являются синергетическими, а не продуктом противостояния.

Итак, мы видим, что хотя крупные модели, такие как Llama 3 и Claude, развиваются полным ходом, исследования торцевых моделей не отстают.

Ученый NVIDIA ДжимФан отметил, что последняя версия GPT-4o, скорее всего, представляет собой упрощенную небольшую модель, а преимущества очевидны — она более усовершенствована и более эффективна.

Будь то Phi-3, выпущенный Microsoft в прошлом месяце, серия высокопроизводительных небольших стальных пушек, выпущенная Wallface Intelligence, или серия моделей OpenELM, недавно объявленная Apple как с открытым исходным кодом, постоянно выпускаются новые модели небольшого размера.

2024 год — решающий год для внедрения приложений искусственного интеллекта, и модели на стороне устройств также набирают обороты и готовятся проявить себя в этом году.

Неоспоримым фактом является то, что большинство современных инноваций в области терминалов достигли своего предела. Возьмем, к примеру, мобильные телефоны, которые «растут» на нашем теле. Чувство удивления и новаторства, когда Стив Джобс достал iPhone, давно потерялось в длинной реке времени.

Предложение инноваций в терминалах на базе искусственного интеллекта, независимо от того, является ли оно скорее уловкой, чем реальность, или использованием технологий будущего для «предоставления денег» настоящему, может на самом деле еще больше раскрыть воображение таких устройств, как мобильные телефоны, и стать ключевым моментом для разрушения. игра.

Именно в рамках этой тенденции модель устройства больше не является просто концепцией, остающейся в теоретических дискуссиях или брошюрах производителей. Она начала постепенно проникать в нашу повседневную жизнь.

На конференции HamonyOS 4 в августе прошлого года Юй Чэндун объявил о способности умного помощника Xiaoyi получать доступ к большим моделям искусственного интеллекта. Сразу после этого Лэй Цзюнь сообщил, что Xiaomi прогнала на своем мобильном телефоне большую модель с параметрами 1,3B, и эффекты некоторых сцен сравнимы с эффектами в облаке.

Ни один из отечественных мобильных телефонов Yuwujia не остался позади. OPPO Xiaobu Assistant на базе AndersGPT, Honor Magic 6, оснащенный большой моделью AI на стороне терминала 7B, и vivo, оснащенный большой модельной матрицей Blue Heart, также были официально анонсированы один за другим.

Рано утром репортер Bloomberg Марк Гурман сообщил, что Apple улучшит голосовую функцию Siri, чтобы сделать ее более разговорной, и добавит функции, которые помогут пользователям справляться с повседневной жизнью, в том числе:

- Автоматически суммировать уведомления iPhone

- Обобщить новостные статьи

- Расшифруйте голосовые заметки

- Улучшите существующие функции автозаполнения календарей и рекомендации приложений.

- ИИ редактирует фотографии

Что касается основного голосового помощника Siri, то в будущем он, скорее всего, будет тесно связан с аппаратной моделью OpenAI или Gemini.

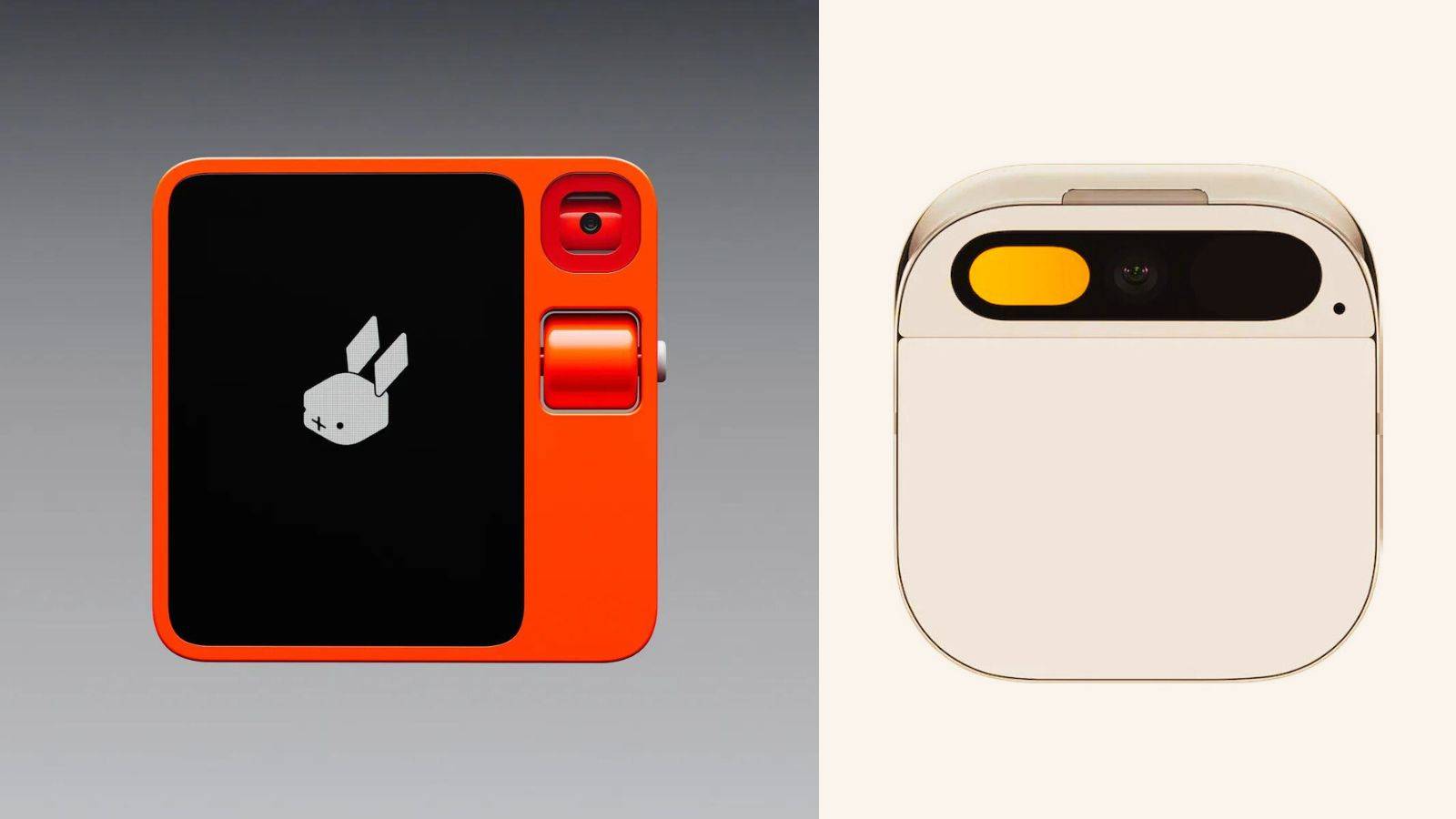

Хотя популярное ИИ-оборудование Rabbit R1 подвергается сомнению как оболочка Android, то, что оно продемонстрировало на пресс-конференции, также является профилем идеального состояния ИИ-телефона — системы без барьеров между приложениями и плавного взаимодействия.

Однако эта ситуация не произойдет в одночасье. Если голосовой помощник AI действительно сможет понимать пользователей и планировать приложения, как и ожидалось, это не только полностью разрушит пользовательский опыт, но также, как ожидается, изменит отношения между производителями мобильных телефонов и третьими лицами. Сторонние разработчики приложений.

Например, появились новости о том, что Apple, которая всегда была закрытой, начала активно проявлять открытость перед лицом этого потока технологических изменений.

По словам Бена Рейтсеса из Melius Research, Apple, как ожидается, откроет магазин, посвященный приложениям искусственного интеллекта, на предстоящей конференции WWDC. Это не только важный поворотный момент в открытой стратегии Apple, но и четкий сигнал ее стратегической трансформации в эпоху искусственного интеллекта.

Это также показывает, что Apple пытается создать большую ценность для разработчиков и пользователей, создавая открытую экосистему искусственного интеллекта, а также завоевывая для себя более широкое рыночное пространство.

Ближе к дому, такие конечные модели, как MiniCPM-Llama3-V 2.5, доказали свою силу – модель не только имеет принцип «чем больше параметры, тем лучше производительность», но и может обеспечить максимальную производительность при наименьших параметрах!

В то же время вступление в жизнь — это только первый шаг. Когда путь передачи данных сокращается до нуля, модель на стороне устройства позволяет ИИ реагировать на шаг быстрее, чем человеческое мышление, а это может означать, что наступила следующая весна терминальных устройств. действительно приехал.

К тому времени каждое взаимодействие между пользователями и конечными продуктами будет вызывать непроизвольный звук «вау».

# Добро пожаловать на официальную общедоступную учетную запись WeChat Aifaner: Aifaner (идентификатор WeChat: ifanr). Более интересный контент будет предоставлен вам как можно скорее.

Ай Фанер | Исходная ссылка · Посмотреть комментарии · Sina Weibo