После того, как ChatGPT сможет говорить на человеческом языке, загрязнение Интернета ИИ станет еще более серьезным.

Произошло то, чего люди больше всего боятся.

Я случайно прочитал несколько новостных статей в Интернете, но не могу сказать, написаны ли они искусственным интеллектом или людьми. Когда я играю в игры в свободное время, я не могу сказать, являются ли мои товарищи по команде людьми с искусственным интеллектом или реальными людьми.

В комнате прямой трансляции цифровые знаменитости самостоятельно сосут куриные ножки, создавая сцену, отделенную от реальных помощников, которые кричали…

По данным зарубежных СМИ 404 media, последней жертвой стал Wordfreq — проект, первоначально использовавшийся для отслеживания и анализа популярности и частоты использования различных слов и словарного запаса на нескольких языках.

Там, где светит солнце, всегда скрывается тень, и ясно, что Wordfreq не первая жертва и не последняя.

Другими словами, в конечном итоге за это платят сами люди.

GPT загрязняет язык, и людям приходится за это платить

«Генераторный ИИ загрязнил данные, и я не думаю, что у кого-то есть достоверная информация об использовании человеческого языка после 2021 года».

В этом крике сердца Робина Спира, основателя проекта Wordfreq, проявляется доля беспомощности и обиды.

Чтобы выяснить причину этого, нам нужно начать с происхождения Wordfreq.

Анализируя контент из Википедии, субтитров к фильмам и телепередачам, новостных репортажей и веб-сайтов, таких как Reddit, Wordfreq пытается отслеживать эволюцию более чем 40 языков, а затем изучать изменение языковых привычек по мере изменения сленга и поп-культуры.

Wordfreq — настоящая сокровищница для лингвистов, писателей и переводчиков. Но теперь огромное заявление по адресу GitHub «Этот проект больше не будет обновляться» печально прозвучало похоронным звоном по этому проекту.

В прошлом сбор общедоступных данных из Интернета был основой источника данных проекта, но развитие генеративного искусственного интеллекта сделало текст искусственного интеллекта популярным.

Спир привел типичный пример: в прошлом люди редко использовали слово «покопаться». Однако, поскольку ChatGPT превратил это слово в мантру, Ли Гуй стал чаще выдавать себя за Ли Куя, что иногда искажало статистику частоты слов. точный анализ человеческих языковых привычек.

Если это недостаточно интуитивно понятно, то наиболее ярким предупреждением является распространение таких клише, как «вкратце» и «подводя итог».

Эта тенденция постепенно проникает в академическое письмо и даже литературное творчество.

В отчете Стэнфордского университета отмечается, что ChatGPT всего за пять месяцев стал «письменным артефактом» для многих экспертов и ученых. Среди них в области информатики почти каждые шесть рефератов и каждое семь введений написаны им.

Далее следует «массовое вторжение» человеческого стиля письма со стороны генеративного ИИ.

Результаты исследования Гэн Минмэна, аспиранта Итальянского института международных перспективных исследований, подобны зеркалу, еще больше отражающему словесные предпочтения ChatGPT и полностью подтверждающему его влияние на написание научных статей.

Проанализировав тезисы более миллиона статей по arXiv, Гэн Минмэн обнаружил, что частота слов в статьях значительно изменилась после популярности ChatGPT. Среди них значительно увеличилась частота использования таких слов, как «значительный», а частота использования таких слов, как «есть» и «являются», снизилась примерно на 10%.

В большинстве случаев генеративный ИИ может превратить человека с показателем креативности 60 в балл 70 и выше. Однако в создании текстов, хотя личное творчество и качество письма улучшились, оно незаметно снизило коллективное творчество. .

Два ученых из UCL и Университета Эксетера опубликовали исследование в журнале Science, в котором 500 участникам было поручено использовать ИИ для написания около 8 строк историй на случайные темы и анализа целевой аудитории.

Результаты показали, что истории стали более «креативными» благодаря вдохновению ИИ, но при этом истории, созданные этими ИИ, были удивительно похожи друг на друга.

Поэтому, когда генеративный текст ИИ наводняет Интернет, как всепроникающий загрязнитель, для Wordfreq и людей, преимущества намного перевешивают недостатки.

Начинается война против краулеров, Wordfreq страдает

Закрытие проекта Wordfreq можно рассматривать как жертву, оказавшуюся в гигантской войне краулеров.

Развитие ИИ неотделимо от поддержки алгоритмов, вычислительных мощностей и данных. Хотя между текстом, сгенерированным ИИ, и реальным человеческим языком все еще существует разрыв, он становится все более приличным с точки зрения грамматики и логики.

В этой спокойной воде назревает тихая война между сканированием и противодействием ИИ.

В нынешней среде общественного мнения сканирование данных веб-страниц, похоже, стало табу против всего мира. Многие области комментариев к новостным сообщениям наполнены презрительными голосами пользователей сети, а Wordfreq, по сути, построен на сканировании текстов на разных языках. .

Когда генеративный ИИ еще не был популярен, Wordfreq тоже провел медовый месяц.

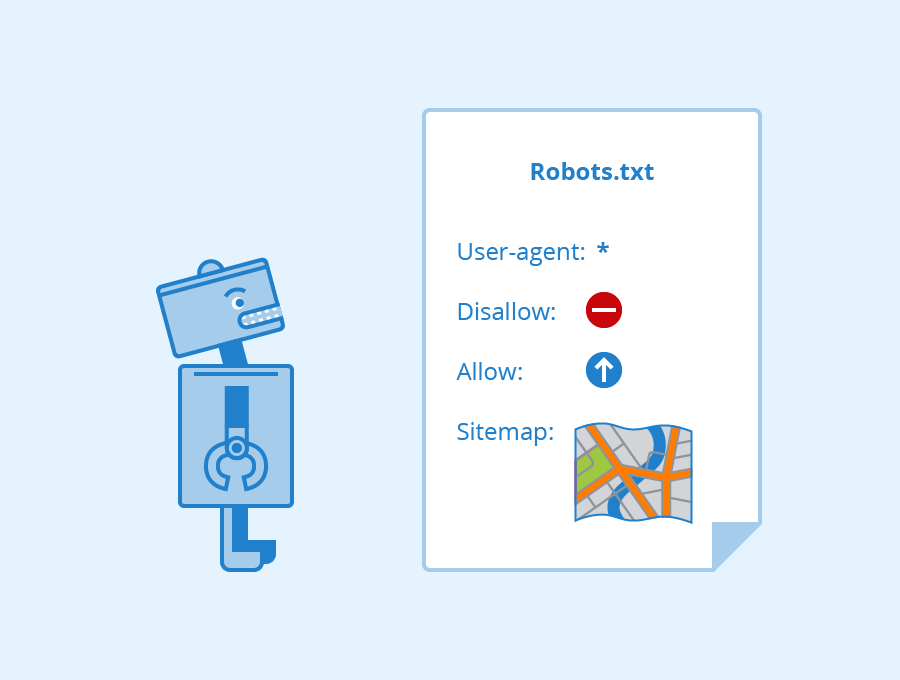

В прошлом казалось разумным сканировать общедоступные данные при условии соблюдения правил использования файла robots.txt на веб-сайте. Это негласное соглашение между веб-сайтом и сканером, которое используется для указания сканеру, какой контент можно сканировать, а какой нет.

Когда на веб-сайте устанавливается соглашение об ограничении использования файла robots.txt, это похоже на установку знака «Посторонним вход воспрещен». Если сканер нарушает соглашение robots.txt или использует метод, позволяющий обойти антисканерную технологию веб-сайта для получения данных, это может представлять собой недобросовестную конкуренцию, нарушение авторских прав и другие незаконные действия.

Однако по мере того, как потребность модели в высококачественных данных возрастает, борьба между сканированием и противодействием ему становится все более ожесточенной.

Оглядываясь назад, можно сказать, что существует множество споров по поводу данных гигантских сканеров генеративного искусственного интеллекта и антисканеров. Наиболее известными из них, естественно, являются OpenAI и Google.

В прошлом году OpenAI запустила инструмент веб-сканера GPTBot, утверждая, что он будет использоваться для сканирования данных веб-страниц для обучения моделей ИИ. Но очевидно, что ни одно СМИ не хочет, чтобы его тайно собирали краулеры.

СМИ, осознающие важность данных и авторских прав, следуют бизнес-логике передачи денег в одну руку и данных в другую.

Исследование, проведенное Институтом Reuters, показывает, что по состоянию на конец 2023 года почти половина популярных новостных сайтов в 10 странах мира заблокировали краулер OpenAI (Crawler), а почти четверть сайтов заблокировали также Google. сканер выполняет то же действие.

Все должны быть знакомы с последующей историей. Традиционные средства массовой информации каждые несколько дней подали в суд на OpenAI, и это был иск о нарушении авторских прав. Лишь в этом году охваченная судебными исками компания OpenAI установила партнерские отношения с издателями новостей.

Однако предыдущие стратегии, такие как высокие стены и плата за передачу данных, также сделали Wordfreq жертвой «нехватки данных».

Спир отмечает, что, поскольку Twitter и Reddit (сайт, включенный в Wordfreq) начали взимать плату за свои API, это усложнило парсинг Интернета.

«Информация, которая раньше была бесплатной, стала дорогой», — написал Спир. «Я не хочу участвовать в какой-либо работе, которую можно спутать с генеративным ИИ или которая могла бы получить пользу от генеративного ИИ».

Даже если вы можете обменять деньги на данные, данные в конечном итоге будут израсходованы.

Исследовательская фирма Epoch AI прогнозирует, что высококачественные текстовые данные, доступные в Интернете, могут быть исчерпаны к 2028 году. В отрасли это явление называется «стеной данных» и может стать самым большим препятствием на пути замедления развития ИИ.

В результате многие крупные производители моделей начали обращать внимание на синтетические данные, сосредоточившись на использовании ИИ для обучения ИИ.

Использование ИИ для обучения ИИ может сделать его «глупым», чем больше вы его практикуете.

Моя интуиция подсказывает, что текст в Интернете — чушь, а обучение на этих данных — пустая трата вычислительных мощностей.

Когда Llama 3.1-405B пронеслась по многим крупным моделям с открытым исходным кодом благодаря своей ошеломляющей мощи, Томас Сиалом, исследователь Meta AI, возглавляющий серию Llama, сделал вышеупомянутые замечания в интервью.

По его словам, процесс обучения Llama 3 не опирается на какие-либо ответы, написанные человеком, а полностью основан на синтетических данных, генерируемых Llama 2.

Заявление Сьялома, возможно, слишком грубое, но доля правды в нем есть.

В Интернете каждый день появляется постоянный поток данных, но обучение ИИ всегда было вопросом с несколькими вариантами ответов. Если данные полны ошибок и шума, модель естественным образом усвоит эти «недостатки» и точность прогнозирования. и классификацию можно представить и знать.

Более того, данные низкого качества часто пронизаны предвзятостью и не могут достоверно отражать общее распределение данных, что приводит к тому, что модель дает предвзятые ответы. Генеральный директор ЮНЕСКО Азуле также предупредил:

«Новые инструменты искусственного интеллекта способны неосознанно изменить восприятие миллионов людей, поэтому даже минимальная гендерная предвзятость в создаваемом контенте может значительно усугубить неравенство в реальном мире».

Однако синтетические данные не могут быть панацеей для решения проблемы «стены данных».

Недавно исследователи из Оксфорда и Кембриджа обнаружили, что когда модель использует наборы данных, сгенерированные искусственным интеллектом, качество выходных данных постепенно снижается, что в конечном итоге приводит к созданию бессмысленного контента, что широко известно как коллапс модели.

Руководитель исследования Илья Шумайлов использовал аналогию с фотографией, чтобы описать процесс:

Если вы сделаете фотографию, отсканируете ее, распечатаете, сфотографируете, а затем повторите процесс с течением времени, весь процесс по сути будет заглушен «шумом». В конце вы получите темный квадрат.

Когда все больше и больше спам-страниц, созданных ИИ, начнут заполонять Интернет, исходные материалы для обучения моделей ИИ также будут заражены.

Например, Stack Overflow, сообщество вопросов и ответов для программистов, сильно пострадало от искусственного интеллекта.

Когда ChatGPT впервые стал популярным, Stack Overflow объявил о «временном запрете». «Средняя доля правильных ответов, полученных с помощью ChatGPT, слишком низка».

Ведь количество профессиональных пользователей ограничено, и проверить все ответы по отдельности невозможно, а вероятность ошибок ChatGPT очевидна. Когда ИИ загрязняет окружающую среду сообщества, люди, которым в это время нечего делать, могут только запретить его.

В области изображений модели ИИ склонны воспроизводить наиболее распространенные данные и после многих итераций могут в конечном итоге забыть даже исходную вещь.

Все это указывает на порочный круг: ИИ генерирует некачественную или даже ошибочную информацию, которая смешивается с человеческими данными. Эти, как правило, некачественные данные постоянно передаются ИИ, что в конечном итоге приводит к тому, что безудержный ИИ начинает иметь неприятные последствия.

И если люди поймут, что следы данных прошлого станут для них пищей, возможно, мы будем более осторожными с каждым словом, которое оставляем в Интернете.

# Добро пожаловать на официальную общедоступную учетную запись WeChat Aifaner: Aifaner (идентификатор WeChat: ifanr). Более интересный контент будет предоставлен вам как можно скорее.

Ай Фанер | Исходная ссылка · Посмотреть комментарии · Sina Weibo