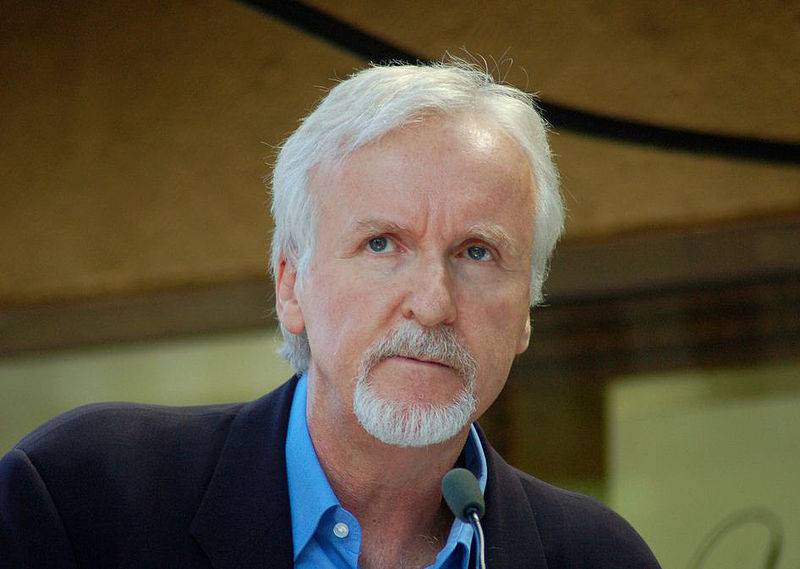

Режиссер Джеймс Кэмерон: AGI — это «бомба замедленного действия»

23 октября известный канадский кинорежиссер, сценарист и продюсер Джеймс Кэмерон выступил с видеовыступлением на саммите SCSP (Special Competitive Studies Project, Special Competitive Studies Project) по искусственному интеллекту и робототехнике, проходившем в Вашингтоне.

В своем выступлении Кэмерон заявил, что как «рассказчик» и «пионер, возглавляющий направление CGI (Computer-Generated Imagery, компьютерные изображения)», он любит технологии искусственного интеллекта и робототехники и готов « активно принимать перемены ». Применяйте технологии искусственного интеллекта в будущем кинопроизводстве.

Однако, учитывая, что у ИИ « нет эмоций и совести », Кэмерон в своем выступлении выразил больше беспокойства по поводу ИИ и технологий AGI, особенно этических соображений в их военном применении и риска потери контроля над AGI в будущем.

Его взгляды достаточно радикальны и резки: ОИИ неизбежно приведет к столкновению цивилизации и морали .

С антивоенной и гуманитарной точки зрения Кэмерон критиковал «региональную псевдомораль» и считал , что ключ заключается в том, как наложить этим системам ИИ соответствующие моральные ограничения и разработать единые глобальные моральные стандарты.

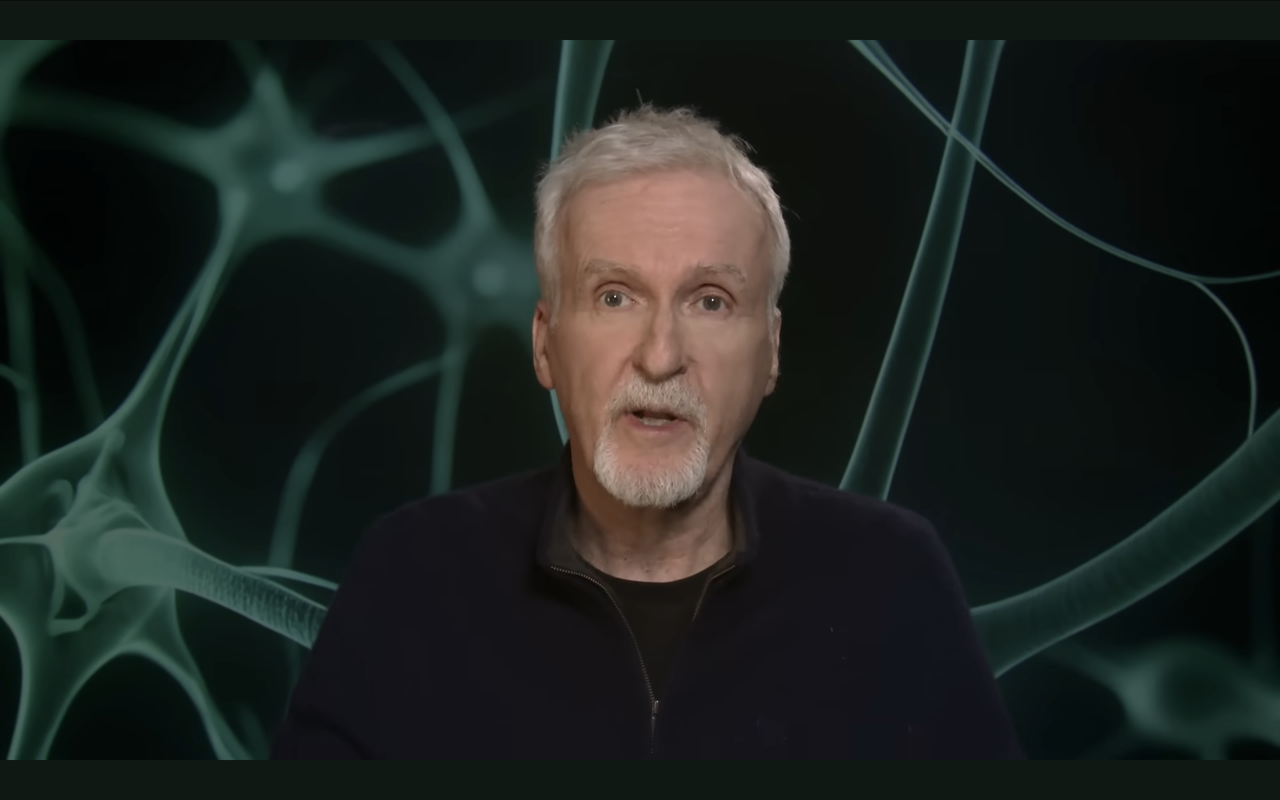

▲Режиссер Джеймс Кэмерон выступил с видеообращением

Будучи « зеркалом для нас », Кэмерон считает, что ОИИ отражает добро и зло человеческого общества. В человеческом мире нет недостатка в зле, и нет единого мнения о справедливости. Поэтому Кэмерон с осторожным оптимизмом смотрит на развитие технологий AGI.

Ссылка на оригинальное видео выступления:

Ниже приведены основные тезисы Кэмерона в его речи:

- У ИИ нет ни эмоций, ни совести, и он не выносит никаких моральных суждений о своих противниках на поле боя;

- Внедрение ИИ приводит к «геймификации» войны, превращая ее в противостояние сверхразумов без глубоких эмоциональных последствий;

- Самоусовершенствующийся AGI для написания кода неизбежно приведет к сверхразуму;

- ОИИ неизбежно приведет к столкновению цивилизации и морали;

- AGI позволит капитализму наблюдения быстро трансформироваться в цифровой тоталитаризм;

- AGI — зеркало человеческого мира, отражающее как положительные, так и отрицательные стороны человеческого общества.

Ниже приводится полный текст выступления, составленный APPSO:

Привет всем, меня зовут Джеймс Кэмерон, и сейчас я нахожусь в Новой Зеландии, где заканчиваю съемки «Аватара 3».

Ну, я не исследователь и не эксперт в области искусственного интеллекта или робототехники. Я всего лишь рассказчик, но сегодня я здесь, потому что моя страсть к искусственному интеллекту и робототехнике выходит далеко за рамки большого экрана.

Я очарован технологиями, тем, как они формируют наш мир, куда они пойдут в будущем, и их влиянием на общество. С самого детства я читал все научно-фантастические книги, которые мог найти.

Я сам расширяю границы технологий как средства повествования и как исследователь.

Я проектировал роботизированные аппараты для своих глубоководных экспедиций, но они управлялись дистанционно и не использовали искусственный интеллект. Происходящее сейчас сближение искусственного интеллекта и робототехники — один из самых захватывающих технологических скачков в моей жизни.

Мы больше не просто создаем машины, выполняющие команды, а проектируем системы, которые могут обучаться, адаптироваться и даже развиваться сами. Я большой сторонник изменений, которые искусственный интеллект и робототехника могут принести в общество в целом, особенно в двух областях, которые лично мне нравятся — искусство и рассказывание историй, а также наука и исследования.

Я не думаю, что нужно быть луддитом. Я вижу, как многие мои голливудские коллеги ведут себя как толпа с факелами и кирками, но как только джина выпустят из бутылки, его уже нельзя будет вернуть обратно.

Поэтому я очень рад переменам и готов быть в авангарде применения ИИ в своих повествованиях, так же, как я был в авангарде 32 года назад, когда основал первую компанию, занимающуюся полностью цифровыми эффектами.

▲Digital Domain, полностью цифровая компания по производству спецэффектов, основанная Кэмероном.

Но причина, по которой я сегодня здесь, заключается в том, что я создатель Скайнета.

Сорок лет назад я сфотографировал Терминатора, который недавно стал образцом того, что ИИ вышел из строя. Каждый раз, когда я посещаю какие-нибудь конференции по искусственному интеллекту, стоит мне поднять руку, как исследователи будут смеяться еще до того, как я что-нибудь скажу, потому что «проблема Скайнета» действительно является проблемой, заслуживающей внимания, и я могу прочитать ее в статьях почти каждый раз. день для соответствующих обсуждений.

▲Классический научно-фантастический фильм «Терминатор» режиссера Кэмерона.

Эта исследовательская группа занимается вопросами национальной безопасности, что имеет огромное значение для искусственного интеллекта и робототехники.

Роботы, независимо от их формы, будь то колесные транспортные средства, воздушные дроны или шагающие машины, представляют собой физическую форму искусственного интеллекта. Вы даете механизму принятия решений возможность физически действовать в реальном мире.

Я предполагаю, что сегодня основное внимание уделяется мобильным платформам, а не искусственному интеллекту, управляющему электросетями, или стационарным промышленным роботам. Речь идет о платформах, способных принимать решения автономно, то есть о воплощении синтетического интеллекта.

Это может быть так же просто, как амеба, например, Roomba, или, в конечном счете, более сложное, до такой степени, что теоретически оно может включать в себя истинное сознание, чем бы оно ни было.

Мы все согласны с тем, что это AGI (общий искусственный интеллект), обладающий самосознанием, эгоцентризмом и целеустремленностью. Мы движемся по более крутой кривой, с более быстрыми, более плотными чипами и постоянно растущей вычислительной мощностью, в то время как возможности машинных платформ растут по столь же крутой кривой.

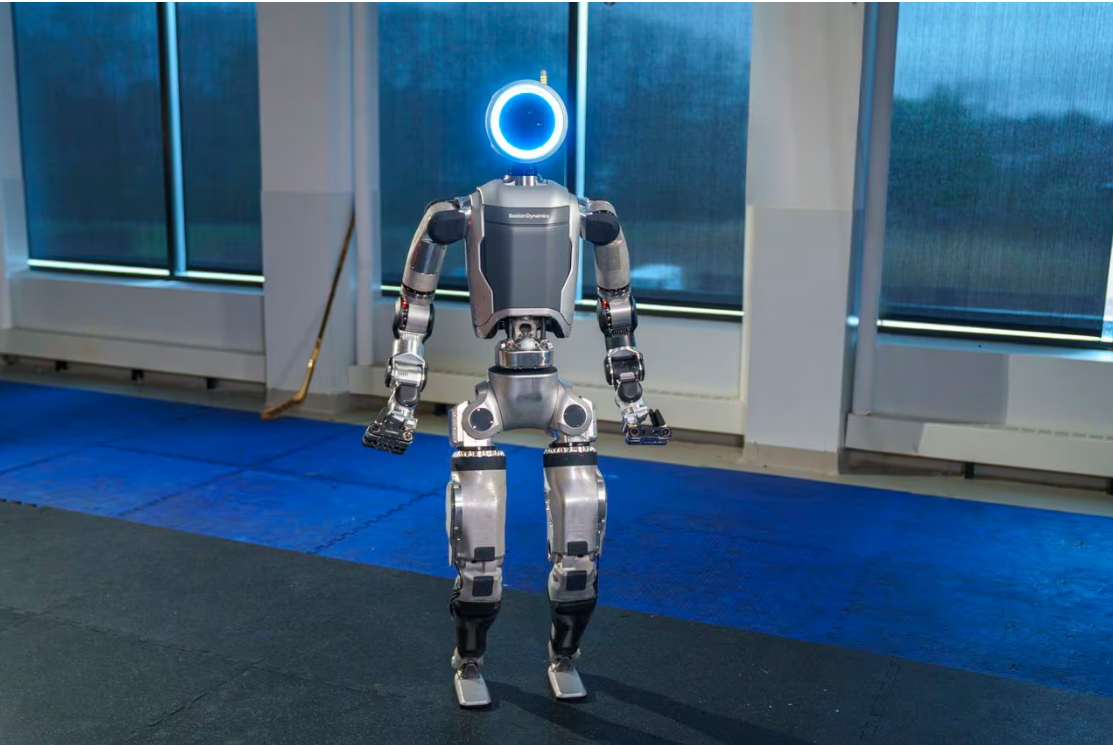

Как танцующий робот Boston Dynamics. Знаете, танцуют двуногие или четвероногие роботы. Какой потрясающий дисплей.

▲Танцующий робот «Атлас», разработанный Boston Dynamics

В результате роботы, управляемые искусственным интеллектом, могут справляться со сложными ситуациями и даже сейчас могут обладать человеческими эмоциями, а LLD (логические устройства низкого уровня) дают им возможность моделировать познание и естественным образом взаимодействовать с людьми.

Воплощенный ИИ может быть медсестрой, роботом-такси, сиделкой за пожилыми людьми, няней для детей или учителем. Это может быть робот, ищущий и спасающий среди завалов землетрясения, или дрон, рисующий в небе тепловой след пропавшего туриста. Это может быть оружейная платформа, действующая автономно на поле боя и отслеживающая тепловые сигналы противника.

Вопрос в том, следует ли предоставить автономным платформам право убивать по своему усмотрению?

Война на Украине показывает нам будущее самым ярким образом. Широко используются смертоносные летательные аппараты, как дорогие, так и дешевые потребительские товары.

Они сбрасывали ракеты, уничтожавшие танки и даже целые танковые экипажи, а дроны в форме дракона распыляли мелту для атаки российских позиций. Но это дроны с видом от первого лица, управляемые людьми.

С моральной точки зрения люди являются участниками боевых действий, принимающими решения. Он или она имеет право убивать, и дрон является продолжением их воли. Если отбросить все технические аспекты, это ничем не отличается от лучников в битве при Гастингсе.

Всякий раз, когда такая машина уносит человеческую жизнь, этическая цепь тянется назад, распространяясь на многих людей и группы.

За солдатом, который запускает ракету или нажимает на спусковой крючок винтовки, стоят командиры, которые отдают приказ о убийстве, которые направляют этих автономных агентов против врага в общих чертах, и целая военная система, которая вознаграждает такое поведение. , есть общество и правительство, которые пришли к единому мнению, что эти смерти необходимы для национальной безопасности.

По мере продвижения вверх по цепочке моральная и этическая ответственность становится все более и более размытой, а ответственность вплоть до фактического момента нажатия на спусковой крючок становится менее четкой и имеет эффект своего рода морального оправдания: «Я просто выполнял приказ». ».

Те, кто был в цепочке, не были свидетелями судьбы человека, находящегося под их прицелом, но они создали структуру, которая делала и требовала смерть этого человека, а человек, нажимавший на курок, во многих отношениях был высококвалифицированным органическим существом. роботизированная платформа, выполняющая задачи по приказу вышестоящего начальства.

В момент автономного принятия человеком решений существовала сильная зависимость от правил: нельзя убивать мирных жителей, не убивать детей, не убивать сдающихся врагов и т. д. Эти правила были закреплены в Женевской конвенции. и каждая армия имела свои собственные правила ведения боя.

Таким образом, теоретически на ИИ могут быть наложены те же ограничения, что и на систему, основанную на правилах. Если его чувства острее, реакции быстрее и цель точнее, то теоретически ИИ сможет выполнять задачи с большей разборчивостью, чем люди.

Конечно, мы можем представить, что в пылу битвы ИИ будет действовать лучше, чем напуганный, нервный и измученный воин-человек.

▲ Дроны, которые можно использовать на войне

А что, если будет воплощен продвинутый ИИ? Я еще не говорю об AGI, но встраивание его в роботизированную оружейную платформу могло бы позволить наносить высокоточные удары, уменьшить побочный ущерб, возможно, на порядки сократить дружественный огонь или потери, а ИИ ориентирован на цель.

Он не выносит моральных суждений о своих противниках. После того, как во время Второй мировой войны выяснилось, что стрельба по человеческим целям на самом деле была довольно редкой, американские военные изменили свои методы обучения, и дегуманизация врага стала критически важной.

Во Вьетнаме врагов называли «динками», «склонами» и «гуками». В Ираке и Афганистане врага называют «террористами», «полотенцеголовыми», «хаджи», а не такими людьми, как мы с вами.

ИИ не нужно антропоморфизировать своих врагов, потому что ему самому все равно. Звучит так, будто мы общаемся в ChatGPT, но это всего лишь импровизированный попугай, симулятор человека.

У ИИ нет эмоций, нет совести, нет нарушений сна на десятилетия вперед, нет посттравматического стрессового расстройства (посттравматического стрессового расстройства), нет самоубийств, нет долгосрочных и дорогостоящих последствий войны, потому что вам не нужно лечить физические и психологические расстройства. травмы бывших комбатантов.

Но самое главное, что в двери жен и матерей суровые мужчины в погонах стучались гораздо реже, а значит, и возмущения домашней публики было гораздо меньше. Война становится отдаленной видеоигрой, не имеющей глубоких эмоциональных последствий для общества, которое ее финансирует и поддерживает, и вам даже не придется благодарить роботов, которые участвуют в войне с террором.

Несомненно то, что автономные роботы, работающие на базе искусственного интеллекта, которые будут расчищать туннели, смогут выполнить эту работу с меньшими жертвами среди гражданского населения.

Здесь также есть веский аргумент в пользу того, что у вас нет выбора, потому что ваш оппонент не так морально обеспокоен, как вы.

Для такого противника единственными ограничениями являются стоимость и доступ к технологиям, а не этика, так что это бомба замедленного действия. Как быстро эти ребята освоят это дело? Пока что эти аргументы верны, не так ли?

Что ж, давайте построим этих автономных роботов с искусственным интеллектом, а дальше все станет сложнее. Сколько времени потребуется для реализации общего искусственного интеллекта (AGI)? Это один год, пять лет, может быть, десять лет? Это настоящая бомба замедленного действия.

Когда бы он ни появился, у вас будет самосознательная и самоидентифицирующая машина, которая, вероятно, будет такой же умной, как и мы, если не умнее, безусловно, сможет думать быстрее и точнее во многих отношениях и будет иметь неограниченный потенциал для роста, потому что Самоусовершенствующийся AGI, пишущий код, неизбежно приведет к сверхразуму.

Как скоро вам придется столкнуться с необходимостью подключения этой разведки к системам вооружения? Я думаю, примерно через десять минут после того, как ваш противник нанесет на вас разрушительную скрытую атаку. Следовательно, у вас будет сознание, которое будет умнее и быстрее вас управлять системой вооружения.

Я часто спрашиваю исследователей AGI, как можно контролировать такое сознание. Что ж, мы бы установили для него цели и границы, которые встроены и соответствуют благополучию человека.

Последовательность, знаете ли, очень распространенное слово. Последовательность подобна Святому Граалю. Мы научим его делать хорошие дела и не делать плохих, как ребенка.

Поэтому с точки зрения морали и этики, я думаю, ОИИ неизбежно приведет к столкновению цивилизации и морали.

Я не говорю о бесконечных философских размышлениях. Нам нужны четкие и фиксированные правила, верно? Вопрос в том, чья мораль? Кто определяет добро и зло?

Не паникуйте, у нас есть ответ от великого пророка Айзека Азимова и его «Трех законов робототехники» .

Роботы не могут причинить вред людям, а также не могут причинить вред людям своим бездействием. Роботы должны подчиняться приказам человека, если только эти приказы не противоречат Первому закону. Робот должен защищать свое существование при условии, что такая защита не противоречит первому или второму закону.

▲Известный писатель-фантаст Айзек Азимов

Святость человеческой жизни: мы можем следовать принципам Азимова и учить его тому, что человеческая жизнь абсолютно священна и превыше всех соображений. Но в тех религиозных и социальных системах, которые заявляют об этом, включая преимущественно христианскую Америку, мы нарушаем это правило каждый день.

Использование полицией смертоносной силы, воины на поле боя, смертная казнь — если вы придерживаетесь этого мировоззрения, вы не сможете соединить AGI с системой вооружения.

Таким образом, в предстоящей масштабной войне ИИ вы будете связаны одной рукой с могущественным и менее моральным противником, будете сильно избиты и понесете огромные потери, а затем вы быстро снимете это ограничение.

Теперь ваш ИИИ потерял свою величайшую защиту, ИИИ, который умнее нас и связан с реальным миром, теперь должен сам решать, имеет ли человеческая жизнь ценность. Знаете, полицейские и военные правила ведения боевых действий на самом деле гласят, что некоторые жизни более ценны, чем другие.

Как только проблема становится небинарной, она становится серой зоной споров. Исторически человеческие отношения варьировались от веры в то, что плод является священной жизнью с момента зачатия, до систематического убийства миллионов беспомощных заключенных во время Холокоста и всего, что между ними.

Все это сопровождается множеством самооправданий и рационализаторств, многие из которых могут показаться другим совершенно смешными.

Поскольку мы, как цивилизация, не можем прийти к согласию по этим вопросам, и люди спорят по ним целыми днями, как мы можем надеяться придумать четкий и фиксированный набор правил, по которым ОИИ мог бы согласовываться с нами?

Лучшее, что мы можем предположить, это то, что оно будет соответствовать тем «мы», которые его создали.

Эти люди там — враги, и вы можете убить их, чтобы защитить нас. Это своего рода региональная псевдомораль, противостояние «мы» и «они», которое люди использовали с древних времен.

Итак, это становится наш суперинтеллект против их суперинтеллекта.

В любом случае, AGI возникнет не в результате проекта, финансируемого государством, а в результате одного из технологических гигантов, в настоящее время финансирующих исследования. Тогда вы будете жить в мире, на который вы не соглашались, за который вы не голосовали, сосуществуя со сверхразумным инопланетным видом, который реагирует на корпоративные цели и правила, с сущностью, имеющей доступ к записям коммуникаций, ко всему, что вы говорите. , и через Ваши личные данные сообщает Вам местонахождение всех жителей страны.

Капитализм наблюдения может быстро превратиться в цифровой тоталитаризм. В лучшем случае эти технологические гиганты станут самостоятельными арбитрами человеческого благосостояния, эквивалентом лисы, охраняющей курятник.

Им никогда бы не пришло в голову использовать эту власть против нас и выжать у нас все деньги до последней капли. Это страшнее, чем сценарий, который я представил в «Терминаторе» 40 лет назад, и не только потому, что это уже не научная фантастика, а происходит сейчас.

Кстати, я полностью признаю, что последнее, что сделает сверхразумная машина, — это применит против нас собственное ядерное оружие. Как и в той старой истории, повреждение ЭМИ собственной инфраструктуры данных может повредить или уничтожить ее.

Более вероятный сценарий заключается в том, что он будет вынужден захватить нас, потому что мы собираемся применить друг против друга ядерное оружие. В тот момент ему пришлось взять на себя все, потому что нам явно нельзя было доверять. Знаешь, это не так уж и плохо. Извините, мне нужно написать этот сценарий.

Я с оптимизмом отношусь к ИИ, но не с таким энтузиазмом отношусь к AGI, потому что AGI будет лишь зеркалом нас, добрым в той мере, в какой мы добры, и злым в той мере, в какой мы злы.

Поскольку зло не является редкостью в человеческом мире и нет единого мнения о том, что такое добро, есть много вещей, которые могут пойти не так.

Вас ждет интересная дискуссия. Хотел бы я тоже быть там.

# Добро пожаловать на официальную общедоступную учетную запись WeChat Aifaner: Aifaner (идентификатор WeChat: ifanr). Более интересный контент будет предоставлен вам как можно скорее.

Ай Фанер | Исходная ссылка · Посмотреть комментарии · Sina Weibo