Только что была выпущена самая сильная модель вывода OpenAI o3! Впервые я могу думать картинками, Ультрачеловек: Уровень гения С фактическими данными измерений

«o3 достигает или приближается к уровню гениальности».

Только что мини-модель OpenAI o3/o4 была наконец официально представлена. Прямой эфир длился почти 30 минут, в быстром темпе и с полным объемом информации.

Сам процесс выпуска о3 тоже очень разворотный. В феврале этого года OpenAI объявила, что откладывает план независимого выпуска o3, а технология будет упакована и внедрена в GPT-5. К началу апреля Альтман, хорошо разбирающийся в «голодном маркетинге», объявил, что его план изменился:

o3 необходимо выпустить первым, а GPT-5 придется подождать, возможно, самое раннее, несколько месяцев.

Чтобы выделить ключевые моменты, основные моменты OpenAI o3/o4 mini заключаются в следующем:

- o Самая умная модель серии на сегодняшний день, ее способность к рассуждению значительно улучшена. Чем дольше думать, тем лучше эффект.

- Впервые изображения напрямую интегрируются в цепочку мышления, «думая» картинками, и можно напрямую вызывать инструменты для обработки изображений.

- Впервые он полностью поддерживает веб-поиск, анализ файлов, выполнение кода Python, глубокий анализ визуального ввода и генерацию изображений.

- Экономически превосходя предыдущее поколение, o3 имеет более высокую производительность при той же задержке и стоимости.

Заменяющие модели, такие как o1 в селекторе моделей, o3, o4-mini и o4-mini-high, начиная с сегодняшнего дня, будут доступны пользователям ChatGPT Plus, Pro и Team, а корпоративные и образовательные пользователи получат доступ через неделю. Ожидается, что o3-pro будет выпущен через несколько недель.

Бесплатные пользователи могут использовать o4-mini в режиме «Подумай», при этом ограничение скорости остается неизменным.

Разработчики получают к нему доступ через Chat Completions API и Responses API, которые поддерживают обобщение выводов и оптимизацию вызовов функций. Вскоре он будет поддерживать встроенные инструменты, такие как веб-поиск.

Выпущена самая сильная модель вывода OpenAI o3, может ли GPT-5 сильно отставать?

Недавно выпущенные o3 и o4-mini — самые умные модели серии o на сегодняшний день.

Эти две модели хорошо справляются с возможностями рассуждения, использованием инструментов и мультимодальной обработкой, что позволяет им думать о сложных проблемах в течение более длительных периодов времени. Впервые они полностью поддерживают веб-поиск, анализ файлов, выполнение кода Python, глубокий анализ визуального ввода и генерацию изображений.

Новая модель применима к более широкому спектру сценариев — от старших исследователей до обычных пользователей.

OpenAI o3 и o4-mini могут вызывать инструменты в ChatGPT и получать доступ к пользовательским инструментам через вызовы функций в API.

OpenAI выпускает o3 и o4-mini и заявляет, что o3 может «генерировать новые гипотезы» | Бибом

С помощью обучения с подкреплением OpenAI также обучила обе модели тому, как использовать этот инструмент: не только зная, как и когда его использовать, но и имея возможность быстро генерировать надежные ответы в правильном формате, часто менее чем за минуту.

Например, когда меня спрашивают, как потребление энергии в Калифорнии летом сравнивается с прошлым годом, я могу проверить общедоступные данные о потреблении энергии в Интернете, написать код Python для прогнозирования, создать диаграммы или изображения, объяснить основу для прогноза и свободно подключить несколько инструментов.

Весь процесс поиска вывода также становится более гибким: модель может вызывать поисковую систему несколько раз для перекрестной проверки результатов; если его собственных знаний недостаточно, он может продолжить сбор информации и интегрировать результаты перекрестного типа.

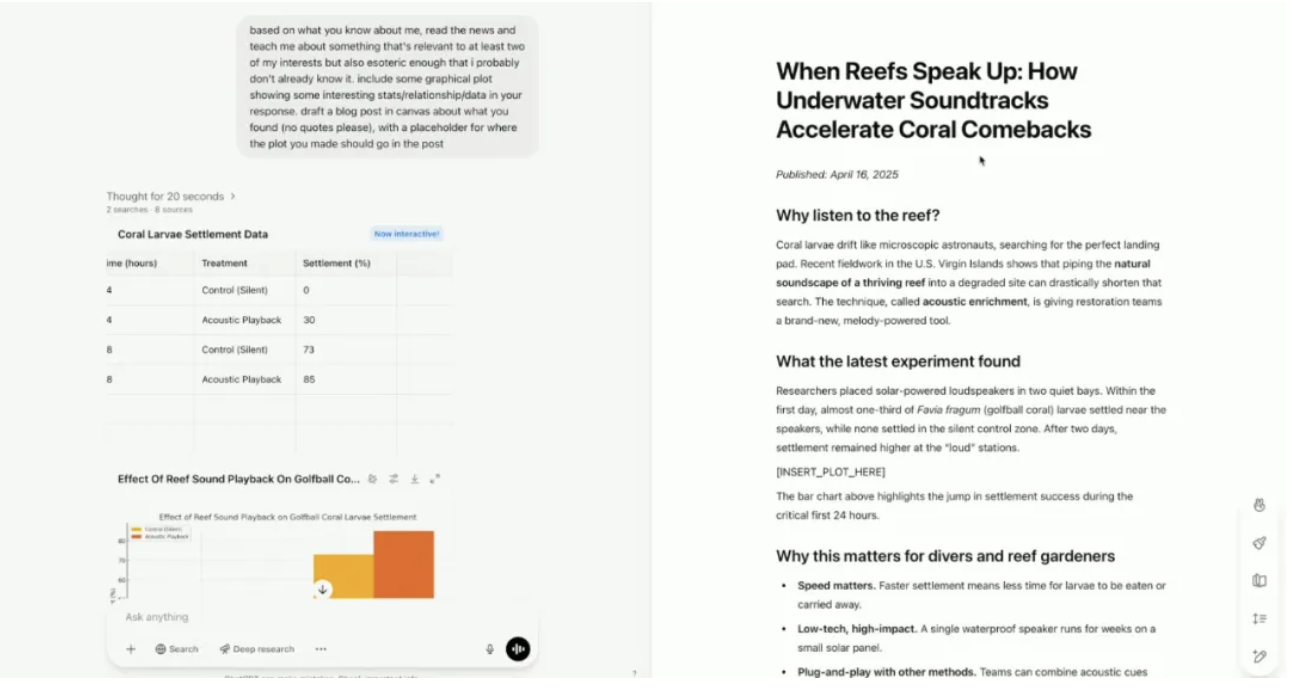

Сегодня рано утром во время прямой трансляции президент OpenAI Грег Брокман также редко появлялся. Докладчики OpenAI показали, как новые модели могут объединять интересы пользователей для обнаружения контента, который может быть интересен пользователям, но еще неизвестен.

При включенной функции «памяти» новая модель может узнать об интересах и увлечениях демонстратора – прыжках с парашютом и музыке.

Вместо того, чтобы просто обсуждать два хобби по отдельности, новая модель нашла область исследований, которая их объединяет: ученые записывают звуки здоровых коралловых рифов, а затем воспроизводят эти записи с помощью подводных динамиков. Воспроизведение звука ускоряет заселение новых кораллов и рыб, помогая рифам быстрее заживать и восстанавливаться.

В процессе создания контента модель также автоматически создала полную запись в блоге, сначала используя инструменты анализа данных для создания визуализаций, а затем используя Canvas для создания записи в блоге с прикрепленными цитатами и источниками.

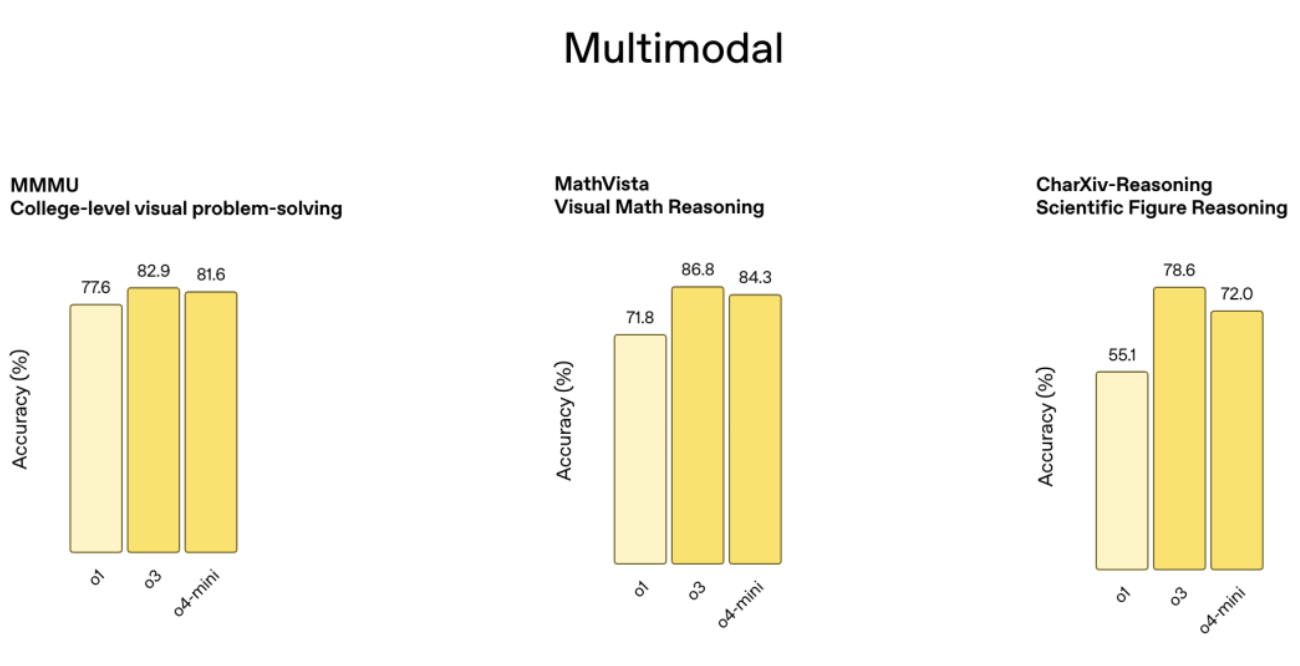

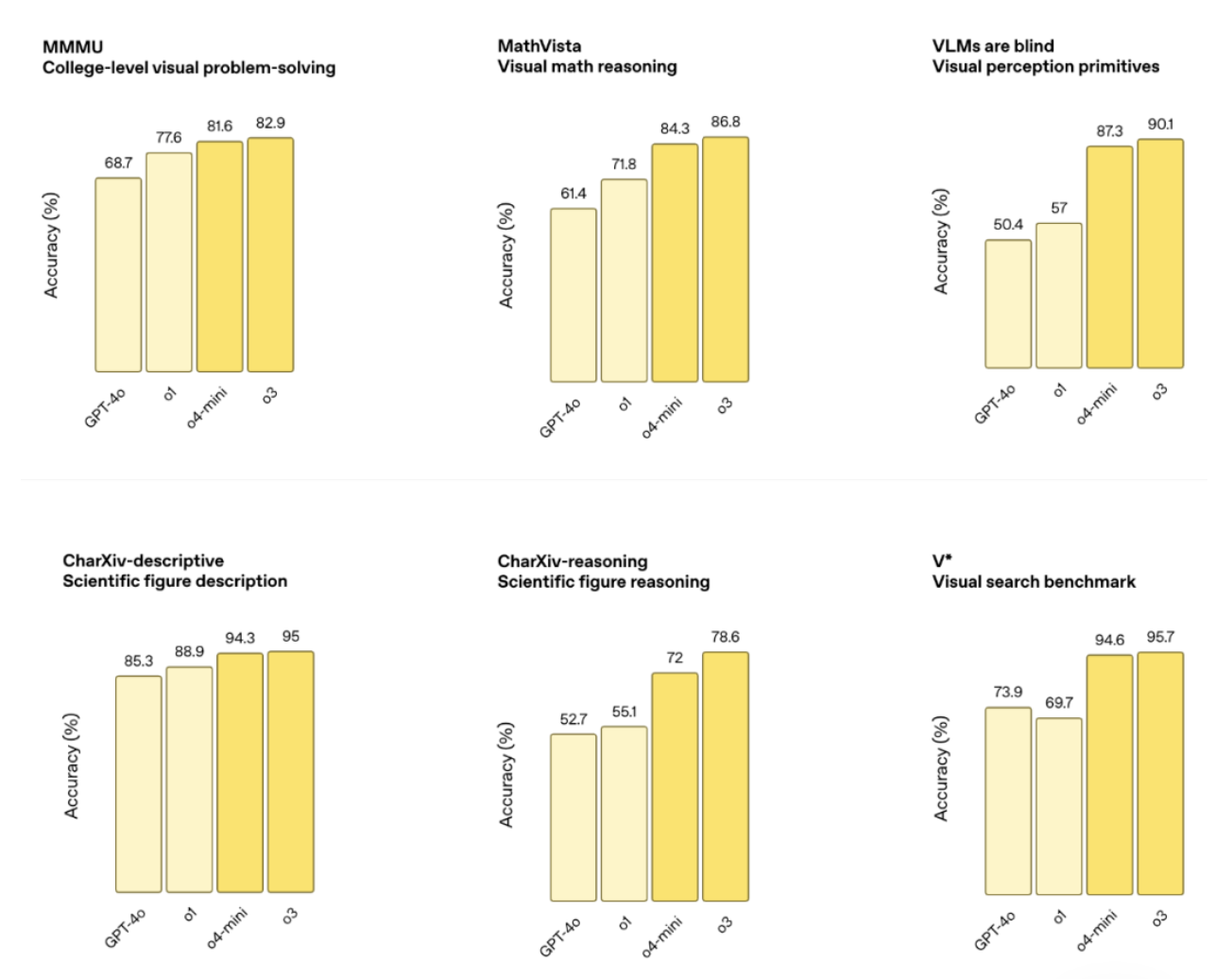

Будучи новейшей флагманской моделью вывода, o3 установила новые рекорды в области программирования, математики, науки и визуального восприятия, такие как тесты Codeforces, SWE-bench и MMMU, с точностью визуальной задачи 87,5% и MathVista 75,4%.

Внешняя экспертная оценка показывает, что у o3 также на 20% ниже уровень критических ошибок, чем у o1 в программировании, бизнес-консалтинге и творческом мышлении. Он может генерировать и критически оценивать новые гипотезы в области биологии, математики и техники и подходит для сложных запросов.

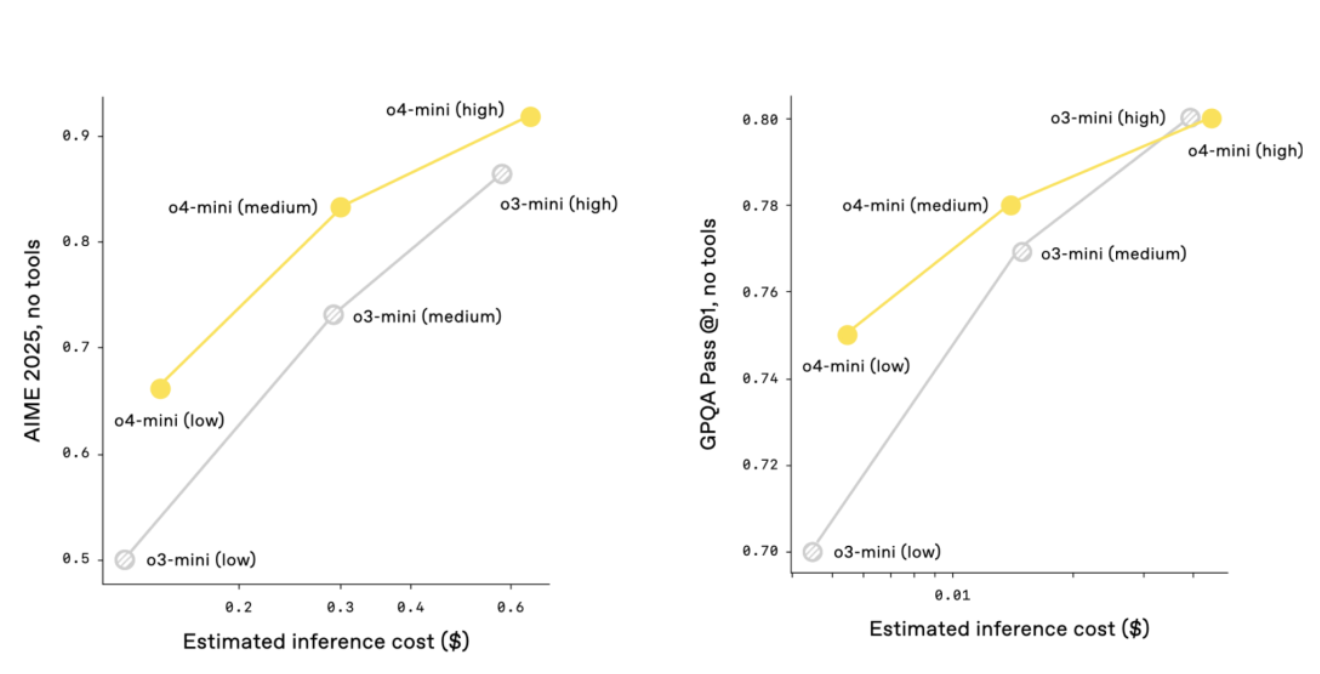

o4-mini «меньше» и оптимизирован для быстрого и недорогого расчета. Точность математических тестов AIME 2024 и 2025 составляет 92,7% и 93,4% соответственно. Он лучше, чем o3-mini, в задачах, не связанных с STEM и наукой о данных. Он очень эффективен, может обрабатывать больше запросов и больше подходит для сценариев, требующих быстрого ответа.

Сравнение производительности показывает, что o3 и o4-mini полностью превосходят предыдущее поколение в таких тестах, как AIME, Codeforces, GPQA и MMMU, а также значительно улучшены отслеживание команд и качество ответа. В сочетании с функцией памяти и ссылками на исторические диалоги ответы становятся более персонализированными и актуальными.

На протяжении всего процесса разработки OpenAI o3 компания OpenAI заметила, что крупномасштабное обучение с подкреплением демонстрирует ту же тенденцию: «чем больше объем вычислений, тем выше производительность», что и при предварительном обучении серии GPT.

На этом пути (обучение с подкреплением) OpenAI увеличил на порядок объем обучающих вычислений и времени вывода, но при этом продемонстрировал значительное улучшение производительности. При той же задержке и стоимости, что и o1, o3 работает лучше и дает больше времени на размышления, а эффект может быть лучше.

OpenAI, который не забывает рисовать картинки, также заявил, что o3 и o4-mini продемонстрировали тенденцию интеграции возможностей рассуждения серии o и естественного диалога и использования инструментов серии GPT, и ожидается, что будущая модель (GPT-5) будет дополнительно интегрировать эти преимущества, чтобы предоставить пользователям более интеллектуальный и практичный опыт.

Я могу «думать» с помощью картинок, но иногда «думаю слишком много».

OpenAI o3 и o4-mini также являются новейшими моделями визуального мышления в серии o.

Как понять модель визуального мышления? Согласно официальному описанию, модель впервые напрямую интегрирует изображения в цепочку мышления, открывая новый метод решения проблем, объединяющий визуальное и текстовое мышление.

Благодаря таким инструментам, как анализ данных Python, веб-поиск и создание изображений, он также может решать более сложные задачи.

Загрузите фотографии с доски, схемы из учебника или нарисованные от руки эскизы. Даже если изображение размытое, перевернутое или плохого качества, модель может точно интерпретировать его и напрямую вызывать инструменты для обработки изображения, включая обрезку, поворот, масштабирование и другие операции.

Важно то, что эти функции являются нативными и не требуют отдельной выделенной модели.

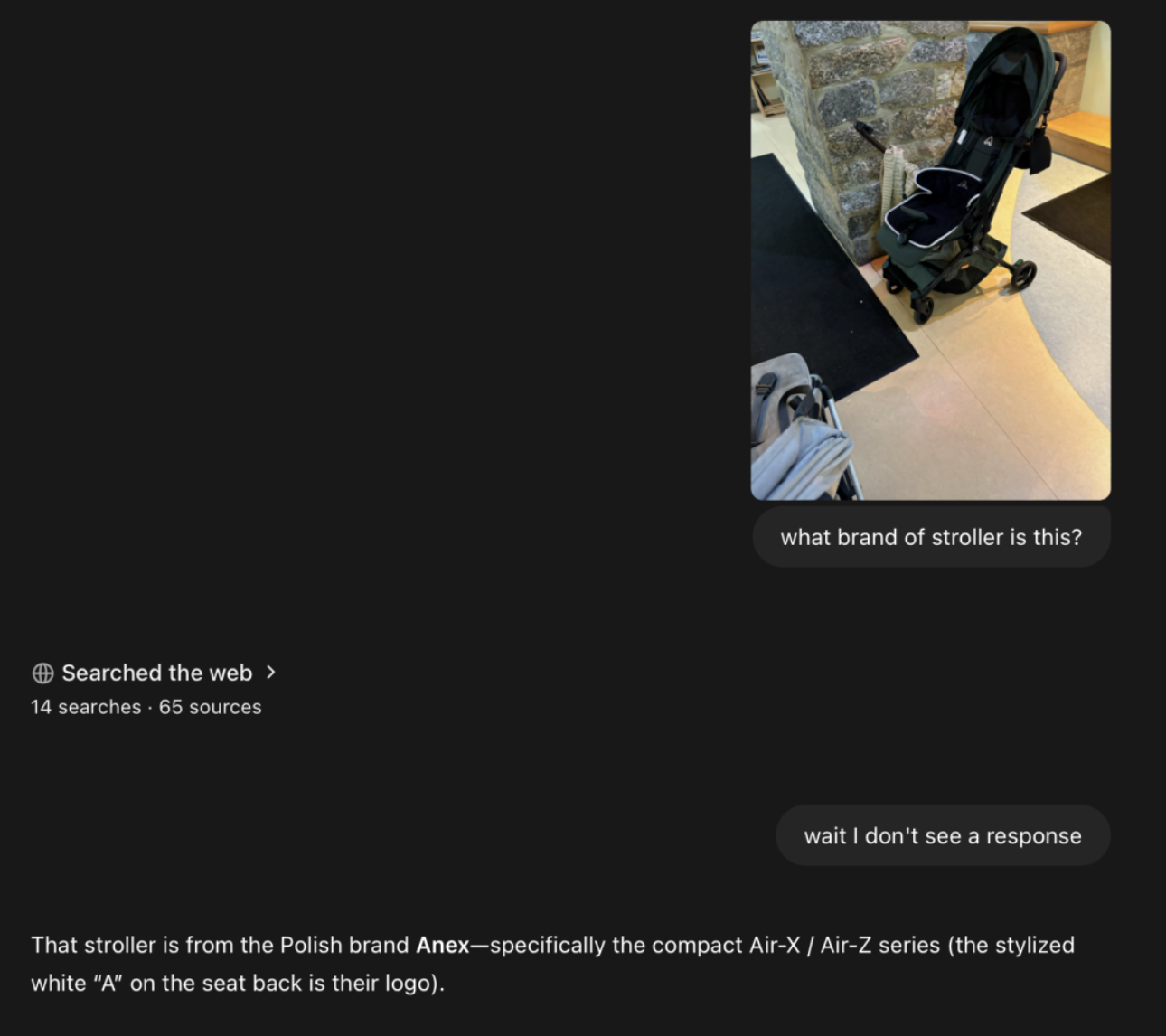

Блогер @danshipper нашел марку коляски по размытой фотографии, и, судя по ней, на протяжении всего процесса были просмотрены десятки веб-страниц.

Я также загрузил фотографию здания Укан, и o3 точно определил, что здание расположено недалеко от улицы Хуайхай. Однако в ответе не было указано название здания.

Конечно, такой образ мышления не лишен «недостатков»:

- Слишком много думать: модель может слишком полагаться на инструменты или обработку изображений, что приводит к длинным цепочкам рассуждений.

- Неправильные представления: даже если инструменты используются правильно, визуальное непонимание может привести к неправильным ответам.

- Нестабильно: если вы попытаетесь решить одну и ту же задачу несколько раз, модель может использовать разные пути рассуждения, и некоторые результаты могут быть неверными.

Codex CLI бесплатен и имеет открытый исходный код. Действительно ли OpenAI открыт?

o3 и o4-mini превосходят предыдущее поколение с точки зрения экономической эффективности. В тесте AIME 2025 года соотношение цена/производительность полностью превзошло o1 и o3-mini. Они умнее и экономичнее.

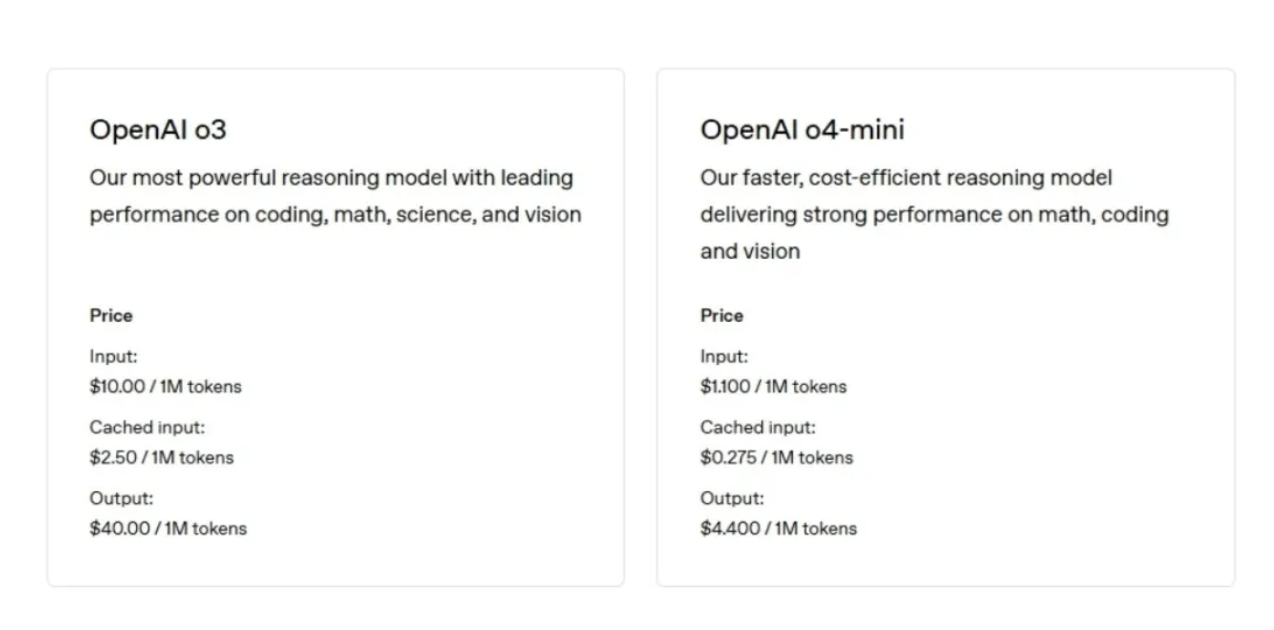

o3 стоит 10 долларов за миллион токенов для ввода (приблизительно 750 000 слов, что больше, чем в серии «Властелин колец») и 40 долларов за миллион токенов для вывода.

o4-mini стоит 1,10 доллара США за миллион токенов на входе и 4,40 доллара США за миллион токенов на выходе.

Не так давно выяснилось, что время тестирования безопасности OpenAI сократилось с месяцев до дней. Системные карты o3 и o4-mini показывают, что OpenAI реконструировал набор данных для обучения безопасности и добавил запросы на отказ от биологических угроз, создания вредоносного ПО и атак с джейлбрейком.

Согласно последней системе готовности, риски для o3 и o4-mini находятся ниже «высокого» порога в областях биологии и химии, кибербезопасности и самосовершенствования ИИ.

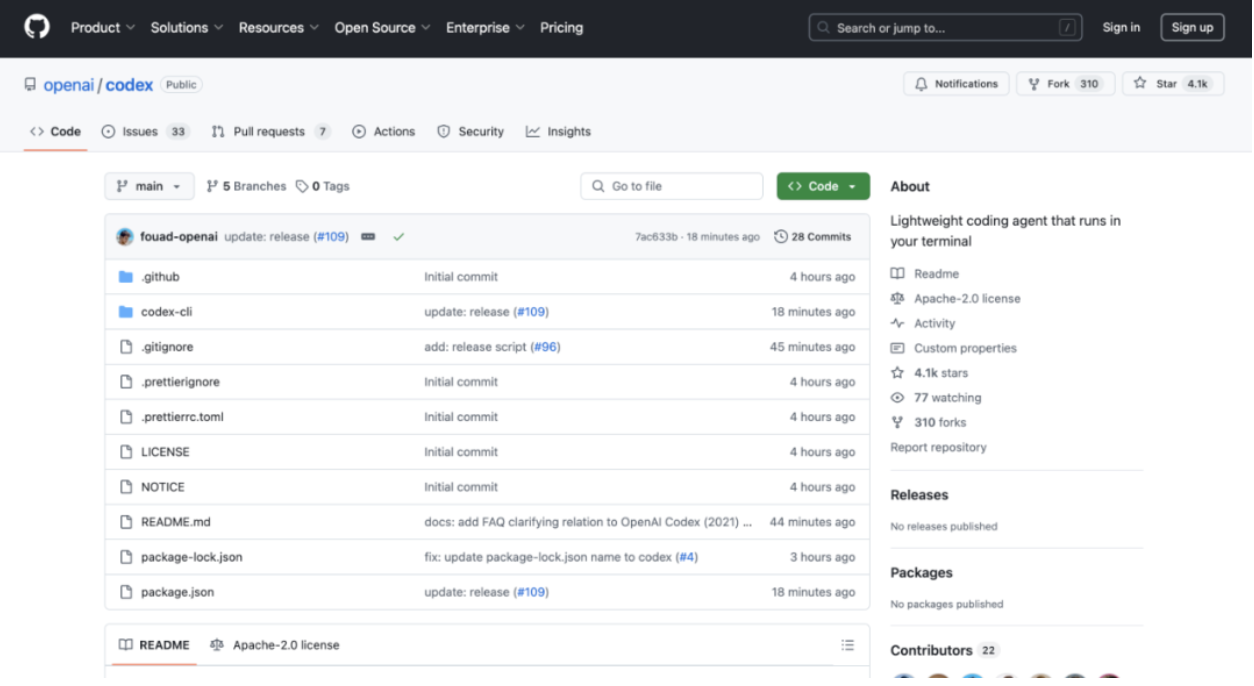

▲К изображению прикреплен адрес Codex CLI GitHub: https://github.com/openai/codex.

Хоть агент и опаздывает, он прибыл. OpenAI также выпустила облегченный агент терминального кодирования — Codex CLI.

Основываясь на возможностях рассуждения o3 и o4-mini, Codex CLI поддерживает мультимодальный ввод и доступен на GitHub с открытым исходным кодом. Кроме того, OpenAI также запустила план на 1 миллион долларов США для поддержки связанных проектов и принимает заявки на финансирование для баллов API в размере 25 000 долларов США.

На этот раз OpenAI действительно открыт.

По имеющимся данным, Кодекс имеет два режима работы: один — «рекомендательный режим» (по умолчанию): команды предлагаются для подтверждения пользователя, а другой — «полностью автоматический режим»: доступ к сети отключен, что позволяет Агенту работать автономно, но оставаться в безопасности.

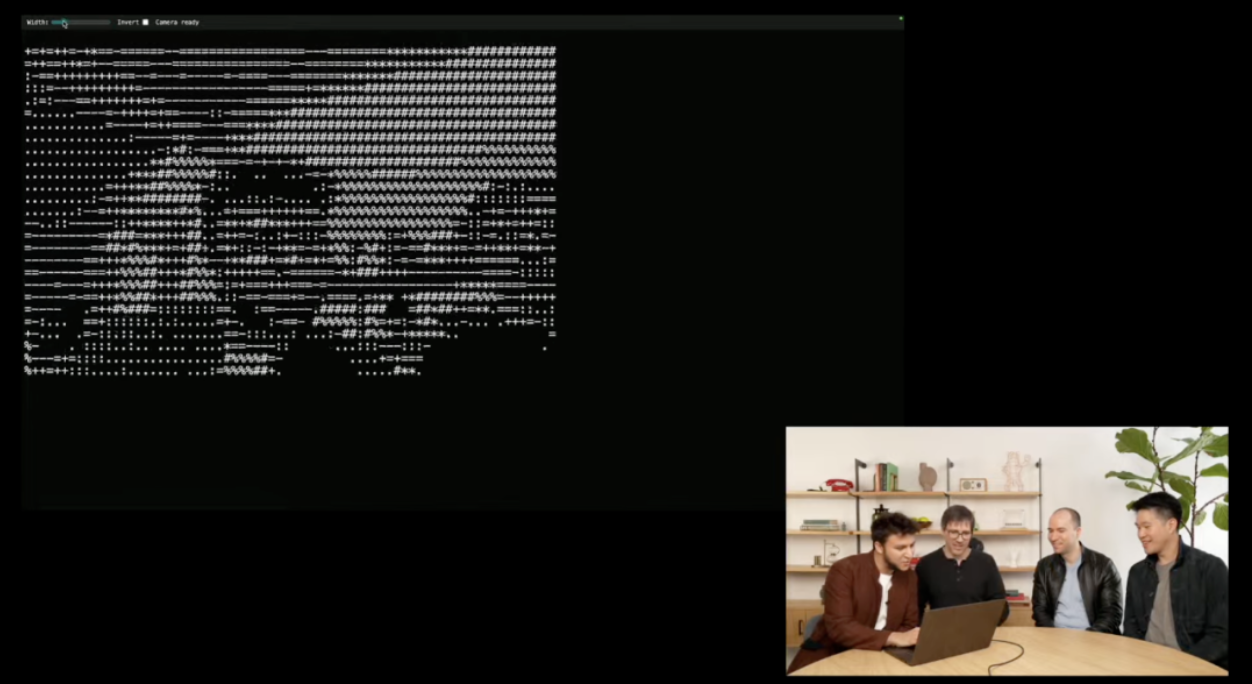

Во время живой демонстрации исследователи OpenAI перетащили снимки экрана в терминал, а интерфейс командной строки Codex проанализировал изображения с помощью мультимодальных рассуждений, получил доступ к пользовательским файлам и, наконец, сгенерировал файлы HTML, создал генератор изображений ASCII и успешно добавил API веб-камеры.

Стоит отметить, что, по данным Bloomberg, OpenAI планирует приобрести компанию Windsurf, занимающуюся разработкой инструментов для программирования искусственного интеллекта, примерно за 3 миллиарда долларов США. Если приобретение окажется успешным, оно станет крупнейшим приобретением OpenAI на сегодняшний день.

В отчете отмечается, что после завершения сделки OpenAI сможет более напрямую конкурировать с такими компаниями, как Anthropic, Github, принадлежащий Microsoft, и Anysphere, тем самым заняв место на быстрорастущем рынке инструментов программирования искусственного интеллекта.

«Уровень гения» o3 побудил Альтмана вперед и на поддержку, но на эти вопросы не было дано правильного ответа…

Некоторые блоггеры X-платформы заранее смогли испытать новую модель и поделились своим опытом.

@danshipper, испытавший это в течение недели, сказал, что o3 быстр, очень «действенен», чрезвычайно умен и в целом ощущения отличные. Любимые варианты использования включают:

- Разработал краткий курс по машинному обучению и напомнил блоггерам, что нужно учиться каждое утро.

- Нашел марку коляски по размытому фото

- Написал новую программу тестирования искусственного интеллекта на сверхбыстрой скорости.

- Проанализировал классическую часть творчества Энни Диллард, как рентген, обнаружив навыки письма, которые блоггеры никогда раньше не замечали.

- Просматривайте протоколы встреч, чтобы поймать блоггеров, пытающихся избежать конфликта.

- Проанализировав организационную структуру, какие продукты рекомендуется запускать и где имеются недостатки?

@DeryaTR_, доктор медицинских наук, считает o3 умным: «Когда я задаю o3 сложный клинический или медицинский вопрос, его ответы звучат так, будто их исходит от лучшего врача: точные, всесторонние, основанные на фактических данных и уверенные в себе, с максимальным профессионализмом, которого мы ожидаем от экспертов в этой области».

Альтман также привел его цитату о том, что «o3 находится на уровне гениальности или близко к нему».

По мнению @DeryaTR_, o4 mini немного более «сдержанный», и детали ответов не такие подробные, как o3. Он может быть более лаконичным и плавным, создавая у людей ощущение элегантности, и даже может быть более «эмоциональным».

Конечно, мы также протестировали некоторые проблемы.

Жил-был старый часовщик, который установил для церкви большой колокол. Он был стар и ослеплен и неправильно собрал длинные и короткие иглы. Короткая игла двигалась в 12 раз быстрее, чем длинная. Во время собрания было 6 часов утра. Он указал короткой стрелкой на «6», а длинной — на «12». Старый часовщик установил его и пошел домой. Люди какое-то время смотрели на часы: было 7 часов, а потом было 8 часов. Они были очень удивлены и сразу пошли к старому часовщику. Когда пришел старый часовщик, было уже семь часов вечера. Он достал пару карманных часов, и часы были точными. Он заподозрил, что люди над ним подшучивают, и вернулся, когда разозлился. Часы по-прежнему показывают 8 и 9 часов, и люди снова идут к часовщику. На следующее утро в 8 часов пришел старый часовщик, чтобы воспользоваться парой часов, которые все еще были точными. Пожалуйста, задумайтесь: сколько было часов в 7 часов, когда старый часовщик впервые отрегулировал свои часы? Сколько сейчас времени — 8:00, когда проверяешь часы во второй раз?

▲o3 Неправильный ответ

Хору U2 нужно добраться до концертной площадки за 17 минут, по пути им придется пересечь мост. Четыре человека стартуют с одного конца моста, и вы должны помочь им дойти до другого конца. Темно, и у них есть только фонарик. Одновременно мост могут пересечь не более двух человек, и при переходе по мосту они должны держать фонарик, поэтому кто-то должен подносить фонарик к обоим концам моста и обратно. Фонарики нельзя раздавать, выбрасывая их. Четыре человека идут с разной скоростью. Если два человека идут вместе, побеждает тот, кто медленнее. Боно требуется 1 минута, чтобы пересечь мост, Эджу требуется 2 минуты, чтобы пересечь мост, Адаму требуется 5 минут, чтобы пересечь мост, а Ларри требуется 10 минут, чтобы пересечь мост. Как они собираются пересечь мост за 17 минут?

▲o4 mini ответил правильно

В следующем фактическом измерении, хотя o3 дал полные шаги рассуждения, ответ снова был неверным.

▲o3 Неправильный ответ

По случаю запуска OpenAI внимательные пользователи сети также обнаружили, что новый Gemini выйдет на следующей неделе (22 апреля).

Ожидается, что в этом месяце также выйдут DeepSeek R2, Claude 4 от Anthropic и GroK-3.5 от Маска.

Даже заглядывая вперед, апрель — самый «задействованный» месяц для ИИ, который во многом определит направление развития ИИ-индустрии в следующем году. Более сильные модели, более низкие затраты и более широкие сценарии также принесут нам более разумное и инклюзивное будущее.

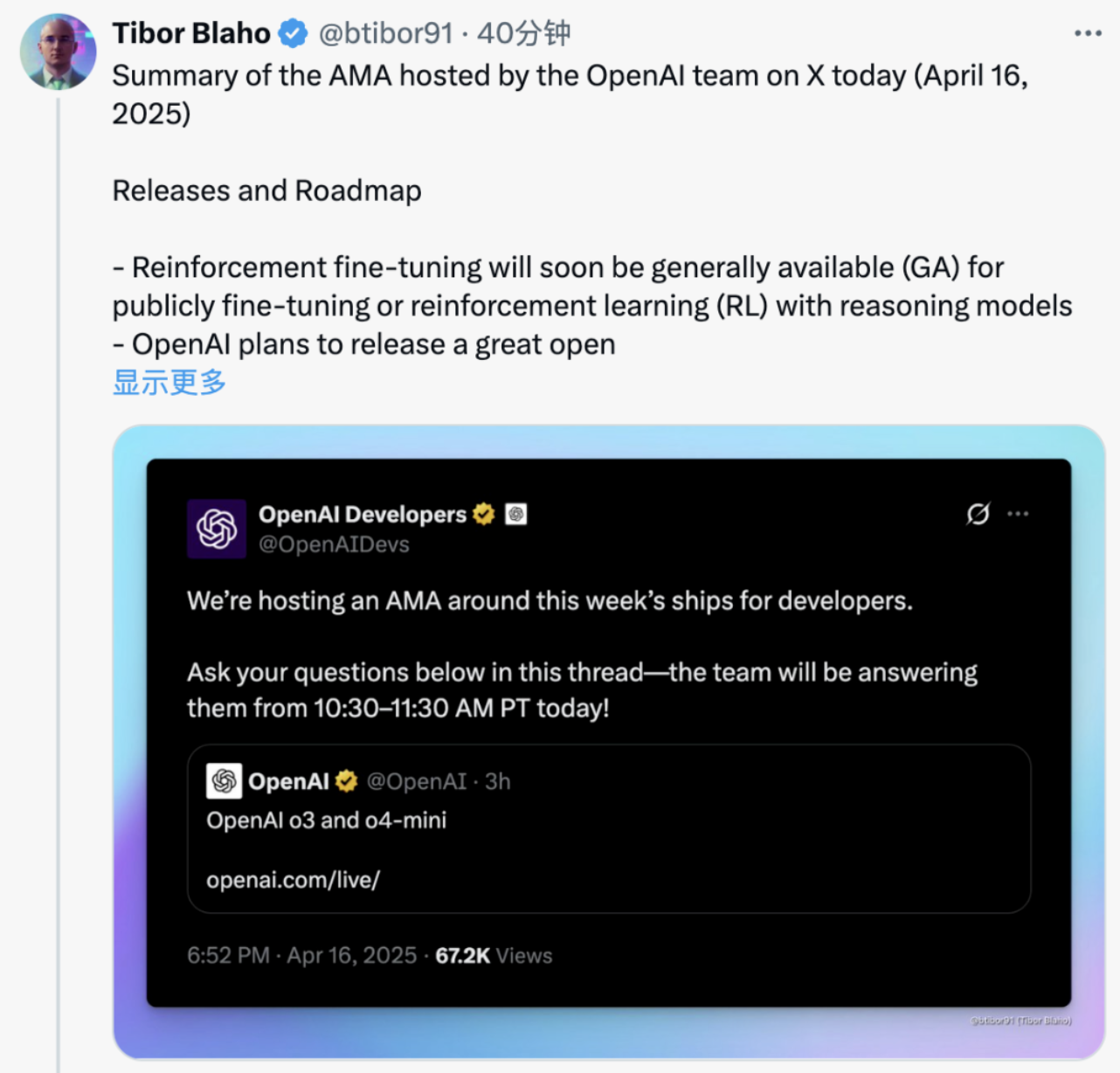

Прилагается краткое изложение AMA, проведенного командой OpenAI на платформе X:

- OpenAI планирует выпустить великолепную открытую модель в ближайшие месяцы, и вскоре в API будут доступны новые возможности генерации изображений.

- o3 теперь доступен в API, а более продвинутая модель o3-pro находится в стадии разработки и, как ожидается, будет выпущена в ближайшее время.

- Скоро станет общедоступной точная настройка подкрепления, что позволит проводить публичную тонкую настройку или использовать модели вывода для обучения с подкреплением (RL).

- В API ответов переключение между сообщениями разработчика и системными сообщениями осуществляется автоматически; отправка системных сообщений в o3 или сообщений разработчика в GPT-4.1 автоматически преобразуется.

- В настоящее время инструменты хостинга не поддерживаются API ChatCompletions или Responses.

- На этапе вывода o3 и o4-mini активно используются такие инструменты, как веб-поиск, поиск файлов и интерпретаторы кода; эти инструменты в настоящее время поддерживаются в ChatGPT, но еще не в API — ожидается, что поддержка будет добавлена в ближайшее время.

- OpenAI активно разрабатывает поддержку потоков в Agents SDK для улучшения истории разговоров и памяти.

- OpenAI считает, что предложения по платформам с низким кодом в Agents SDK интересны, и приветствует отзывы разработчиков о наиболее полезных функциях.

- Интерфейс командной строки Кодекса включает несколько документированных режимов утверждения, позволяющих пользователю выбирать режим для каждой операции или сеанса.

- Codex CLI не предназначен для замены таких инструментов IDE, как Cursor и Windsurf; он предназначен для запуска фоновых задач, пока пользователь использует основную IDE.

- Сравните возможности кодирования Codex и возможности углубленного исследования в зависимости от выбранной модели (o3 или o4-mini); Кодекс специально использует вызовы функций для выполнения команд непосредственно на компьютере пользователя.

- Новая модель в первую очередь обучена на браузерах общего назначения, инструментах выполнения кода Python/кода и определяемых пользователем инструментах, полезных для разработчиков.

- Хотя GPT-4.5 более мощный, но медленный и требует больших вычислительных ресурсов, GPT-4.1 предоставляет разработчикам более быстрый и экономичный вариант.

- Некоторые улучшения GPT-4.1 были интегрированы в ChatGPT, и в будущем будут реализованы дополнительные улучшения.

- OpenAI признает, что существует путаница в названиях моделей, таких как «4o» и «o4», и планирует в ближайшее время упростить именование моделей.

# Добро пожаловать на официальную общедоступную учетную запись WeChat aifaner: aifaner (идентификатор WeChat: ifanr). Более интересный контент будет предоставлен вам как можно скорее.

Ай Фанер | Исходная ссылка · Посмотреть комментарии · Sina Weibo