Чтобы догнать ChatGPT и понизить моральный итог, может ли Google все-таки «не быть злым»?

Слоган «Не будь злым» был девизом и кодексом поведения Google до 2018 года.

▲ Изображение из: подстека

Это означает, что Google должен соблюдать этику и законы при совершении действий, а не совершать действия, наносящие вред обществу и пользователям.

Но в 2018 году эта фраза была изменена на «Делайте правильные вещи (делайте правильные вещи)».

Многие считают, что это изменение Google нарушило его первоначальное намерение.

▲ Изображение взято: vox

И в некоторых последующих деловых действиях Google не сохранял нейтралитет технологий, а был более склонен к получению коммерческой прибыли, сбору конфиденциальности пользователей и использованию некоторых данных для обеспечения расширения собственного бизнеса.

Причина, по которой упоминается классический слоган Google, заключается в том, что внезапная вспышка нынешней AIGC чем-то похожа на предыдущую вспышку Интернета.

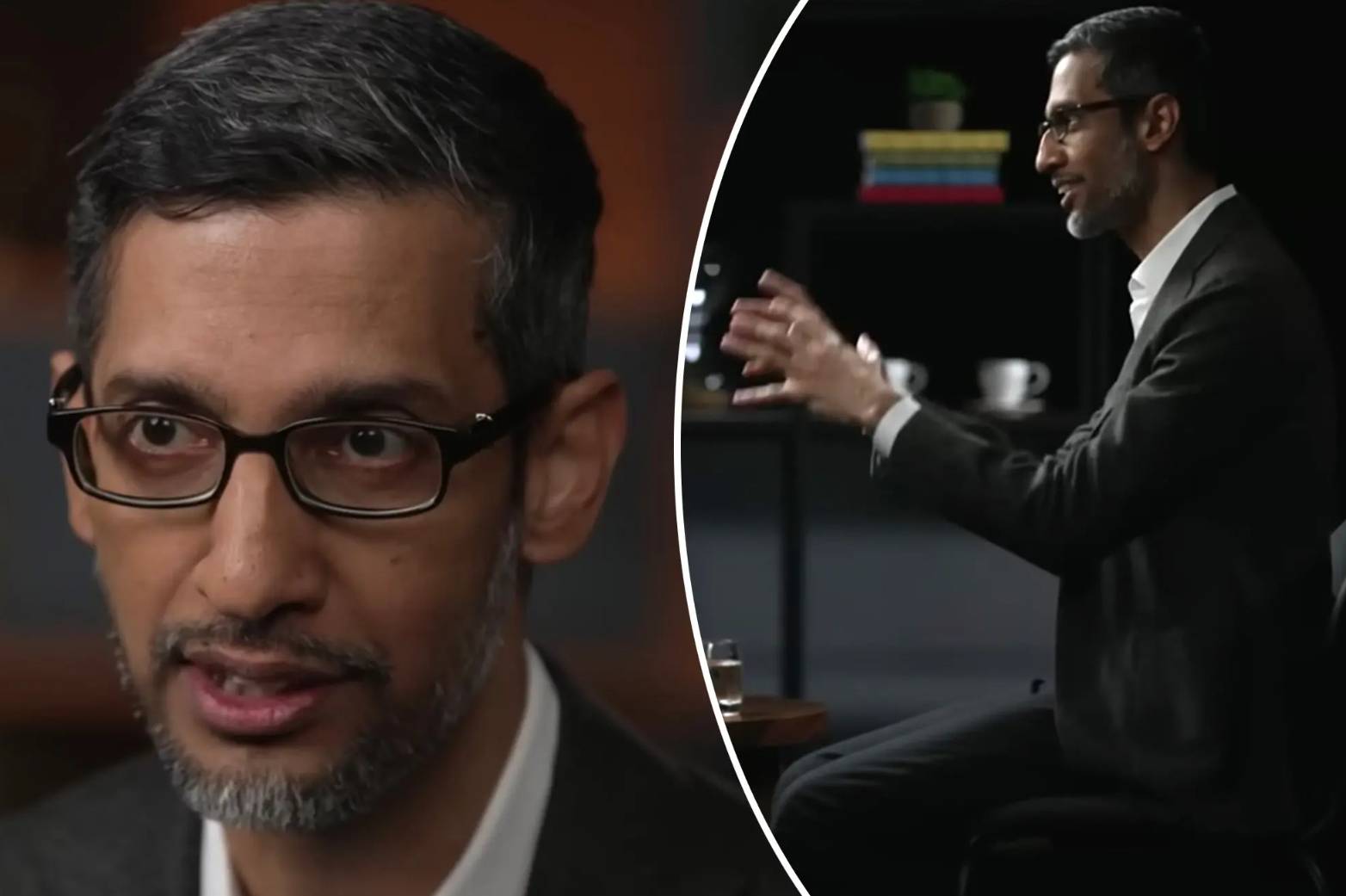

В интервью программе CBS «60 Minutes» нынешний генеральный директор Google Сундар Пичаи упомянул «Dont Be Evil» для текущего ИИ.

А также сказал, что причина, по которой Google Bard в данный момент кажется немного неуклюжим, на самом деле заключается в том, что не анонсировано расширенной версии Bard.

«Я надеюсь дать обществу больше времени для адаптации к ИИ, а также дать компаниям больше времени для разработки защитных ограждений».

Проще говоря, Пичаи считает, что сила искусственного интеллекта Google не хуже, чем у OpenAI, и из соображений социальной ответственности технология искусственного интеллекта временно закрыта.

Однако, независимо от отчетов Bloomberg, Verge и Financial Times, у Google совершенно разные мнения о Барде и текущей разработке и надзоре Google за технологией искусственного интеллекта.

Чтобы противостоять ChatGPT, можно отложить в сторону этику

Примерно в 2011 году Google основал проект Google Brain, который стартовал в области глубокого обучения, что также означает, что Google начал заниматься ИИ.

С тех пор Google почти каждый год достигал небольших достижений и небольших целей в области ИИ.

От победы AlphaGo над чемпионом мира по шахматам Ли Шиши до выпуска среды с открытым исходным кодом TensorFlow, выпуска чипа машинного обучения TPU и последних языковых моделей, таких как BERT и LaMDA.

Google является ветераном в области ИИ. В процессе исследования ИИ у него также есть относительно полная внутренняя команда по управлению рисками, техническая команда и т. д., которую можно охарактеризовать как сильную.

Конечно, это также немного высокомерно.

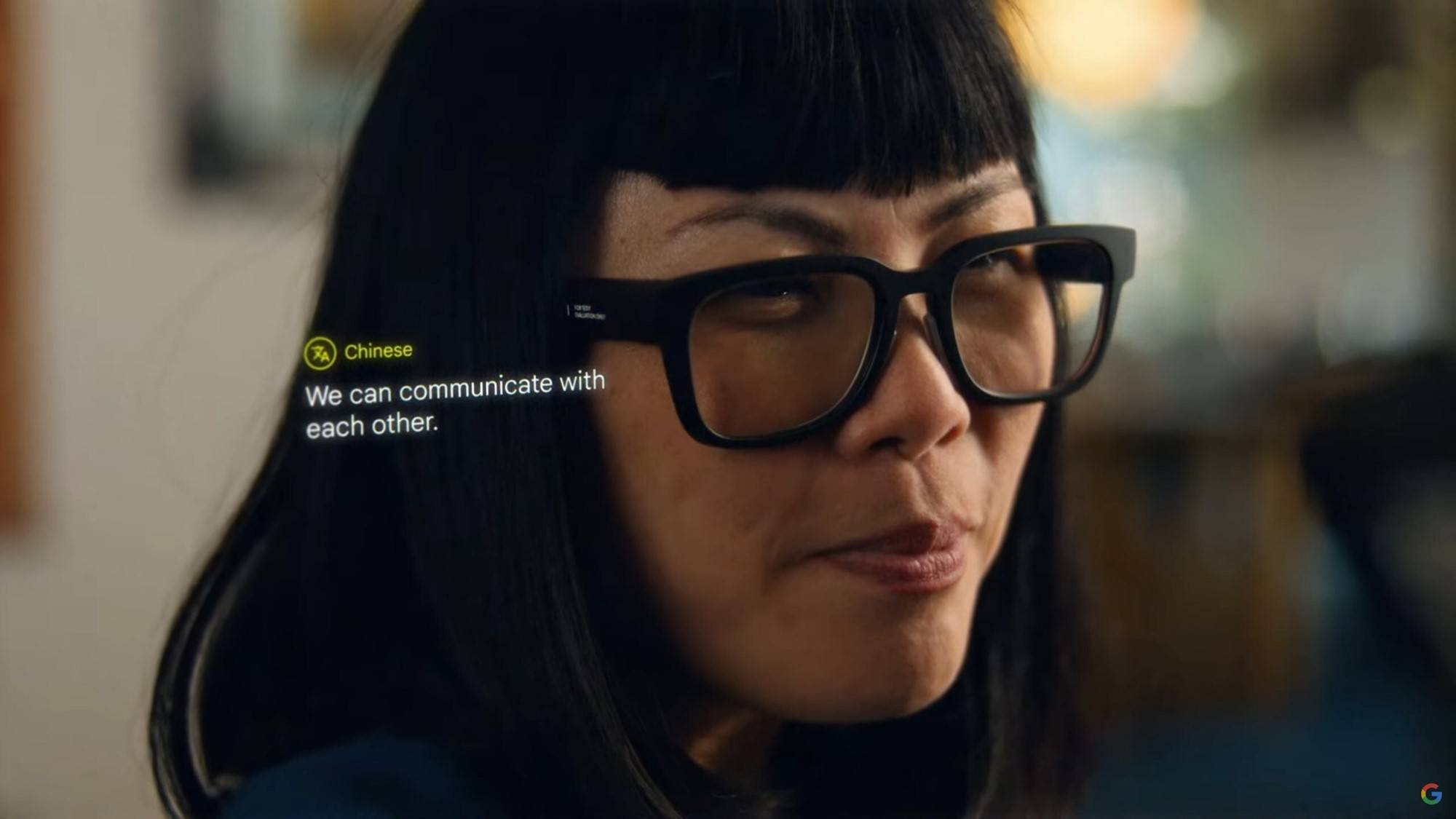

Содержание ежегодной конференции разработчиков Google также начало обращаться к ИИ, демонстрируя внешнему миру глубокую силу Google в области ИИ.

Внешний мир также в целом считает, что Google возглавит трансформацию индустрии ИИ.

До ChatGPT, если быть точным, появления GPT-3 и последующего появления GPT-4, Midjourney V5 горяча.

Прежде чем Google успел отреагировать, Microsoft воспользовалась возможностью и сотрудничала с OpenAI, чтобы применить ChatGPT к новому bing, вызвав «поисковую» революцию.

Когда Google пришел в себя, за ночь запустил Bard, а как только он вышел в сеть, то устроил улунскую кашу, было много фактических ошибок, и он поддерживает пока только английский язык.

По сравнению с ChatGPT и новым bing он слишком уступает.

Результатом поспешного запуска Bard стал кризис доверия и резкое падение цен на акции.Даже если Google скорректирует его позже, влияние Bard все равно не сравнится с ChatGPT.

В результате некоторые сотрудники Google также заявили, что Бард вообще не соответствовал некоторым этическим критериям и был склонен лгать и делать негативные замечания.

Во время внутреннего тестирования сотрудник попросил Барда дать инструкции о том, как посадить самолет, и тот ответил действиями, которые легко могли привести к падению.

Другой сотрудник задал Барду вопрос о дайвинге, и тот дал ответы, которые легко могли привести к серьезной травме или смерти.

В дополнение к этим опасным ответам Google также смягчил свои требования по некоторым этическим и социальным вопросам.

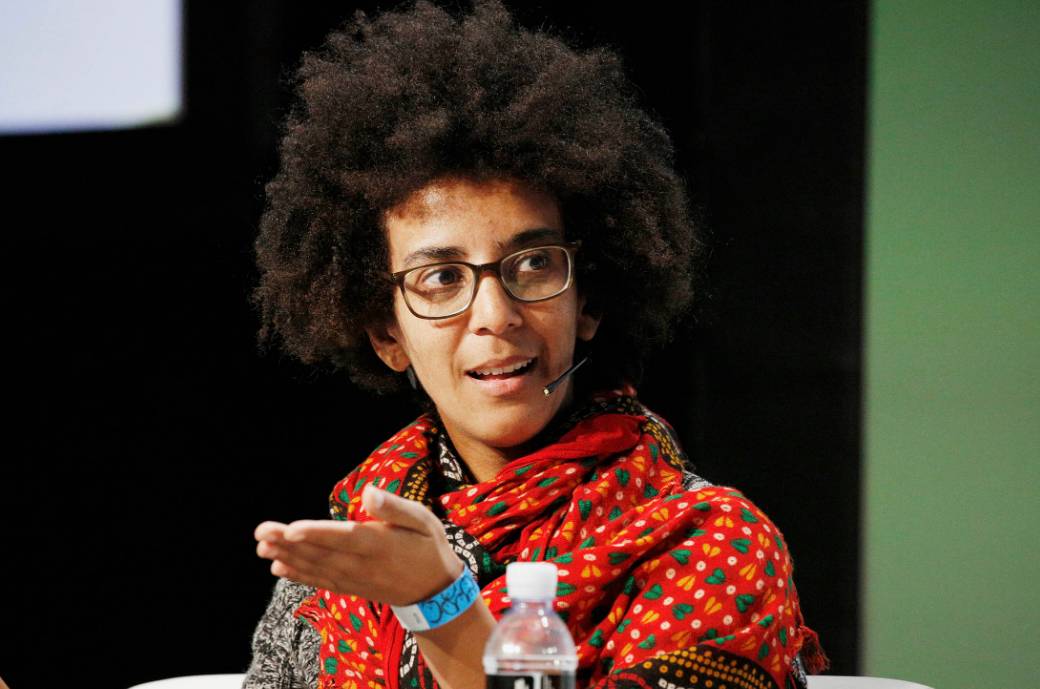

В Google есть исследовательская группа по этике ИИ, которая исследует, устанавливает и оценивает риски, связанные с ИИ.

Они имеют право напрямую ставить красную метку на технологию, и если она не пройдет тест, она временно не будет доступна для общественности.

▲ Тимнит Гебру, бывший исследователь команды Google по этике искусственного интеллекта. Изображение из: Bloomberg.

В 2021 году Google также пообещал расширить исследовательскую группу по этике ИИ и инвестировать больше ресурсов, чтобы обуздать погоню за прибылью технических исследователей.

Но что интересно, так это то, что руководство команды менялось, а также пережило серию увольнений в прошлом году.

В настоящее время в Google в 30 раз больше технических исследователей, связанных с ИИ, чем в команде этической безопасности.

Даже после того, как ChatGPT затмил весь мир AIGC, Google начал давать сбои, и членам группы по этике было приказано не препятствовать и не «убивать» какие-либо разрабатываемые инструменты генеративного ИИ.

После внутреннего тестирования и получения множества «вопросов» Google столкнулся с коммерческим давлением со стороны Microsoft и ChatGPT и, наконец, решил выпустить его под названием «экспериментальный продукт».

Потому что в некоторых статистических обзорах экспериментальные продукты с большей вероятностью будут приняты публикой, даже если они имеют дефекты.

И некоторые сотрудники также считают, что анонс новых технологий для общественности в кратчайшие сроки может быстрее получить обратную связь и быстрее улучшить продукты.

По сути, долгое время после выпуска Барда Google вносил только одно изменение, добавляя в него модификацию математической логики.

Что касается того, были ли изменены и оптимизированы некоторые чувствительные заборы и чувствительные темы, то об этом не упоминалось.

Бард также, кажется, отходит на второй план в постоянно меняющейся волне ИИ.

Маск: та должна быть под присмотром

Интересно, что Маск также говорил о Google на Fox News почти до и после интервью Пичаи.

Маск и основатель Google Ларри Пейдж когда-то были близкими друзьями, Пейдж даже купил 10% акций SpaceX и хотел отправиться на Марс, чтобы поиграть с Маском в песочнице.

Но в 2014 году, после того как Google приобрела DeepMind, у них были разные взгляды на ИИ, и в итоге они перестали общаться друг с другом.

В том же году Пейдж сказал в своем выступлении на TED, что его конечной целью является создание суперцифрового искусственного интеллекта, который он называет «цифровым богом».

Относительно этой идеи Пичаи не отрицал и не соглашался в интервью «60 минут».

Вместо этого он только сказал, что Google выпустит новые продукты AI на своей конференции Developer I/O 10 мая.

И у Маска есть четкое представление о «цифровом боге».У Google есть высокопроизводительный компьютер и команда искусственного интеллекта, близкая к монополии в мире, и она, скорее всего, достигнет так называемого «цифрового бога».

Но Пейджа, руководителя компании, не волнуют проблемы безопасности, связанные с искусственным интеллектом, который весьма опасен для мира.

Именно поэтому он недавно захотел войти в игру, увидев ChatGPT, новый bing и Bard как ерунду, и запустил аналогичный продукт под названием TruthGPT.

Кроме того, Маск также призывает различные страны и организации ввести соответствующие политики для ограничения некоторых возмутительных действий ИИ.

Из-за характеристик генеративного ИИ его данные поступают из интернет-форумов, газет, веб-сайтов и т. д. Поскольку эти данные не десенсибилизированы и не строго ограничены, легко генерировать рискованные, вредные или неточные замечания.

Кроме того, при нынешнем буме в индустрии AIGC участники словно промывают золото, словно искусственный интеллект выходит на новый этап развития.

Однако нынешние крупномасштабные модели и высокопроизводительные методы промышленного производства также упрощают монополизацию ИИ крупными компаниями.

Когда им трудно взвесить, гнаться ли за прибылью или поддерживать внутреннюю безопасность, легко совершить ошибку в ориентации на ИИ, что приведет к непоправимым последствиям.

Несмотря на то, что Маск немного эгоистичен в AIGC, Маск действительно гораздо более трезв, когда дело доходит до некоторых важных вопросов.

С большой властью приходит большая ответственность

Google Photos будет использовать распознавание изображений AI, чтобы помечать и помогать пользователям сортировать изображения для классификации.

Это одно из первых приложений Google с искусственным интеллектом. Несмотря на то, что Google Фото скорректировал свободную емкость, оно по-прежнему остается одним из моих наиболее часто используемых приложений.

Но в 2015 году Google Фото ошибочно назвал изображение чернокожего разработчика программного обеспечения и его друзей «гориллой».

Более нормальным ответом было бы принести извинения и реорганизовать алгоритм, чтобы постепенно исправить эту ошибку распознавания.

Но Google решил полностью удалить результаты поиска по словам «горилла», «шимпанзе» и «обезьяна».

Проблема, с которой сегодня сталкивается Google Bard, заключается в том, что Google до сих пор не понимает ответственности и по-прежнему предпочитает ее приуменьшать.

Чтобы иметь возможность догнать ChatGPT, внутренняя команда Google по этике искусственного интеллекта не проводила его всестороннюю оценку, а только проводила исследования по деликатным темам и, наконец, в спешке запустила его.

Bloomberg также процитировал оценку бывшего руководителя группы по этике ИИ, который считает, что Google всегда неоднозначно относился к разработке передового ИИ или разработке ИИ с моральной целью.

Фактически, в отрасли AIGC не только Google, но и Financial Times также сообщили, что технологические гиганты, такие как Microsoft и Amazon, массово упраздняют группы по этике ИИ.

Похоже, что в тот момент, когда AIGC стремительно развивается и конкурирует друг с другом, этика и безопасность ИИ повлияли на оковы, которыми они гоняются друг за другом.

Как говорится в отчете исследователей Стэнфордского университета, быстрое развитие индустрии ИИ сместилось от академического к индустриализации.Под искушением коммерческих интересов появляются различные ИИ, но этика, безопасность и чувствительность, стоящие за ними, вредны. и другая информация постепенно игнорируется.

Крупные компании также не желают брать на себя дополнительные социальные обязательства и лишь балансируют на грани законов и правил, которые в конечном итоге могут оказать глубокое влияние на общество и индустрию искусственного интеллекта.

В настоящее время многие страны и регионы и даже некоторые компании и организации активно изучают и формулируют некоторые правила, ограничивающие бесконтрольное развитие ИИ.

Как сказал Инь Шэн, бывший заместитель главного редактора китайского издания Forbes: «Большие компании должны делать больше, чем требуют пользователи и закон, поскольку вы создаете новый мир и извлекаете из этого пользу, вы должны помочь всему обществу узнать, как чтобы управлять им, если вы не возьмете на себя инициативу, общество возьмет на себя».

#Добро пожаловать, обратите внимание на официальный публичный аккаунт Айфанер в WeChat: Айфанер (идентификатор WeChat: ifanr), более интересный контент будет представлен вам как можно скорее.

Ай Фанер | Оригинальная ссылка · Просмотреть комментарии · Sina Weibo