Что нужно знать о средствах защиты детей от Apple

Apple недавно объявила о новых средствах защиты детей, которые появятся этой осенью с выходом iOS 15, iPadOS 15 и macOS Monterey.

Ниже мы подробнее рассмотрим эти расширенные функции безопасности детей и технологии, лежащие в их основе.

Сканирование материалов о сексуальном насилии над детьми

Наиболее заметным изменением является то, что Apple начнет использовать новую технологию для обнаружения изображений с изображениями жестокого обращения с детьми, хранящимися в iCloud Photos.

Эти изображения известны как материалы о сексуальном насилии над детьми или CSAM, и Apple сообщит о них в Национальный центр пропавших без вести и эксплуатируемых детей. NCMEC является центром отчетности CSAM и работает с правоохранительными органами.

Сканирование Apple CSAM при запуске будет ограничено Соединенными Штатами.

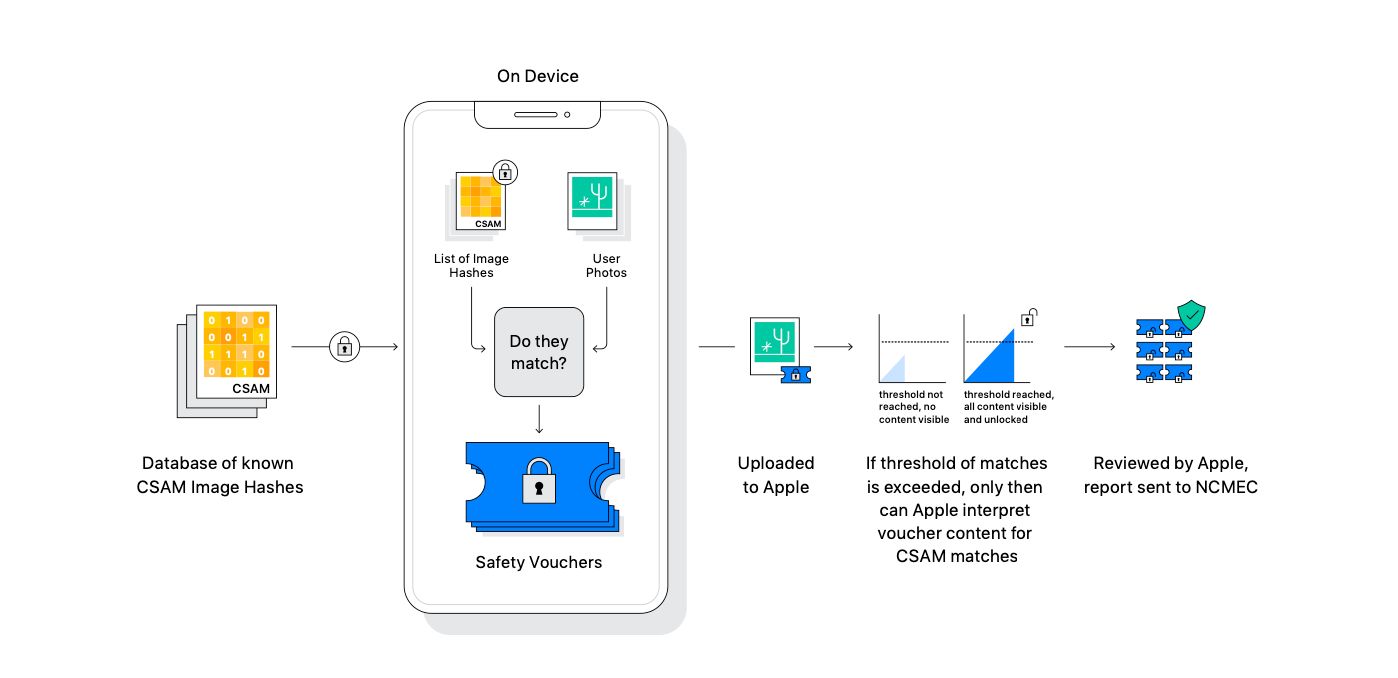

Apple заявляет, что система использует криптографию и была разработана с учетом конфиденциальности. Перед загрузкой в Фото iCloud изображения сканируются на устройстве.

По словам Apple, не нужно беспокоиться о том, что сотрудники Apple увидят ваши настоящие фотографии. Вместо этого NCMEC предоставляет Apple хэши образов CSAM. Хеш берет изображение и возвращает длинную уникальную строку букв и цифр.

Apple берет эти хэши и преобразует данные в нечитаемый набор хэшей, надежно хранящийся на устройстве.

Перед синхронизацией изображения с фотографиями iCloud оно сравнивается с изображениями CSAM. С помощью специальной криптографической технологии – частного пересечения множеств – система определяет, есть ли совпадение, не показывая результата.

Если есть совпадение, устройство создает ваучер криптографической безопасности, который кодирует совпадение вместе с более зашифрованными данными об изображении. Этот ваучер загружается в Фото iCloud вместе с изображением.

Если учетная запись iCloud Photos не превышает определенный порог содержимого CSAM, система гарантирует, что Apple не сможет прочитать ваучеры безопасности. Это благодаря криптографической технологии, называемой разделением секретов.

Согласно Apple, неизвестный порог обеспечивает высокую точность и гарантирует менее одного случая на один триллион неправильной отметки учетной записи.

Когда порог будет превышен, технология позволит Apple интерпретировать ваучеры и соответствующие изображения CSAM. Затем Apple вручную просматривает каждый отчет, чтобы подтвердить соответствие. В случае подтверждения Apple отключит учетную запись пользователя, а затем отправит отчет в NCMEC.

Если пользователь считает, что его учетная запись была ошибочно помечена технологией, будет подана апелляция.

Если у вас есть проблемы с конфиденциальностью в новой системе, Apple подтвердила, что фотографии не будут сканироваться с использованием технологии криптографии, если вы отключите iCloud Photos. Вы можете сделать это, выбрав « Настройки»> [Ваше имя]> iCloud> Фотографии .

При отключении Фото iCloud есть несколько недостатков. Все фото и видео будут храниться на вашем устройстве. Это может вызвать проблемы, если у вас много изображений и видео и старый iPhone с ограниченным хранилищем.

Кроме того, фотографии и видео, снятые на устройстве, не будут доступны на других устройствах Apple, использующих учетную запись iCloud.

Apple объясняет больше о технологии, используемой для обнаружения CSAM, в техническом документе PDF . Вы также можете прочитать FAQ Apple с дополнительной информацией о системе.

В FAQ Apple отмечает, что система обнаружения CSAM не может использоваться для обнаружения чего-либо, кроме CSAM. Компания также заявляет, что в США и многих других странах хранение изображений CSAM является преступлением и что Apple обязана сообщить об этом властям.

Компания также заявляет, что откажется от любых требований правительства добавить в список хэшей изображение, не относящееся к CSAM. Это также объясняет, почему изображения, не относящиеся к CSAM, не могут быть добавлены в систему третьей стороной.

Из-за проверки человеком и того факта, что используемые хэши взяты из известных и существующих образов CSAM, Apple заявляет, что система была спроектирована так, чтобы быть точной и избежать проблем с другими изображениями или невиновными пользователями, о которых сообщается в NCMEC.

Дополнительный протокол безопасности связи в сообщениях

Еще одна новая функция – это добавление протоколов безопасности в приложение Сообщения. Это предлагает инструменты, которые будут предупреждать детей и их родителей об отправке или получении сообщений с фотографиями откровенно сексуального характера.

При получении одного из этих сообщений фотография будет размыта, и ребенок также получит предупреждение. Они могут видеть полезные ресурсы, и им говорят, что это нормально, если они не просматривают изображение.

Эта функция будет доступна только для учетных записей, созданных как семьи в iCloud. Родителям или опекунам необходимо будет включить функцию безопасности общения. Они также могут получать уведомления, когда ребенок 12 лет и младше отправляет или получает изображение сексуального характера.

Для детей в возрасте от 13 до 17 лет родители не уведомляются. Но ребенка предупредят и спросят, хотят ли они просмотреть или поделиться изображением откровенно сексуального характера.

Сообщения используют машинное обучение на устройстве, чтобы определить, является ли вложение или изображение сексуальным. Apple не получит доступа к сообщениям или изображениям.

Эта функция будет работать как для обычных SMS, так и для сообщений iMessage и не связана с функцией сканирования CSAM, о которой мы говорили выше.

Расширенное руководство по безопасности в Siri и Поиске

Наконец, Apple расширит руководство по функциям Siri и поиска, чтобы помочь детям и родителям оставаться в безопасности в Интернете и получать помощь в небезопасных ситуациях. Apple указала на пример, когда пользователям, которые спрашивают Siri, как они могут сообщить о CSAM или эксплуатации детей, будут предоставлены ресурсы о том, как подать отчет в органы власти.

Обновления будут приходить в Siri и Search, когда кто-либо выполняет поисковые запросы, связанные с CSAM. В ходе вмешательства пользователям будет объяснено, что интерес к теме вреден и проблематичен. Они также покажут ресурсы и партнеров, которые помогут получить помощь в решении проблемы.

Больше изменений в новейшем программном обеспечении Apple

Три новые функции Apple, разработанные совместно с экспертами по безопасности, призваны обеспечить безопасность детей в Интернете. Несмотря на то, что эти функции могут вызывать беспокойство в некоторых кругах, ориентированных на конфиденциальность, Apple открыто рассказывала об этой технологии и о том, как она уравновесит проблемы конфиденциальности с защитой детей.