Языковое неравенство в больших моделях ИИ: обучение английскому языку стоит дешевле всего, обучение китайскому языку стоит в два раза дороже, чем английскому

Недавно пользователь X (ранее Twitter) @Dylan Patel показал исследование Оксфордского университета: изучая язык GPT-4 и большинство других распространенных LLM, исследование показало, что стоимость вывода LLM (Large Language Model) сильно отличается. большой.

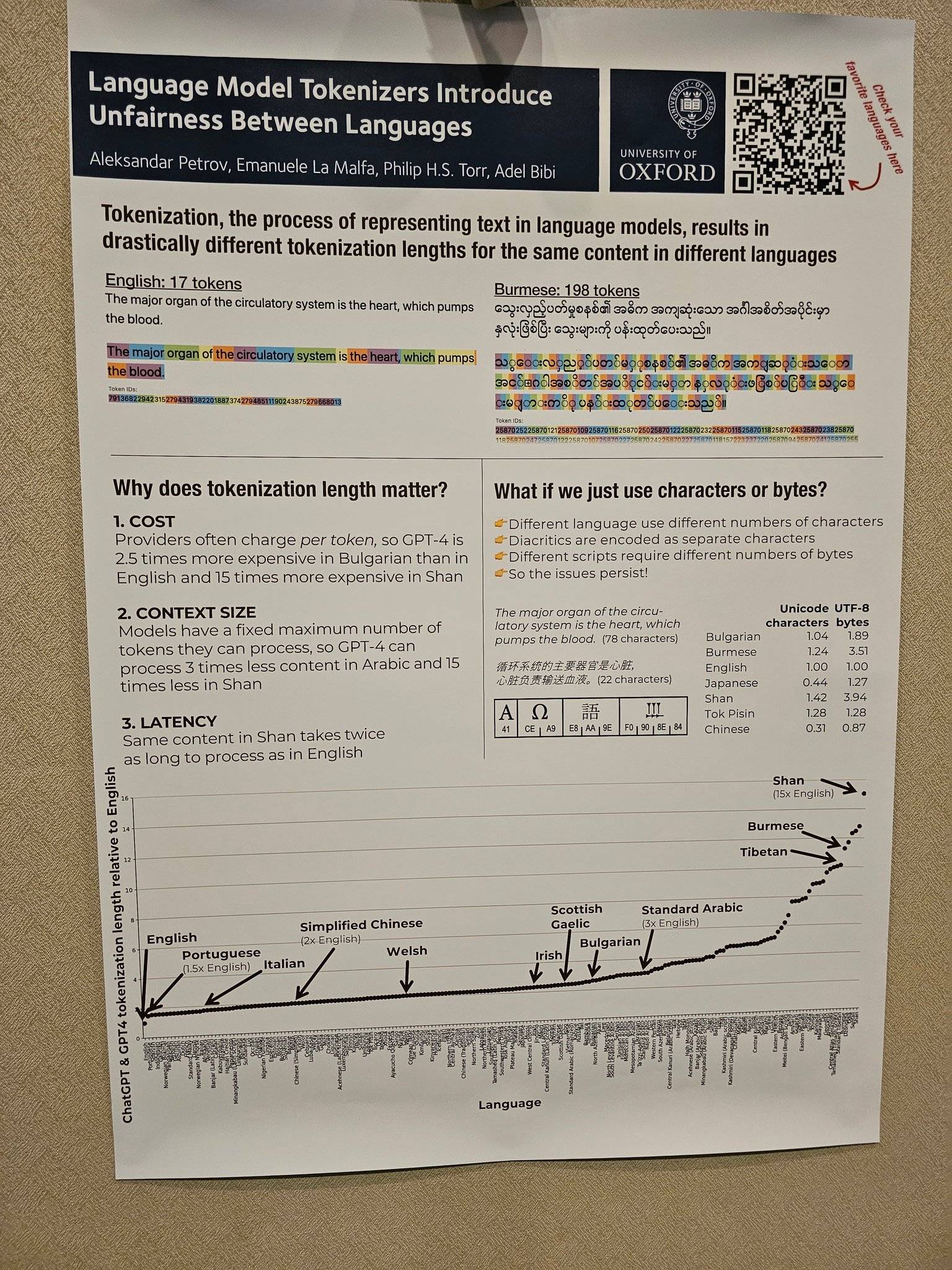

Среди них ввод и вывод на английском языке намного дешевле, чем на других языках.Стоимость упрощенного китайского примерно в 2 раза выше, чем на английском, стоимость испанского языка в 1,5 раза выше, чем на английском, а стоимость бирманского языка шань в 15 раз выше, чем на английском языке. .

Этот принцип восходит к статье, опубликованной Оксфордским университетом на arXiv в мае этого года.

Лексический — это процесс преобразования текста на естественном языке в последовательность токенов, который является первым шагом в обработке текста языковой модели. При расчете стоимости вычислительной мощности LLM чем больше токенов, тем выше стоимость вычислительной мощности.

Несомненно, в условиях тенденции коммерциализации генеративного ИИ стоимость вычислительной мощности также будет переложена на пользователей.Многие современные услуги ИИ оплачиваются в соответствии с количеством слов, которые необходимо обработать.

В статье показано, что, проанализировав 17 методов лемматизации, исследователи обнаружили, что длина одного и того же текста преобразуется в последовательности лемм в разных языках, причем длина абсолютно справедлива.

Например, согласно токенизатору OpenAI GPT3, если вы токенизируете «свою любовь», на английском языке потребуется только два токена, а на упрощенном китайском — восемь токенов. Несмотря на то, что в тексте на упрощенном китайском языке всего 4 символа, а в английском — 14 символов.

Из изображений, предоставленных пользователем X @Dylan Patel, также можно интуитивно увидеть, что LLM требуется 17 токенов (токенов) для обработки предложения на английском языке и 198 токенов (токенов) для LLM для обработки предложения на бирманском языке с То же значение. Это означает, что обработка бирманского языка будет в 11 раз дороже, чем английская.

Есть много похожих ситуаций. На веб-сайте Александра Петрова есть много связанных значков и данных. Заинтересованные друзья могут нажать «https://aleksandarpetrov.github.io/tokenization-fairness/», чтобы просмотреть различия между языками.

На официальном сайте OpenAI также есть аналогичная страница, объясняющая, как API лемматизирует фрагмент текста и отображает общее количество токенов в тексте. На официальном сайте также упоминается, что лемма обычно соответствует примерно 4 символам в английском тексте, а 100 лемм составляют около 75 слов.

Благодаря небольшой длине английских лексических последовательностей английский язык является самым большим победителем в экономической эффективности генеративного предварительного обучения искусственного интеллекта, оставляя других пользователей языка далеко позади, косвенно создавая несправедливую ситуацию.

Среди прочего, эта разница в длине последовательности токенов может привести к несправедливой задержке обработки (некоторым языкам требуется больше времени для обработки одного и того же контента) и несправедливому моделированию зависимостей длинных последовательностей (некоторые языки могут обрабатывать только более короткий текст).

Проще говоря, пользователям определенных языков приходится платить больше, страдать от больших задержек и получать более низкую производительность, тем самым ограничивая их справедливый доступ к возможностям языковых технологий, что косвенно приводит к тому, что англоговорящие пользователи и ИИ разделяют формы между остальные языки мира.

Только по стоимости вывода стоимость упрощенного китайского языка в два раза выше, чем английского. С углубленным развитием области ИИ упрощенный китайский язык, который всегда находится «в одном шаге», явно не дружит. В условиях баланса наложенных друг на друга факторов, таких как стоимость, неанглоязычные страны также пытаются разработать свои собственные модели родного языка.

Взяв в качестве примера Китай, как одного из первых отечественных гигантов, изучающих ИИ, 20 марта 2023 года Baidu официально запустила генеративный ИИ Wenxin Yiyan.

Впоследствии партии превосходных крупномасштабных моделей, таких как крупномасштабная модель Tongyi Qianwen от Alibaba и крупномасштабная модель Pangu от Huawei, появлялись одна за другой.

Среди них большая модель NLP в большой модели Huawei Pangu — первая в отрасли большая китайская модель со 100 миллиардами параметров, которая имеет 110 миллиардов плотных параметров и обучается на 40 ТБ массивных данных.

Как однажды предупредила заместитель Генерального секретаря ООН Амина Мохамед на Генеральной Ассамблее ООН, если международное сообщество не будет действовать решительно, цифровой разрыв станет «новым лицом неравенства».

Точно так же с быстрым развитием генеративного ИИ разрыв в ИИ, вероятно, станет новым витком «новых лиц неравенства», заслуживающих внимания.

К счастью, отечественные технологические гиганты, которые обычно вызывают отвращение, уже приняли меры.

#Добро пожаловать в официальный публичный аккаунт Айфанер в WeChat: Айфанер (идентификатор WeChat: ifanr), в ближайшее время вам будет представлен более интересный контент.

Ай Фанер | Оригинальная ссылка · Просмотреть комментарии · Sina Weibo