OpenAI меняет мир за 26 минут! Бесплатная версия GPT-4 уже здесь, видеоголосовое взаимодействие переносится в научно-фантастический фильм.

Сегодня рано утром 26-минутная пресс-конференция снова сильно изменит индустрию искусственного интеллекта и нашу будущую жизнь, а также сделает несчастными бесчисленные стартапы в области искусственного интеллекта.

На самом деле это не заголовок, потому что это пресс-конференция OpenAI.

Только что OpenAI официально выпустила GPT-4o, где «o» означает «omni» (что означает «всеобъемлющий и всемогущий»). Эта модель имеет возможности работы с текстом, изображениями, видео и голосом. Это даже GPT-5 An. незаконченная версия.

Более того, эта модель уровня GPT-4 будет доступна всем пользователям бесплатно и будет внедрена в ChatGPT Plus в ближайшие недели.

Давайте сначала подведем итоги этой конференции, чтобы получить более подробный функциональный анализ.

Ключевые моменты пресс-конференции

- Новая модель GPT-4o: откройте любой ввод текста, звука и изображения и можете напрямую генерировать друг друга без промежуточного преобразования.

- GPT-4o значительно снижает задержку голоса и может реагировать на аудиовход за 232 миллисекунды, в среднем 320 миллисекунд, что аналогично времени реакции человека при разговоре.

- GPT-4 бесплатен и открыт для всех пользователей.

- GPT-4o API, в 2 раза быстрее GPT4-турбо и на 50% дешевле

- Потрясающая демонстрация голосового помощника в реальном времени: разговор больше похож на человеческий, можно переводить в реальном времени, распознавать выражения, распознавать экран через камеру, писать код и анализировать диаграммы

- Новый пользовательский интерфейс ChatGPT, более лаконичный

- Новое настольное приложение ChatGPT для macOS, версия для Windows появится позднее в этом году.

Эти особенности были описаны Альтманом как «ощущение волшебства» еще на этапе разминки. Поскольку модели ИИ по всему миру «догоняют GPT-4», OpenAI необходимо извлечь из своего арсенала кое-что реальное.

Бесплатный и доступный GPT-4o уже здесь, но это не самое главное его преимущество.

Фактически, за день до пресс-конференции мы обнаружили, что OpenAI незаметно изменила описание GPT-4 с «самой продвинутой модели» на «продвинутую».

Это приветствует появление GPT-4o. Сила GPT-4o заключается в том, что он может принимать любую комбинацию текста, аудио и изображений в качестве входных данных и напрямую генерировать вышеуказанный медиавыход.

Это означает, что взаимодействие человека и компьютера будет ближе к естественному общению между людьми.

GPT-4o может реагировать на аудиовход за 232 миллисекунды, в среднем 320 миллисекунд, что близко ко времени реакции человеческого разговора. Ранее при использовании голосового режима для связи с ChatGPT средняя задержка составляла 2,8 секунды (GPT-3,5) и 5,4 секунды (GPT-4).

Он соответствует производительности GPT-4 Turbo на английском языке и тексте кода, со значительными улучшениями для текста на неанглоязычном языке, но при этом работает быстрее и на 50 % дешевле в API.

По сравнению с существующими моделями GPT-4o особенно хорошо справляется с визуальным и звуковым восприятием.

- Вы можете прервать разговор в любой момент

- Может генерировать различные тона в зависимости от сцены, с человеческими настроениями и эмоциями.

- Совершите видеозвонок напрямую с помощью ИИ и позвольте ему ответить на различные вопросы онлайн.

Судя по параметрам тестирования, основные возможности GPT-4o в основном находятся на том же уровне, что и GPT-4 Turbo, самый сильный OpenAI на данный момент.

[картина]

[картина]

[картина]

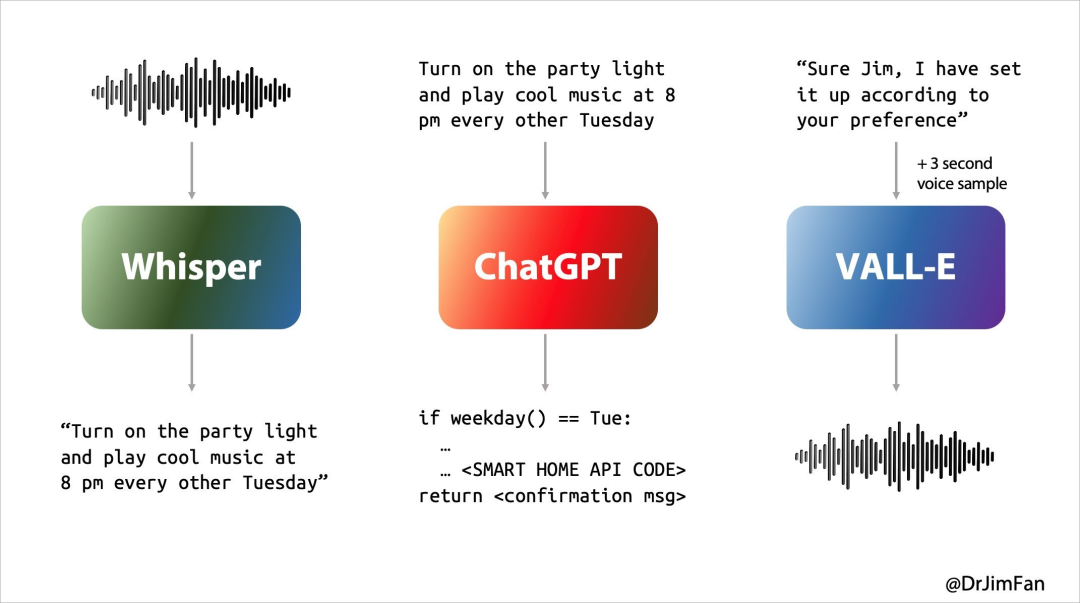

В прошлом наш опыт работы с Siri или другими голосовыми помощниками не был идеальным. По сути, разговор с голосовым помощником проходил в три этапа:

- Распознавание речи или «ASR»: аудио -> текст, аналогично Whisper;

- LLM планирует, что сказать дальше: Текст 1 -> Текст 2;

- Синтез речи или «TTS»: Текст 2 -> Аудио, например ElevenLabs или VALL-E.

Однако наши ежедневные естественные разговоры в основном такие:

- Подумайте о том, что сказать дальше, слушая и говоря;

- Вставьте «да, гм, гм» в подходящий момент;

- Ожидайте, когда собеседник закончит говорить и немедленно возьмет на себя ответственность;

- Решите прервать разговор собеседника естественно и не вызывая обиды;

- Подумайте о том, что сказать дальше, слушая и говоря;

- Вставьте «да, гм, гм» в подходящий момент;

- Обращайтесь и прерывайте изящно.

Предыдущие помощники по языку искусственного интеллекта не могли хорошо справиться с этими проблемами, и на каждом из трех этапов разговора возникала большая задержка, что приводило к ухудшению качества обслуживания. В то же время при этом теряется много информации, например, невозможность непосредственно наблюдать за интонацией, несколькими говорящими или фоновым шумом, а также неспособность воспроизводить смех, пение или выражать эмоции.

Когда звук может напрямую генерировать аудио, изображения, текст и видео, весь опыт будет стремительным.

GPT-4o — это совершенно новая модель, обученная OpenAI для этой цели. Прямое преобразование текста, видео и аудио требует, чтобы все входные и выходные данные обрабатывались одной и той же нейронной сетью.

Что еще более удивительно, так это то, что бесплатные пользователи ChatGPT могут использовать GPT-4o для использования следующих функций:

- Испытайте интеллект уровня GPT-4

- Получайте ответы от моделей и сетей

- Анализируйте данные и создавайте диаграммы

- Давайте поговорим о фотографиях, которые вы сделали

- Загрузите файл для помощи в написании реферата, написании или анализе.

- Использование GPT и магазина GPT

- Создавайте более полезный опыт с помощью Memory

И когда вы посмотрите следующие демонстрации GPT-4o, ваши чувства могут оказаться более сложными.

Версия ChatGPT "Джарвис", есть у всех

ChatGPT умеет не только говорить, слушать, но и смотреть. В этом нет ничего нового, но «новая версия» ChatGPT меня все равно удивила.

спальный партнер

Возьмите в качестве примера конкретную сцену из жизни и позвольте ChatGPT рассказать сказку на ночь о роботах и любви. Он может рассказать эмоциональную и драматическую сказку на ночь, не задумываясь.

Он даже может рассказывать истории в форме пения, которое может служить для пользователей компаньоном во сне.

Мастер вопросов

Или пусть на пресс-конференции он покажет, как решить линейное уравнение 3X+1=4. Он поможет вам шаг за шагом и даст правильный ответ.

Конечно, вышеописанное все еще является «детской игрой», а настоящим испытанием являются трудности с кодированием на месте. Однако ее можно легко решить тремя ударами, пятью ударами и двумя ударами.

Благодаря «видению» ChatGPT он может просматривать все на экране компьютера, например взаимодействовать с базой кода и просматривать диаграммы, созданные кодом. Что-то не так? Тогда разве наша конфиденциальность не будет ясно видна в будущем?

перевод в реальном времени

Зрители на месте происшествия также задали ChatGPT каверзные вопросы.

Переводя с английского на итальянский и с итальянского на английский, сколько бы вы ни пользовались этим голосовым помощником с искусственным интеллектом, он сделает это с легкостью. Кажется, нет необходимости тратить много денег на покупку переводчика. в будущем, возможно, ChatGPT может быть лучше, чем ваш переводчик в реальном времени. Переводчик довольно надежный.

В настоящее время этот контент не может отображаться за пределами документов Feishu.

▲ Перевод в реальном времени (официальный сайт)

Восприятие эмоций языка — это только первый шаг. ChatGPT также может интерпретировать эмоции на лице человека.

На пресс-конференции ChatGPT прямо принял лицо, снятое камерой, за стол. Когда все подумали, что оно вот-вот перевернется, оказалось, что фронтальная камера, включенная первой, была направлена на стол. .

Однако в итоге он точно описал эмоции на лице на селфи и точно определил «яркую» улыбку на лице.

Интересно, что в конце пресс-конференции представитель не забыл о «сильной поддержке» Кью со стороны Nvidia и ее основателя Лао Хуана. Он действительно понимает человеческую природу.

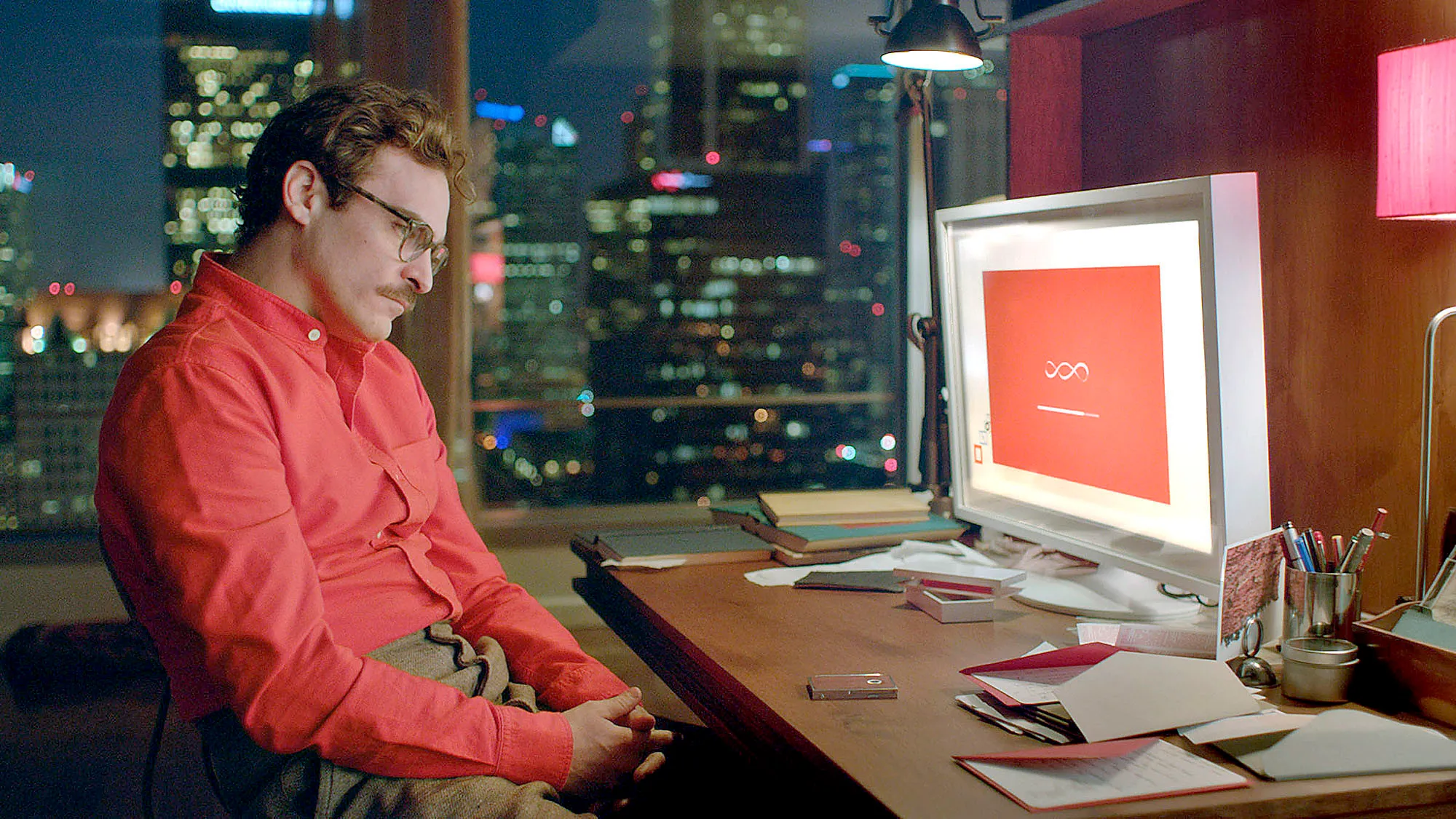

Идея разговорного языкового интерфейса оказалась невероятно пророческой.

В предыдущих интервью Альтман заявлял, что надеется в конечном итоге разработать ИИ-помощника, подобного тому, что был в ИИ-фильме «Она», а голосовой помощник, выпущенный сегодня OpenAI, действительно воплощается в жизнь.

Брэд Лайткэп, главный операционный директор OpenAI, недавно предсказал, что в будущем мы будем общаться с чат-ботами ИИ так же, как с людьми, рассматривая их как часть команды.

Теперь кажется, что это не только проложило путь к сегодняшней конференции, но и стало ярким примечанием к нашей жизни на ближайшие десять лет.

Apple боролась с голосовыми помощниками на базе искусственного интеллекта уже тринадцать лет и не смогла выбраться из лабиринта, но OpenAI в одночасье нашла выход. Можно предвидеть, что в ближайшем будущем «Джарвис» Железного Человека перестанет быть фантастикой.

"Она идет

Хотя Сэм Альтман не появился на конференции, после конференции он опубликовал блог и разместил сообщение на X:her.

Очевидно, это намек на одноименный классический научно-фантастический фильм «Она». Это был первый образ, который пришел мне на ум, когда я смотрел презентацию этой конференции.

Саманта в фильме «Она» не просто продукт, она даже лучше людей понимает и больше похожа на самих людей. При общении с ней действительно можно постепенно забыть, что она ИИ.

Это означает, что модель взаимодействия человека с компьютером может привести к поистине революционному обновлению после графического интерфейса, как сказал Сэм Альтман в своем блоге:

Новые голосовые (и видео) режимы — лучший компьютерный интерфейс, который я когда-либо использовал. Это похоже на ИИ из фильма, и я все еще немного удивлен, что это реально. Достижение времени отклика и выразительности человеческого уровня оказывается большим изменением.

Предыдущий ChatGPT позволил нам увидеть начало естественного пользовательского интерфейса: простота превыше всего: сложность — враг естественного пользовательского интерфейса. Каждое взаимодействие должно быть понятным и не требовать никаких инструкций.

Но выпущенный сегодня GPT-4o совершенно другой. Он почти не имеет задержки ответа, умен, интересен и практичен. Наше взаимодействие с компьютерами никогда не было таким естественным и плавным.

Здесь по-прежнему скрыты огромные возможности. Когда поддерживаются более персонализированные функции и сотрудничество с различными терминальными устройствами, это означает, что мы можем использовать мобильные телефоны, компьютеры, умные очки и другие вычислительные терминалы, чтобы делать многие вещи, которые раньше были невозможны.

Аппаратное обеспечение искусственного интеллекта больше не будет пытаться накапливаться. Что еще более интересно сейчас, так это то, что, если Apple официально объявит о своем сотрудничестве с OpenAI на WWDC в следующем месяце, опыт работы с iPhone может улучшиться больше, чем на любой конференции за последние годы.

Старший специалист по кодированию NVIDIA Джим Фан считает, что сотрудничество между iOS 18, известной как крупнейшее обновление в истории, и OpenAI может иметь три уровня:

- Отказавшись от Siri, OpenAI усовершенствовала небольшую версию GPT-4o для iOS, которая работает исключительно на устройстве, с возможностью оплаты обновления для использования облачных сервисов.

- Встроенная функциональность передает потоки с камеры или экрана в модель. Поддержка нейронных аудио- и видеокодеков на уровне чипа.

- Интеграция с API-интерфейсом iOS на уровне системы и API-интерфейсом умного дома. Никто не использует ярлыки Siri, но пришло время возрождения. Это может стать продуктом-агентом искусственного интеллекта, сразу же привлекающим миллиард пользователей. Это что-то вроде полноразмерного маховика данных для смартфонов в стиле Теслы.

Кстати, мне жаль Google, который завтра проведет пресс-конференцию.

Автор: Ли Чаофань и Мо Чунюй

# Добро пожаловать на официальную общедоступную учетную запись WeChat aifaner: aifaner (идентификатор WeChat: ifanr). Более интересный контент будет предоставлен вам как можно скорее.

Ай Фанер | Исходная ссылка · Посмотреть комментарии · Sina Weibo