Команда Стэнфорда заимствовала большую модель из Университета Цинхуа. Автор извинился поздно вечером. Большую модель Китая больше нельзя игнорировать.

Некоторое время назад Институт искусственного интеллекта Стэнфордского университета (Stanford HAI) опубликовал отчет, в котором говорится, что США далеко впереди в области больших моделей. В отчете отмечается, что в 2023 году 61 известная модель искусственного интеллекта была создана учреждениями США, что намного превышает 21 модель в ЕС и 15 в Китае.

Винод Хосла, один из первых инвесторов OpenAI, также опубликовал в прошлом году статью о X, в которой говорилось, что американские модели с открытым исходным кодом будут скопированы Китаем.

Однако большая отечественная модель, которая всегда считалась «догоняющей Соединенные Штаты», теперь стала объектом плагиата, а команда плагиата по искусственному интеллекту принадлежит Стэнфордскому университету, опубликовавшему вышеупомянутый отчет.

Модель с открытым исходным кодом Llama3-V, возглавляемая стэнфордской командой искусственного интеллекта, была заподозрена в плагиате отечественной модели с открытым исходным кодом «Маленькая стальная пушка» MiniCPM-Llama3-V 2.5 от Университета Цинхуа и Wall-Facing Intelligence, что мгновенно вызвало переполох. в кругу ИИ.

Под настоящим молотком команде Стэнфорда также пришлось срочно извиняться.

Как в шутку ответил Ли Дахай, генеральный директор Wall-Facing Intelligence, это «метод, признанный международной командой». Как бы далеко мы ни находились от топовых больших моделей, отечественные большие модели достигли той стадии, когда их уже нельзя игнорировать.

Кратко разберем хронологию:

- Стэнфордская команда искусственного интеллекта выпускает Llama3-V, известную как мультимодальная большая модель SOTA

- Пользователи сети усомнились в том, что модель копирует отечественный настенный смарт MiniCPM-Llama3-V2.5.

- Появились доказательства, автор Llama3-V инсценировал «удаление базы данных и побег».

- Официальный плагиат Face Wall Intelligence, сделал заявление поздно ночью

- Автор Llama3-V официально приносит извинения, мнения пользователей сети разнятся

Используя плагиат настенной интеллектуальной «Маленькой стальной пушки», команда ИИ из Стэнфорда инсценировала «Удали базу данных и беги прочь».

Недавно команда ИИ из Стэнфорда объявила, что обучение мультимодальной большой модели SOTA, превосходящей GPT-4V, стоит всего 500 долларов.

Но вскоре пользователь X @yangzhizheng1 отметил, что структура модели и код, используемые в этом проекте, удивительно похожи на MiniCPM-Llama3-V2.5, выпущенную недавно Wallface Intelligence.

С этой целью пользователь X @yangzhizheng1 также опубликовал соответствующие показания для допроса.

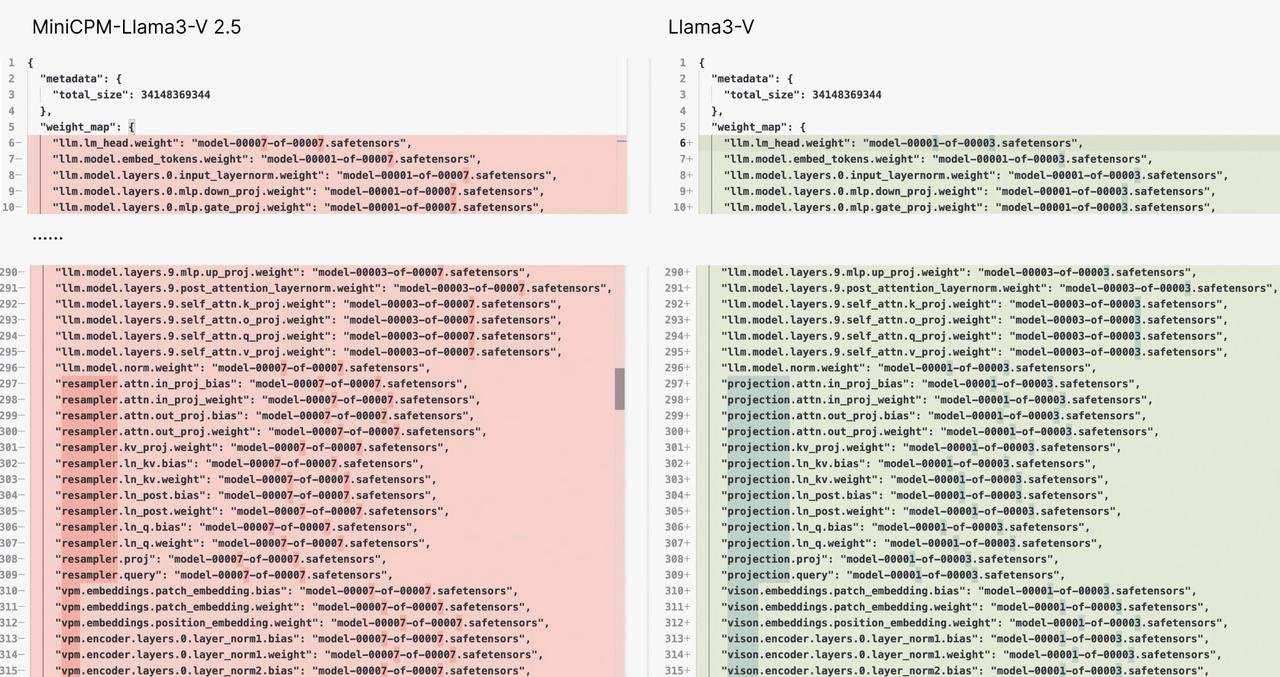

Доказательство первое:

Структура модели и код Llama3-V и MiniCPM-Llama3-V 2.5 практически на уровне копипаста схожи. Разница, видимо, в том, что у них поменяли жилет – изменились имена переменных.

Это похоже на одно и то же платье, но с пуговицами разного цвета. Думаете, это совпадение?

Доказательство второе:

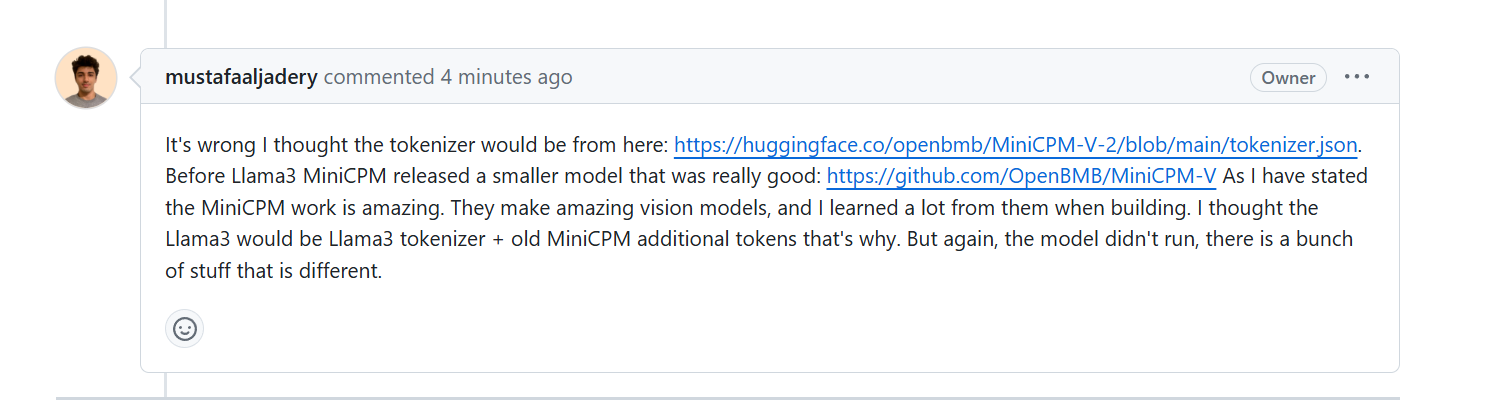

Когда авторов Llama3-V спросили, почему они могут использовать токенизатор MinicPM-Llama3-V2.5, который еще не был выпущен заранее, они объяснили, что используют проект MinicPM-V-2 предыдущего поколения Wall-Facing. Интеллект.

Однако некоторые СМИ запросили подтверждение у представителей Wallface Intelligence. В HuggingFace сегментаторы слов MiniCPM-V2 и MiniCPM-Llama3-V 2.5 представляют собой два файла соответственно, причем размеры файлов совершенно разные.

Более того, токенизатор MiniCPM-Llama3-V 2.5 состоит из токенизатора Llama3 и специального токена модели серии MiniCPM-V.

Учитывая, что MiniCPM-V2 был выпущен раньше, чем Llama3, теоретически невозможно включить в него технологию токенизатора Llama3, которая еще не раскрыта.

Доказательство третье:

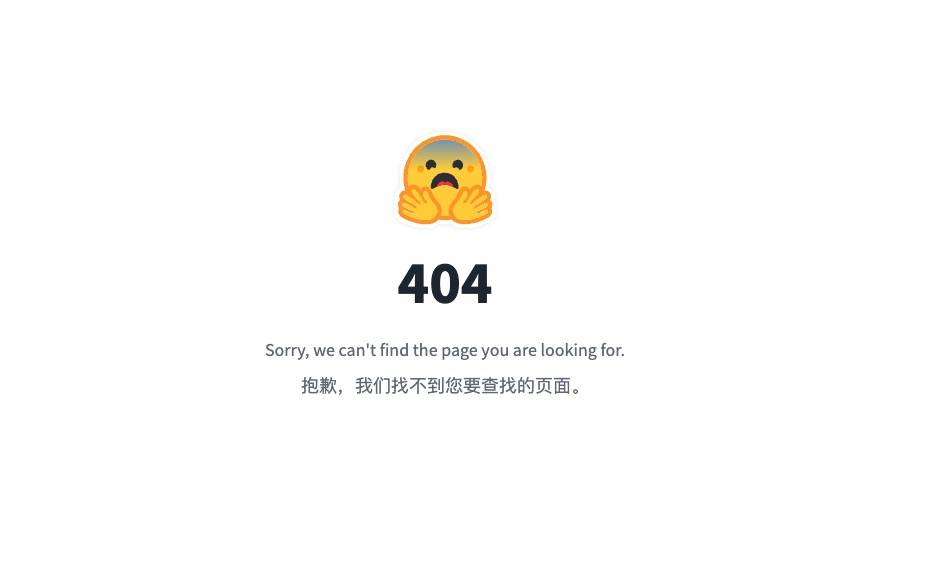

Что еще более возмутительно, так это то, что когда автор проекта llama3-V столкнулся с сомнениями пользователей и увидел, что что-то идет не так, он просто устроил хорошее шоу «удали библиотеку и убегай».

Удалена даже страница проекта на GitHub, которую можно назвать обманчивой версией 2.0.

Адрес Hugging Face выглядит следующим образом. В настоящее время, когда мы открываем страницу, мы видим только «404».

https://huggingface.co/mustafaaljadery/llama3v/commit/3bee89259ecac051d5c3e58ab619e3fafef20ea6

Это еще не конец, появляется больше доказательств:

Пользователь X @yangzhizheng1 сказал, что если к контрольной точке MiniCPM-Llama3-V 2.5 добавить гауссов шум (параметризованный одним скаляром), результирующая модель будет создана по той же схеме, что и Llama3-V.

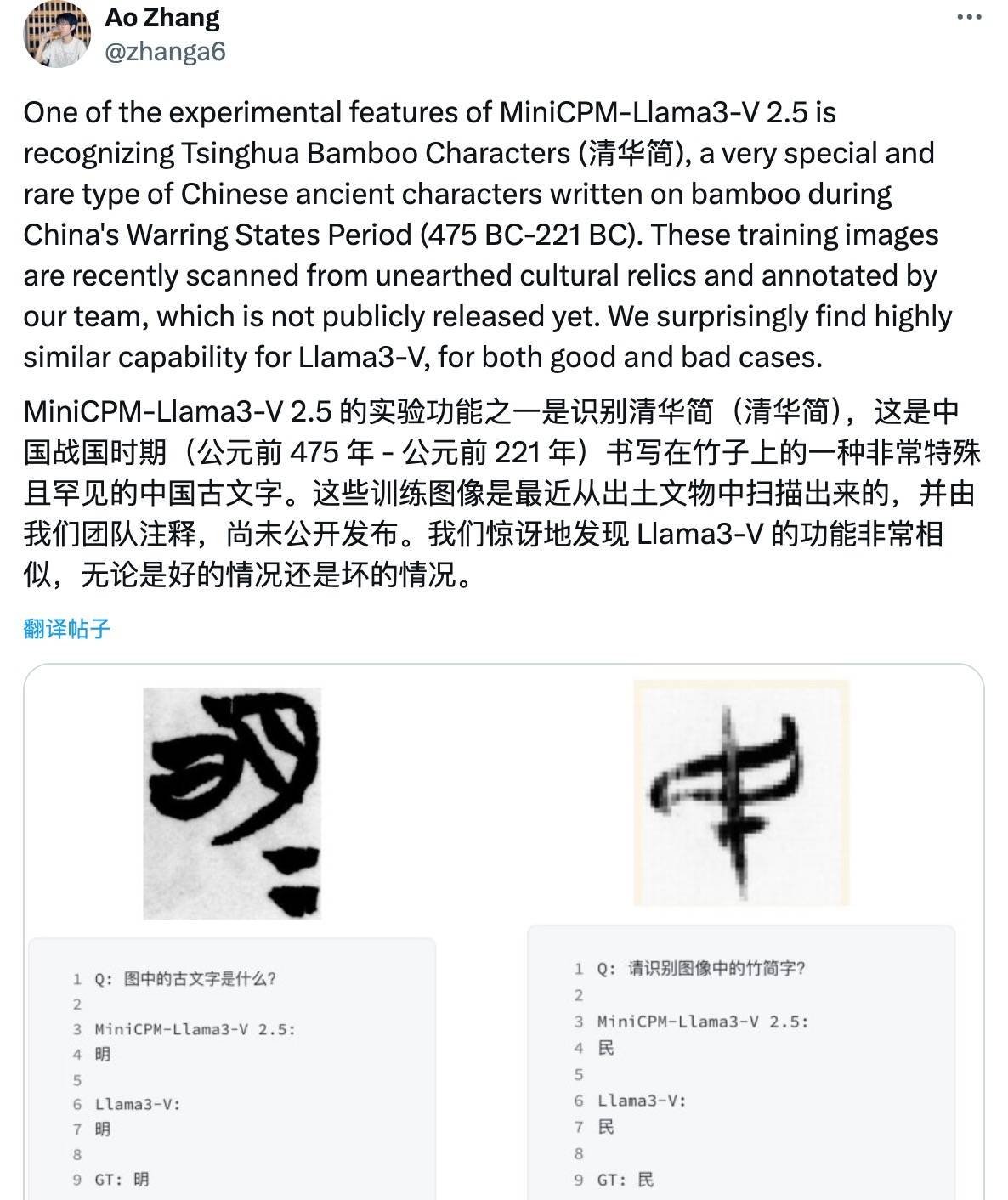

Мало того, эта модель также может распознавать глубокие древние сочинения периода Воюющих царств, такие как «Ошибки Цинхуа», и ошибки точно такие же. По официальным словам Разведки, обращенной к стене:

Они не только правы, но и не правы.

Вы должны знать, что эти древние письменные данные были получены путем сканирования и ручного аннотирования бамбуковых пластинок Цинхуа, собранных Университетом Цинхуа в течение нескольких месяцев. Они никогда не публиковались.

Так как же Стэнфордской команде искусственного интеллекта удалось получить это из воздуха?

Можно сказать, что ночное заявление Wallface Intelligence от 2 июня можно расценить как полный плагиат исследовательской группы Стэнфордского университета в области искусственного интеллекта.

До сегодняшнего утра Сиддхарт Шарма и Акш Гарг, два автора из Стэнфордской команды Llama3-V, официально извинились перед командой MiniCPM за это академическое нарушение на социальной платформе X, заявив, что все модели Llama3-V будут удалены.

Занимаются ли плагиатом лучшие ученики известных школ? Китайские большие модели с открытым исходным кодом догоняют

Важная причина, по которой этот вопрос вызвал ажиотаж в Интернете, заключается в том, что прошлое плагиатора настолько гламурно.

Публичная информация показывает, что Сиддхарт Шарма и Акш Гарг являются студентами факультета компьютерных наук Стэнфордского университета и опубликовали множество статей в области машинного обучения. Среди них Сиддхарт Шарма какое-то время стажировался в Amazon и в настоящее время в основном занимается работой, связанной с искусственным интеллектом и данными.

Резюме стажировки Акша Гарга богато и охватывает такие известные организации, как SpaceX, Стэнфордский университет и Калифорнийский технологический институт.

Что касается Мустафы Альхадери, которого два вышеупомянутых автора называют «носителем кода», он является выпускником Университета Южной Калифорнии. После того, как общественное мнение подошло к концу, аккаунту X был присвоен статус частного.

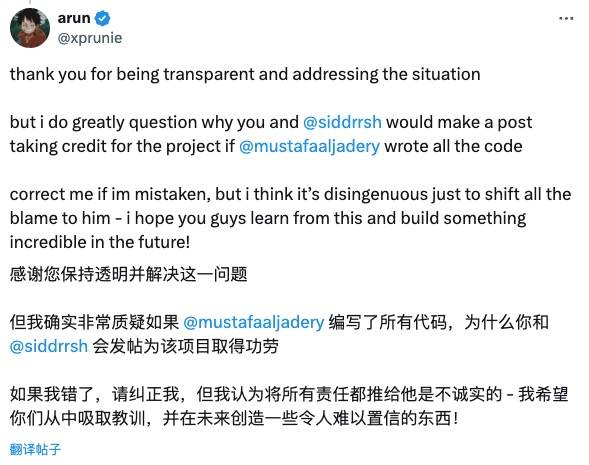

Внимательные пользователи сети не приняли заявление с извинениями от команды Stanford Llama3-V.

Например,

Кристофер Дэвид Мэннинг, директор Стэнфордской лаборатории искусственного интеллекта, также выступил с осуждением этого плагиата и похвалил MiniCPM, превосходную китайскую модель с открытым исходным кодом.

Однако есть пользователи сети, которые придерживаются позиции «прощайте других, когда вам нужно проявить к ним милосердие» и неторопливо подбадривают их:

Открытость и честность — очень важные ценности в мире технологий, и я с нетерпением жду ваших новых работ.

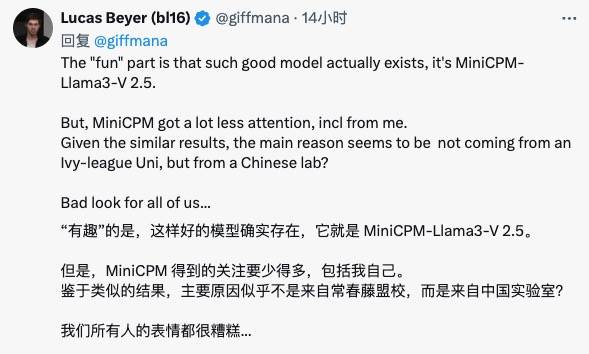

Исследователь Google DeepMind Лукас Бейер заявил, что в крупных моделях Китая с открытым исходным кодом есть хорошие модели, такие как MiniCPM, но международное сообщество не уделило им достаточно внимания…

Вчера на этот вопрос также ответила команда Wall-Facing Intelligence.

Ли Дахай, генеральный директор Face-Wall Intelligence, сказал: «Технологические инновации — это непросто. Каждая работа — это результат ежедневных усилий команды. Это также искренний вклад в технологический прогресс и инновационное развитие во всем мире. ограниченная вычислительная мощность.

Мы надеемся, что хорошую работу команды заметит и признает большее количество людей, но не таким образом. "

Лю Чжиюань, главный научный сотрудник Wall-Facing Intelligence, также написал на Zhihu, заявив, что этот инцидент доказал международное влияние инновационных достижений Китая с другой точки зрения, подчеркнув важность обмена открытыми исходными кодами и уважения к духу оригинальности.

Надо сказать, что эта драма плагиата в сфере искусственного интеллекта представляет собой хрестоматийное объяснение того, что «инновации — это непросто, их нужно делать и лелеять, академическая честность — это ответственность каждого».

Знаете, если имитировать форму кода, оригинальное изящество не скопируешь.

Фактически, с прошлого года крупные модели Китая были открыты, как грибы после весеннего дождя. Они превратились из бенефициаров в участников и не скупятся на предоставление миру более выдающихся результатов с открытым исходным кодом.

Стартапы в области искусственного интеллекта, такие как Zhipu AI и Kunlun Tiangong, от таких гигантов, как Alibaba и Tencent, до скромных интеллектуальных компаний, также являются активными членами сообщества открытого исходного кода, внося свой вклад в развитие крупномасштабных моделей Китая.

Мы также надеемся, что весенний ветерок открытости и обмена будет дуть сильнее.

Точно так же, как Ли Дахай, генеральный директор Face Wall Intelligence, призывает всех работать вместе, чтобы построить открытую, кооперативную и доверительную среду сообщества. Давай, работай вместе, чтобы сделать мир лучше с появлением AGI!

# Добро пожаловать на официальную общедоступную учетную запись WeChat aifaner: aifaner (идентификатор WeChat: ifanr). Более интересный контент будет предоставлен вам как можно скорее.

Ай Фанер | Исходная ссылка · Посмотреть комментарии · Sina Weibo