Лучшие онлайн-инструменты для парсинга

Парсинг веб-страниц полезен для различных аналитических целей. Это может пригодиться, когда вам нужно проводить онлайн-опросы для вашего бизнеса, чтобы отслеживать тенденции рынка. Однако очистка веб-страниц требует определенных технических знаний, поэтому некоторые люди стараются избегать этого.

Но с помощью некоторых инструментов для парсинга веб-страниц теперь вы можете получить нужные данные, не написав ни единой строчки кода или не выполняя высокотехнологичных процессов.

Давайте посмотрим на некоторые онлайн-парсеры, которые помогут вам собирать данные для ваших аналитических нужд.

1. Scrapingbot

Scrapingbot – один из самых удобных в использовании веб-парсеров. В нем также есть легкая для понимания документация, которая расскажет, как использовать инструмент.

Scrapingbot предлагает интерфейс прикладного программирования (API) и готовые инструменты для очистки любой веб-страницы. Он универсален и отлично работает с источниками бизнес-данных, такими как, в частности, веб-сайты розничной торговли и недвижимости.

Инструмент для очистки данных не требует кодирования, поскольку он выполняет большую часть работы за вас и возвращает формат JSON любой очищенной веб-страницы в виде необработанного HTML. Ценообразование Scrapingbot также гибкое. Вы можете начать с бесплатного плана, прежде чем перейти на платную подписку.

Хотя его бесплатный план предлагает ограниченные функции и ресурсы, все же стоит попробовать, если у вас небольшой бюджет или вы не можете позволить себе платные варианты. Просто имейте в виду, что количество одновременных запросов, которые вы можете сделать за парсинг с помощью других технических средств поддержки, уменьшается по мере снижения цены.

Чтобы очистить веб-сайт с помощью Scrapingbot, все, что вам нужно сделать, это указать URL-адрес целевого веб-сайта. Если вы хотите получить версию кода вашего запроса, Scrapingbot также поддерживает разные языки программирования. Он также имеет интерфейс, который возвращает версию кода вашего запроса в различных языковых форматах.

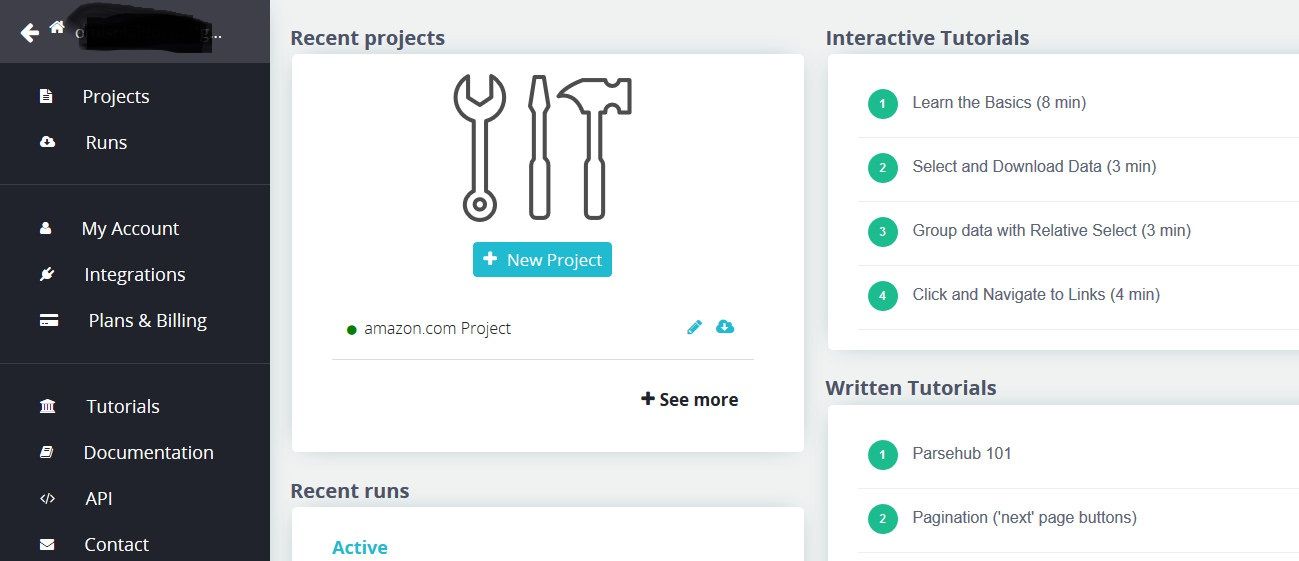

2. Parsehub

В отличие от Scrapingbot, Parsehub представляет собой настольное приложение, но помогает подключиться к любому веб-сайту, с которого вы хотите извлечь данные.

Благодаря элегантному интерфейсу вы можете подключиться к Parsehub REST API или экспортировать извлеченные данные в виде файлов JSON, CSV, Excel или Google Sheets. Вы также можете запланировать экспорт данных, если хотите.

Начать работу с Parsehub довольно просто. Извлечение данных с его помощью практически не требует технических навыков. У инструмента также есть подробные руководства и документы, которые упрощают его использование. Если вы когда-нибудь захотите использовать его REST API, у него также есть подробная документация по API .

Если вы не хотите сохранять выходные данные непосредственно на свой компьютер, динамические облачные функции Parsehub позволяют сохранять выходные данные на своем сервере и получать их в любое время. Инструмент также извлекает данные с веб-сайтов, которые загружаются асинхронно с помощью AJAX и JavaScript.

Хотя Parsehub предлагает бесплатную опцию, у нее есть и другие платные опции, которые позволят вам максимально использовать ее. Бесплатный вариант отлично подходит для начала, но когда вы платите, вы можете быстрее очищать данные с меньшим количеством запросов на извлечение.

3. Dexi.io

Dexi имеет простой интерфейс, который позволяет извлекать данные в реальном времени с любой веб-страницы с помощью встроенной технологии машинного обучения, называемой роботами цифрового захвата.

С помощью Dexi вы можете извлекать как текстовые, так и графические данные. Его облачные решения позволяют экспортировать очищенные данные на такие платформы, как Google Sheets, Amazon S3 и другие.

Помимо извлечения данных, Dexi предлагает инструменты мониторинга в реальном времени, которые информируют вас об изменениях в деятельности конкурентов.

Хотя у Dexi есть бесплатная версия, которую вы можете использовать для выполнения небольших проектов, вы не получите доступа ко всем ее функциям. Его платная версия стоимостью от 105 до 699 долларов в месяц дает вам доступ ко многим премиум-поддержке.

Как и в случае с другими онлайн-парсерами, все, что вам нужно сделать, это предоставить Dexi целевой URL-адрес при создании того, что он называет роботом-извлекающим.

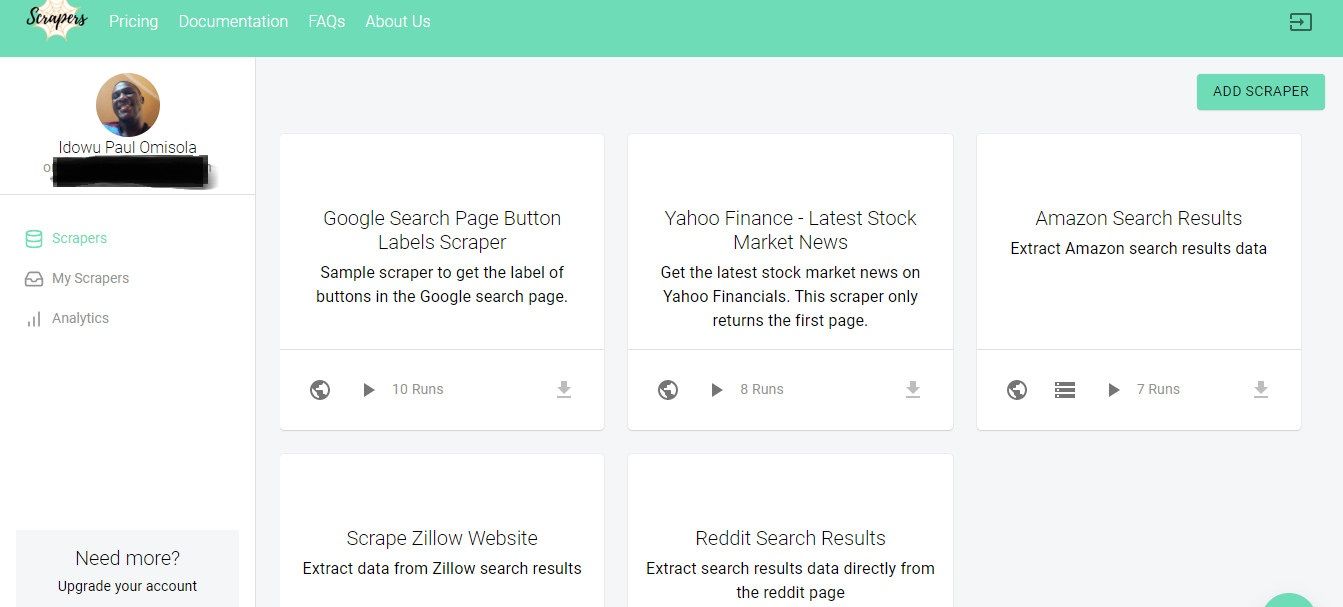

4. Скребки

Скребки – это веб-инструмент для извлечения содержимого веб-страниц. Использовать скреперы просто и не нужно писать код. Документация также короткая и простая для понимания.

Однако инструмент предлагает бесплатный API, который позволяет программистам создавать многоразовые веб-парсеры с открытым исходным кодом. Хотя этот вариант требует от вас заполнения некоторых полей или использования встроенного текстового редактора для завершения предварительно сгенерированного блока кода, его все же довольно легко и просто использовать.

Данные, которые вы извлекаете с помощью парсеров, доступны в виде файлов JSON, HTML или CSV. Хотя бесплатный вариант предлагает ограниченное количество веб-парсеров, вы все равно можете обойти это, создав свой парсер с его API.

Платные опции стоят всего 30 долларов в месяц. Однако, в отличие от бесплатного плана, ни один из его платных вариантов не ограничивает количество веб-сайтов, которые вы можете очистить. Вы даже можете использовать парсеры, созданные другими людьми, если у вас есть членская подписка.

Инструмент отличается быстрым пользовательским интерфейсом и первоклассным интерфейсом. Он также загружает ваши выходные данные асинхронно и делает их загружаемыми на ваш компьютер в выбранном вами формате.

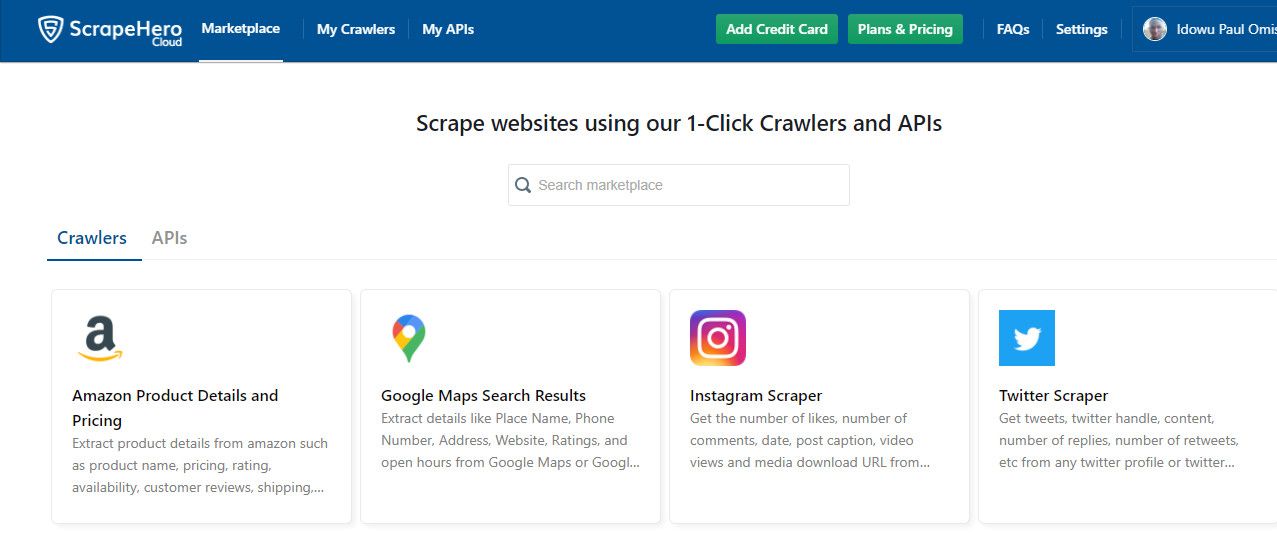

5. ScrapeHero

Если вы хотите получать данные с социальных платформ и онлайн-магазинов, ScrapeHero может стать отличным выбором.

В нем есть специальные инструменты для сбора данных с платформ социальных сетей, таких как Instagram и Twitter, а также из торговых и коммерческих точек, таких как Amazon, обзоры Google и другие.

У инструмента есть специальная торговая площадка, где вы можете выбрать платформу, которую хотите очистить. Как и другие упомянутые нами парсеры, вам не нужны знания программирования для использования ScraperHero.

В отличие от Paserhub, ScraperHero на 100% работает в Интернете, поэтому вам не нужно устанавливать специальные приложения на свой компьютер, чтобы использовать его. ScraperHero очень отзывчив и быстро возвращает элементы данных с помощью нескольких щелчков мыши.

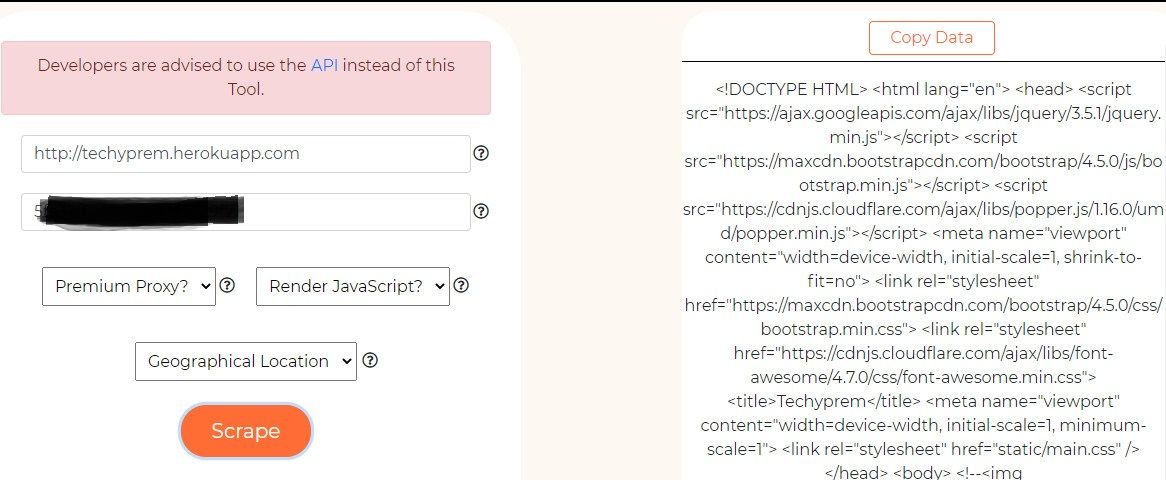

6. Скребковая собака

Scrapingdog – это веб-инструмент для очистки элементов веб-сайта вместе с его содержимым. Его встроенный парсер возвращает данные веб-страницы в виде необработанного HTML.

Инструмент предоставляет API, который дает более структурированный вывод ваших данных. Однако для использования опции API требуются некоторые знания программирования. Но с его встроенным скребком вы можете избежать использования опции API.

Scrapingdog также поддерживает асинхронную загрузку при сканировании и извлечении содержимого веб-сайта. Чтобы использовать парсер, все, что вам нужно сделать, это указать URL-адрес веб-сайта, который вы хотите очистить, чтобы получить его содержимое.

Scrapingdog также предлагает прокси-сервер премиум-класса, который позволяет вам получать доступ к веб-сайтам, которые сложнее очистить без блокировки. Цена Scrapingdog составляет от 20 до 200 долларов в месяц после 30-дневной бесплатной пробной версии.

Сочетайте эти инструменты для парсинга с другими методами

Использование онлайн-парсеров упрощает жизнь, когда вы не хотите писать коды. Если вы используете данные в коммерческих целях, использование этих инструментов может быть разумным способом получить конкурентное преимущество перед другими компаниями, если вы знаете, как их обойти.

Эти онлайн-парсеры могут предоставить вам важную информацию, но объединение их с другими инструментами дает вам больше контроля над типом данных, которые вы хотите очистить.