Почему Apple отказалась от функции сканирования фотографий?

В августе 2021 года Apple объявила о своих планах сканировать iPhone на предмет изображений сексуального насилия над детьми. Этот шаг вызвал аплодисменты со стороны групп по защите детей, но вызвал опасения среди экспертов по конфиденциальности и безопасности, что эта функция может быть использована не по назначению.

Изначально Apple планировала включить в iOS 15 технологию сканирования материалов о сексуальном насилии над детьми (CSAM); вместо этого он на неопределенный срок отложил развертывание функции, чтобы получить отзывы до ее полного выпуска.

Так почему же функция обнаружения CSAM стала предметом жарких споров и что заставило Apple отложить ее развертывание?

Что делает функция сканирования фотографий Apple?

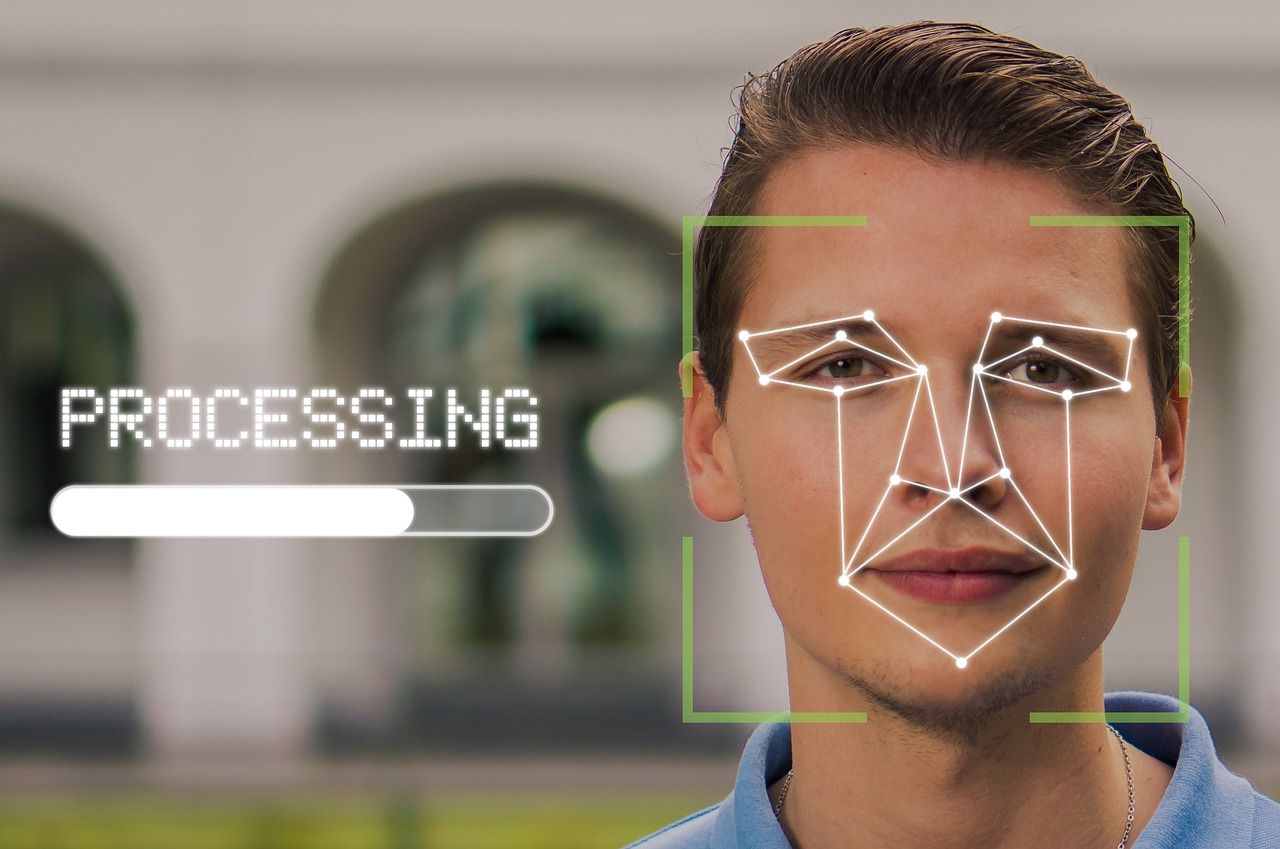

Apple объявила о внедрении функции сканирования фотографий в надежде бороться с сексуальным насилием над детьми. Все фотографии на устройствах пользователей Apple будут сканироваться на предмет педофилии с использованием алгоритма «NueralHash», созданного Apple.

Кроме того, любые устройства Apple, используемые детьми, будут иметь функцию безопасности, которая автоматически размывает изображения взрослых, если они получены ребенком, и пользователь будет дважды предупрежден, если он попытается их открыть.

Помимо минимизации воздействия контента для взрослых, если родители зарегистрируют устройства, принадлежащие их детям, для дополнительной безопасности, родители будут уведомлены в случае, если ребенок получит откровенный контент от кого-либо в сети.

Что касается взрослых, использующих Siri для поиска всего, что сексуализирует детей, Siri не будет выполнять этот поиск и вместо этого предлагать другие альтернативы.

Данные с любого устройства, содержащего 10 или более фотографий, которые алгоритмы сочтут подозрительными, будут расшифрованы и подвергнуты проверке человеком.

Если эти или какие-либо другие фотографии на устройстве будут соответствовать чему-либо из базы данных, предоставленной Национальным центром пропавших без вести и эксплуатируемых детей , об этом будет сообщено властям, и учетная запись пользователя будет приостановлена.

Основные проблемы, связанные с функцией сканирования фотографий

Функция обнаружения CSAM должна была появиться с запуском iOS 15 в сентябре 2021 года, но перед лицом повсеместного протеста Apple решила потратить больше времени на сбор отзывов и внесение улучшений в эту функцию. Вот полное заявление Apple о задержке:

«В прошлом месяце мы объявили о планах по созданию функций, призванных помочь защитить детей от хищников, использующих средства общения для вербовки и эксплуатации, а также ограничить распространение материалов о сексуальном насилии над детьми.

Основываясь на отзывах клиентов, правозащитных групп, исследователей и других лиц, мы решили в ближайшие месяцы выделить дополнительное время, чтобы собрать информацию и внести улучшения, прежде чем выпускать эти критически важные функции безопасности детей ».

Почти половина проблем, связанных с функцией сканирования фотографий Apple, связана с конфиденциальностью; остальные аргументы включают вероятную неточность алгоритмов и возможное неправильное использование системы или ее лазеек.

Разобьем его на четыре части.

Возможное злоупотребление

Знание о том, что любой материал, соответствующий детской порнографии или известным изображениям сексуального насилия над детьми, внесет устройство в список «подозрительных», может привести киберпреступников в движение.

Они могут намеренно бомбардировать человека неприемлемым контентом через iMessage, WhatsApp или любые другие средства и заблокировать его учетную запись.

Apple заверила, что пользователи могут подать апелляцию в случае, если их учетные записи были приостановлены из-за недоразумений.

Инсайдерское злоупотребление

Несмотря на то, что эта функция предназначена для благотворительных целей, эта функция может обернуться для некоторых людей полной катастрофой, если их устройства будут зарегистрированы в системе, с их ведома или без их ведома, родственниками, заинтересованными в отслеживании их общения.

Даже если этого не произойдет, Apple создала бэкдор, чтобы сделать данные пользователей доступными в конце дня. Теперь это вопрос мотивации и решимости людей получить доступ к личной информации других людей.

Это не только способствует серьезному нарушению конфиденциальности, но и открывает путь для оскорбительных, токсичных или контролирующих родственников, опекунов, друзей, любовников, опекунов и бывших для дальнейшего вторжения в чье-либо личное пространство или ограничения их свободы.

С одной стороны, он предназначен для борьбы с сексуальным насилием над детьми; с другой стороны, его можно использовать для дальнейшего увековечения других видов злоупотреблений.

Государственный надзор

Apple всегда позиционировала себя как бренд, более заботящийся о конфиденциальности, чем его конкуренты. Но теперь, возможно, он вступит на скользкую дорожку, когда придется выполнять нескончаемые требования прозрачности пользовательских данных со стороны правительства .

Система, созданная для обнаружения педофильских материалов, может использоваться для обнаружения любого контента на телефонах. Это означает, что правительства с культовым менталитетом могут контролировать пользователей на более личном уровне, если они получат это в свои руки.

Вмешательство государства в вашу повседневную и личную жизнь может быть подавляющим или нет, но оно может расстраивать вас и является вторжением в вашу частную жизнь. Мысль о том, что вам нужно беспокоиться о таких вторжениях только в том случае, если вы сделали что-то не так, является ошибочным мышлением и не видит вышеупомянутого скользкого пути.

Ложные тревоги

Одна из самых больших проблем при использовании алгоритмов сопоставления изображений с базой данных – ложные срабатывания. Алгоритмы хеширования могут ошибочно идентифицировать две фотографии как совпадающие, даже если они не совпадают. Эти ошибки, называемые «коллизиями», вызывают особую тревогу в контексте материалов о сексуальном насилии над детьми.

Исследователи обнаружили несколько коллизий в NeuralHash после того, как Apple объявила, что будет использовать алгоритм для сканирования изображений. Apple ответила на вопросы о ложных срабатываниях, указав, что результат будет проверен человеком в конце, поэтому людям не нужно беспокоиться об этом.

Пауза CSAM от Apple постоянна?

У предлагаемой Apple функции есть много плюсов и минусов. Каждый из них настоящий и выдерживает вес. Пока неясно, какие именно изменения Apple может внести в функцию сканирования CSAM, чтобы удовлетворить своих критиков.

Это может ограничить сканирование общими альбомами iCloud вместо того, чтобы задействовать устройства пользователей. Маловероятно, что Apple полностью откажется от этих планов, поскольку компания обычно не склонна уступать своим планам.

Однако, судя по широко распространенной негативной реакции и сдерживанию Apple своих планов, компаниям следует с самого начала привлекать исследовательское сообщество, особенно в отношении непроверенных технологий.