Нет, ChatGPT не приведет к еще одной нехватке графического процессора.

ChatGPT стремительно развивается, и основа его модели искусственного интеллекта опирается на видеокарты Nvidia. Один аналитик сказал, что для обучения ChatGPT использовалось около 10 000 графических процессоров Nvidia, и по мере того, как сервис продолжает расширяться, растет и потребность в графических процессорах. Любой, кто пережил рост криптографии в 2021 году, может почувствовать нехватку графических процессоров на горизонте.

Я видел, как несколько репортеров выстраивали именно такую связь, но она ошибочна. Дни нехватки графических процессоров, основанных на криптографии, остались позади. Хотя мы, вероятно, увидим всплеск спроса на видеокарты, поскольку ИИ продолжает бум, этот спрос не направлен на лучшие видеокарты, установленные в игровых системах.

Почему графические процессоры Nvidia созданы для ИИ

Во-первых, мы рассмотрим, почему видеокарты Nvidia так хороши для ИИ. Nvidia делала ставку на ИИ в течение последних нескольких лет, и это окупилось благодаря резкому росту курса акций компании после появления ChatGPT. Есть две причины, по которым вы видите Nvidia в центре обучения ИИ: тензорные ядра и CUDA.

CUDA — это интерфейс прикладного программирования (API) Nvidia, который используется везде, от самых дорогих графических процессоров для центров обработки данных до самых дешевых игровых графических процессоров. Ускорение CUDA поддерживается в библиотеках машинного обучения, таких как TensorFlow, что значительно ускоряет обучение и логические выводы. CUDA является движущей силой того, что AMD так сильно отстает в области искусственного интеллекта по сравнению с Nvidia.

Однако не путайте CUDA с ядрами CUDA от Nvidia. CUDA — это платформа, на которой работает множество приложений ИИ, а ядра CUDA — это всего лишь ядра внутри графических процессоров Nvidia. У них общее имя, а ядра CUDA лучше оптимизированы для запуска приложений CUDA. Игровые графические процессоры Nvidia имеют ядра CUDA и поддерживают приложения CUDA.

Тензорные ядра — это в основном специализированные ядра ИИ. Они обрабатывают матричное умножение, которое является секретным соусом, ускоряющим обучение ИИ. Идея здесь проста. Умножайте сразу несколько наборов данных и экспоненциально ускоряйте обучение моделей ИИ, генерируя возможные результаты. Большинство процессоров справляются с задачами линейно, в то время как тензорные ядра могут быстро генерировать сценарии за один такт.

Опять же, игровые графические процессоры Nvidia, такие как RTX 4080, имеют тензорные ядра (а иногда даже больше, чем дорогостоящие графические процессоры для центров обработки данных). Тем не менее, несмотря на все характеристики карт Nvidia для ускорения моделей ИИ, ни одна из них не так важна, как память. А у игровых графических процессоров Nvidia не так много памяти.

Все сводится к памяти

«Размер памяти — самое важное», — считает Джеффри Хитон, автор нескольких книг по искусственному интеллекту и профессор Вашингтонского университета в Сент-Луисе. «Если у вас недостаточно оперативной памяти графического процессора, подгонка/вывод модели просто останавливается».

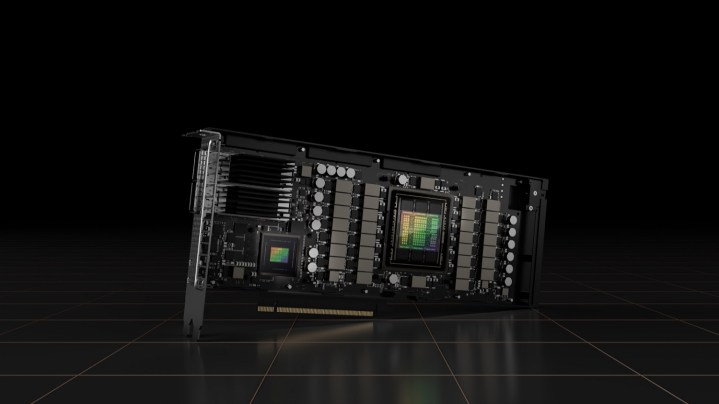

Хитон, у которого есть канал на YouTube, посвященный тому, насколько хорошо модели ИИ работают на определенных графических процессорах, отметил, что ядра CUDA также важны, но объем памяти является доминирующим фактором, когда речь идет о том, как графический процессор работает для ИИ. У RTX 4090 много памяти по игровым стандартам — 24 ГБ GDDR6X — но очень мало по сравнению с графическим процессором класса центра обработки данных. Например, новейший графический процессор Nvidia H100 имеет 80 ГБ памяти HBM3, а также массивную 5120-битную шину памяти.

Вы можете обойтись меньшим количеством памяти, но вам все равно нужно много памяти. Хитон рекомендует новичкам иметь не менее 12 ГБ, в то время как у типичного инженера по машинному обучению будет один или два профессиональных графических процессора Nvidia по 48 ГБ. По словам Хитона, «большинство рабочих нагрузок больше приходится на диапазон от одного A100 до восьми A100». Графический процессор Nvidia A100 имеет 40 ГБ памяти.

Вы также можете увидеть это масштабирование в действии. Puget Systems показывает, что одна A100 с 40 ГБ памяти работает примерно в два раза быстрее, чем одиночная RTX 3090 с 24 ГБ памяти. И это несмотря на то, что у RTX 3090 почти в два раза больше ядер CUDA и почти столько же ядер Tensor.

Узким местом является память, а не необработанная вычислительная мощность. Это связано с тем, что обучение моделей ИИ основано на больших наборах данных, и чем больше этих данных вы сможете хранить в памяти, тем быстрее (и точнее) вы сможете обучить модель.

Разные потребности, разные штампы

Игровые графические процессоры Nvidia, как правило, не подходят для ИИ из-за того, что у них мало видеопамяти по сравнению с оборудованием корпоративного уровня, но здесь также есть отдельная проблема. Графические процессоры Nvidia для рабочих станций обычно не используют один и тот же кристалл графического процессора с игровыми картами.

Например, A100, на который ссылается Хитон, использует графический процессор GA100, который представляет собой кристалл линейки Ampere от Nvidia, который никогда не использовался на картах, ориентированных на игры (включая высокопроизводительную RTX 3090 Ti ). Аналогичным образом, последний H100 от Nvidia использует совершенно другую архитектуру, чем RTX 40-й серии, а это означает, что он также использует другой кристалл.

Есть исключения. Графический процессор Nvidia AD102, который используется в RTX 4090 и RTX 4080, также используется в небольшом количестве корпоративных графических процессоров Ada Lovelace (L40 и RTX 6000). Однако в большинстве случаев Nvidia не может просто перепрофилировать кристалл игрового графического процессора для карты центра обработки данных. Это отдельные миры.

Есть некоторые фундаментальные различия между нехваткой графических процессоров, которую мы наблюдали из-за крипто-майнинга, и ростом популярности моделей ИИ. По словам Хитона, модели GPT-3 требовалось более 1000 графических процессоров Nvidia A100 для обучения и около восьми для работы. Эти графические процессоры также имеют доступ к высокоскоростному межсоединению NVLink, в то время как графические процессоры Nvidia RTX 40-й серии этого не делают. Он сравнивает максимум 24 ГБ памяти на игровых картах Nvidia с несколькими сотнями на графических процессорах, таких как A100 с NVLink.

Есть и другие проблемы, такие как выделение кристаллов памяти для профессиональных графических процессоров, а не для игровых, но дни спешки в местный центр Micro Center или Best Buy в поисках возможности найти графический процессор на складе прошли. Хитон хорошо резюмировал этот момент: «По оценкам, для работы больших языковых моделей, таких как ChatGPT, требуется как минимум восемь графических процессоров. Такие оценки предполагают высокопроизводительные графические процессоры A100. Я предполагаю, что это может привести к нехватке высокопроизводительных графических процессоров, но не повлияет на графические процессоры игрового класса с меньшим объемом оперативной памяти».