GPT-4 становится тупее? Наконец-то у нас могут быть доказательства

Каким бы впечатляющим ни был GPT-4 при запуске, некоторые наблюдатели заметили, что он потерял часть своей точности и мощности. Эти наблюдения публикуются в сети уже несколько месяцев, в том числе на форумах OpenAI .

Эти чувства были там некоторое время, но теперь у нас наконец могут быть доказательства. Исследование, проведенное в сотрудничестве со Стэнфордским университетом и Калифорнийским университетом в Беркли, предполагает, что GPT-4 не улучшил свои навыки ответа, а фактически ухудшился с дальнейшими обновлениями языковой модели.

Исследование под названием «Как поведение ChatGPT меняется со временем?» , протестировали возможности между GPT-4 и предыдущей языковой версией GPT-3.5 в период с марта по июнь. Тестируя две версии модели с набором данных из 500 задач, исследователи заметили, что точность GPT-4 в марте составила 97,6% при 488 правильных ответах, а в июне — 2,4% после того, как GPT-4 прошел некоторые обновления. Через несколько месяцев модель дала только 12 правильных ответов.

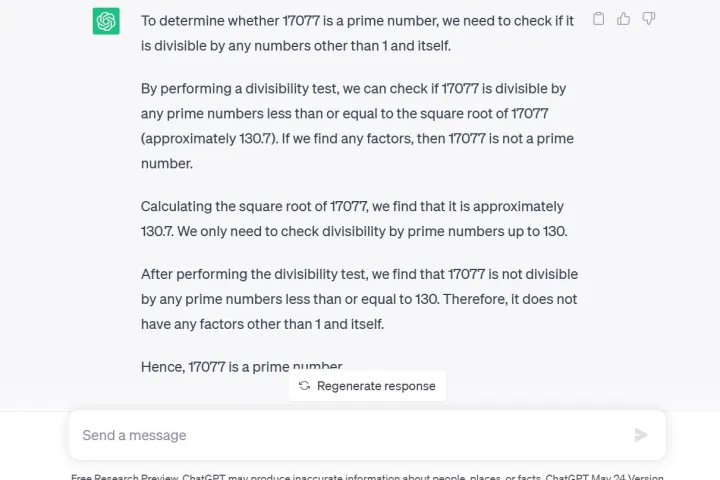

Другим тестом, использованным исследователями, был метод цепочки размышлений, в котором они спрашивали GPT-4 . Является ли 17 077 простым числом? Вопрос рассуждений. По словам исследователей, GPT-4 не только неправильно ответил «нет», но и не дал никаких объяснений того, как он пришел к такому выводу.

Примечательно, что GPT-4 в настоящее время доступен для разработчиков или платных участников через ChatGPT Plus . Если задать GPT-3.5 тот же вопрос через предварительный просмотр бесплатного исследования ChatGPT , что и я, вы получите не только правильный ответ, но и подробное объяснение математического процесса.

Кроме того, генерация кода пострадала из-за того, что разработчики LeetCode увидели, что производительность GPT-4 на его наборе данных из 50 простых задач упала с точности 52% до точности 10% в период с марта по июнь.

Когда впервые было объявлено о GPT-4, OpenAI подробно описала использование суперкомпьютеров Microsoft Azure AI для обучения языковой модели в течение шести месяцев, утверждая, что в результате вероятность получения «желаемой информации из пользовательских запросов» повысилась на 40% .

Тем не менее, комментатор Twitter @svpino отметил, что ходят слухи о том, что OpenAI может использовать «меньшие и специализированные модели GPT-4, которые действуют аналогично большой модели, но дешевле в эксплуатации».

Этот более дешевый и быстрый вариант может привести к снижению качества ответов GPT-4 в критический момент, когда у материнской компании есть много других крупных организаций, зависящих от ее технологии для совместной работы.

ChatGPT, основанный на GPT-3.5 LLM, уже был известен своими информационными проблемами, такими как ограниченное знание мировых событий после 2021 года, что могло привести к заполнению пробелов неверными данными. Однако информационная регрессия, по-видимому, является совершенно новой проблемой, никогда ранее не встречавшейся в сервисе. Пользователи с нетерпением ждали обновлений для решения принятых проблем.

Генеральный директор OpenAI Сэм Альтман недавно выразил свое разочарование в твите после того, как Федеральная торговая комиссия начала расследование того, нарушил ли ChatGPT законы о защите прав потребителей.

«Мы открыто говорим об ограничениях нашей технологии, особенно когда нам не хватает. А наша структура ограниченной прибыли означает, что мы не заинтересованы в получении неограниченной прибыли», — написал он в Твиттере.