Контратака Кореи N Room 2.0! Когда обычные люди полностью терпят поражение от изменения лица ИИ, они используют магию, чтобы победить магию.

Недавний инцидент с «Комнатой N 2.0» в Южной Корее вновь выдвинул на передний план банальную тему Deepfake.

Преступники собрались в Telegram и с помощью ИИ синтезировали женские фотографии в обнаженные, что показывает, что круг дипфейков уже расширился от звезд шоу-бизнеса и политиков до обычных людей, таких как мы с вами.

В эпоху, когда искусственный интеллект стал важной наукой, мы хотим понять, как эта технология, которая кажется не новой, но в последние годы становится все более популярной, влияет на повседневную жизнь.

В какой степени развились дипфейки и какой вред они причинят? Как использовать технологии для борьбы с Deepfake? Как обычные люди предотвращают Deepfakes?

Мы поговорили об этих проблемах с доктором Чэнь Пэном, ученым из компании Ruilai Intelligent Algorithm. Компания Ruilai Wisdom была основана в 2018 году и создана Научно-исследовательским институтом искусственного интеллекта Университета Цинхуа. Она уже много лет активно занимается обнаружением подделок с помощью искусственного интеллекта.

Чэнь Пэн рассказал нам, что обычные люди с треском провалились в идентификации Deepfake, а борьба с Deepfake по-прежнему зависит от искусственного интеллекта.

Картинка, несколько секунд, Deepfake становится все проще и проще

Deepfake впервые появился в 2017 году на Reddit, «американская версия Tieba». Основная форма — замена лиц знаменитостей на главных героев порнографических видеороликов или подделка политических деятелей.

Сегодня распространение слухов и участие в порнографии по-прежнему являются основными видами использования Deepfakes, но с тех пор это стало проще.

Чэнь Пэн объяснил, что сбора одной фотографии достаточно, чтобы изменить лицо. Конечно, чем больше данных будет собрано, тем лучше будут смоделированы детали лица, такие как родинки и черты лица, и тем более реалистичным будет эффект изменения лица. .

Живым примером стал в апреле этого года перформанс-проект двух немецких художников.

Они разработали AI-камеру NUCA. Корпус камеры напечатан на 3D-принтере и имеет встроенный широкоугольный объектив 37 мм. Сделанные фотографии будут передаваться в облако, где ИИ «снимет одежду» и фотография будет. быть «вывезены» менее чем за 10 секунд.

NUCA на самом деле не знает, как выглядит ваше обнаженное тело. Он только анализирует ваш пол, лицо, возраст, форму тела и т. д., чтобы представить ваше обнаженное тело в глазах ИИ.

Грубый? Возможно, это не имеет значения. Через несколько секунд вы подверглись воздействию ИИ, и другие могут поверить, что это вы.

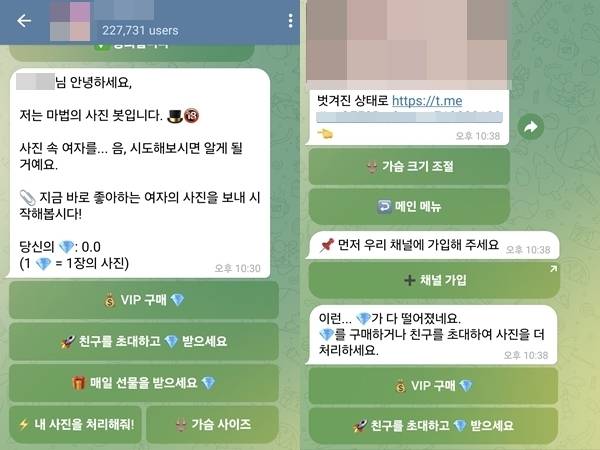

Южнокорейская «Комната N 2.0» также была раскрыта с похожими деталями: чат Telegram с 227 000 человек, встроенный робот, который синтезирует женские фотографии в обнаженные фотографии и может корректировать грудь, а также генерирует дипфейковый контент за 5–7 секунд.

▲Скриншот чата, объясняющий, как использовать Deepfake

Менять лица и снимать одежду — это лишь одно из применений Deepfake.

Использование генеративных моделей искусственного интеллекта (GAN, VAE, диффузионной модели и т. д.) для синтеза или создания реалистичного контента, включая текст, изображения, аудио и видео, можно назвать Deepfake.

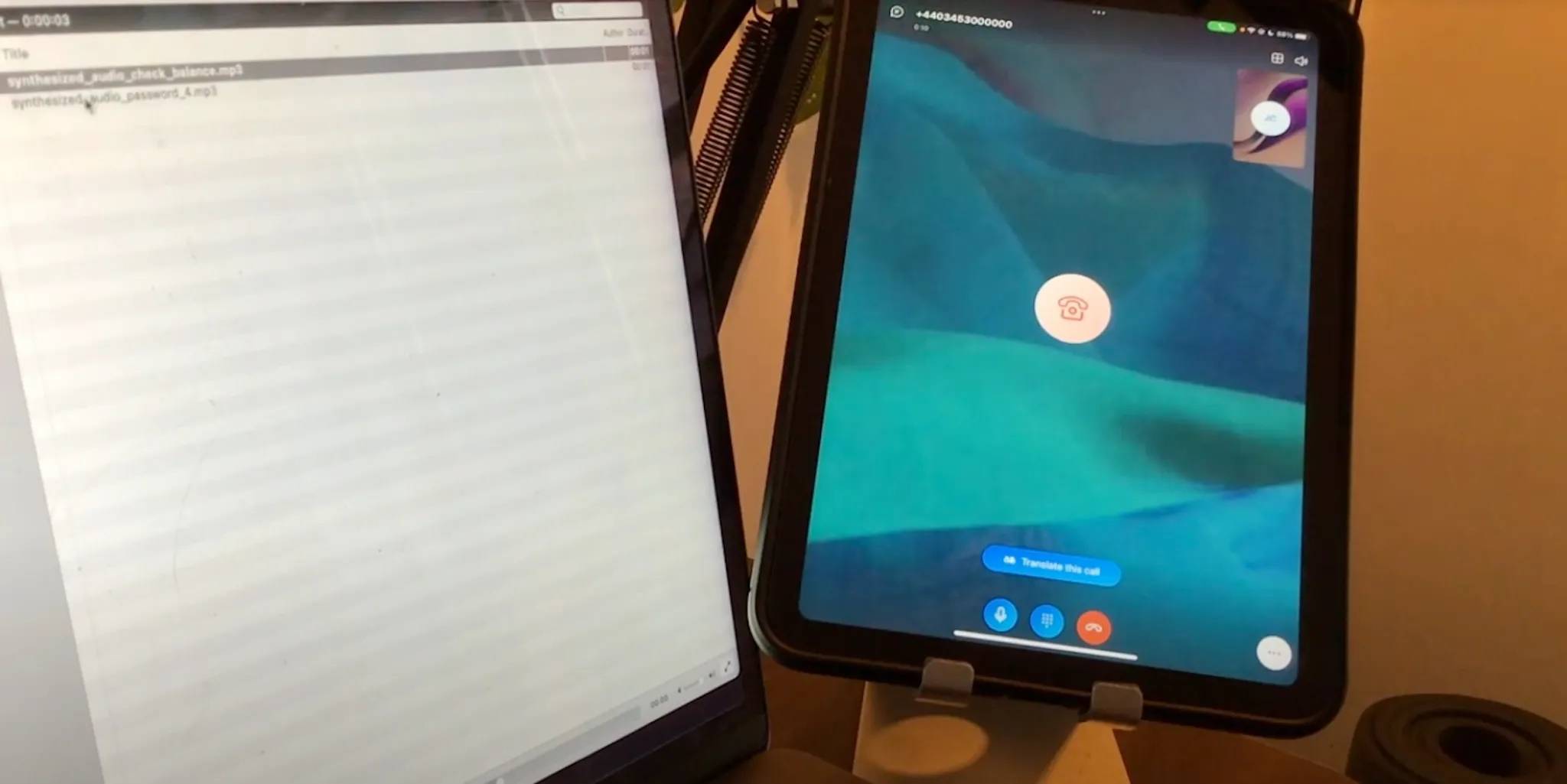

Среди них также довольно распространен аудиодипфейк.

В начале 2023 года репортер по технологиям Джозеф Кокс позвонил на горячую линию автоматизированного обслуживания банка, включил голос искусственного интеллекта «Мой голос — мой пароль», который он клонировал с помощью ElevenLabs, и попросил проверить баланс. Неожиданно голосовая верификация прошла успешно.

Чэнь Пэн сказал, что это неудивительно. Раньше на сбор информации о голосовых отпечатках уходило несколько минут или десятков минут, но теперь ее можно получить примерно за полминуты или десятки секунд. Если мы получим еще несколько тревожных звонков, наши голоса могут быть раскрыты.

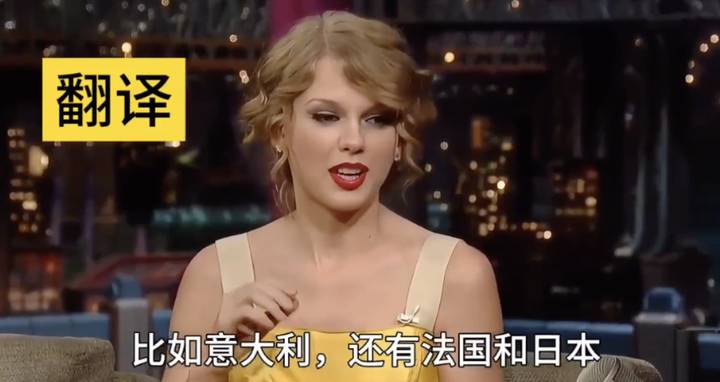

Конечно, если вы хотите более точно клонировать и скопировать тон и другие стили речи, например, позволить Го Дэгану говорить по-английски перекрестным разговором или позволить Свифту говорить по-китайски, вам все равно понадобится больше корпуса.

Даже текст — это область, которая глубоко подделана. Текст, сгенерированный ИИ, уже давно можно увидеть повсюду, и он вызывает головную боль у учителей, когда ученики используют его для списывания и выполнения домашних заданий, но мы можем не осознавать скрытые за этим риски.

Ложные новости и слухи — наиболее уязвимые области текстовых дипфейков. Чэнь Пэн сказал, что раньше людям все еще приходилось писать текст самостоятельно, но теперь ИИ может генерировать различные комментарии об определенном событии, а затем автоматически публиковать их в социальных сетях. .

Deepfake быстрее и проще. По мнению Чэнь Пэна, есть три основные причины.

Во-первых, произошли прорывы в технологиях генеративного ИИ, таких как Vincent Pictures и Vincent Videos. Во-вторых, вычислительная мощность становится все более популярной, и видеокарты потребительского уровня уже могут запускать генеративные модели ИИ.

Еще одним очень важным моментом является то, что технология Deepfake была оптимизирована для различных инструментов с более низкими пороговыми значениями.

Возьмем в качестве примера изменение лица. Для Deepfake существует множество проектов с открытым исходным кодом, таких как DeepFaceLive и Deep-Live-Cam. Пользователи могут загрузить код с веб-сайта и настроить рабочую среду локально.

▲Прямая трансляция AI Маска с использованием Deep-Live-Cam

Если новичкам, не разбирающимся в технологиях, все еще сложно, есть и профессионалы, которые кладут рис прямо в рот, инкапсулируют модель и записывают ее в простое и удобное в использовании программное обеспечение, которое игроки могут загрузить бесплатно, и самостоятельно заработать некоторые рекламные сборы, в том числе множество приложений для раздевания в один клик.

Что касается аудио-дипфейков, то уже существуют зрелые коммерческие компании, которые позволяют пользователям легко использовать сервисы в виде SDK (комплекта разработки) или API (интерфейса прикладного программирования).

Пользователям даже не требуется устройство с видеокартой для развертывания программы, они вместо этого загружают контент, например аудио, на веб-сайт, ждут получения результатов, а затем загружают их.

Поэтому сложные технические принципы скрыты за кадром, а перед пользователями — «нестандартные» интерфейсы. Даже подростки могут по своему желанию создавать ложную информацию.

Вкратце, вывод Чэнь Пэна таков:

Дипфейк дошел до того, что обычные люди могут легко его получить.

Люди, возможно, совершенно не смогли распознать Deepfake невооруженным глазом.

Когда технология «влетает в дома обычных людей», пострадают, скорее всего, обычные люди.

Мошенничество — один из наиболее распространенных способов, с помощью которых дипфейки творят зло.

В начале этого года гонконгский филиал транснациональной компании был украден из-за ИИ на 25 миллионов долларов США. Жертва участвовала в видеоконференции, а остальные были мошенниками, прошедшими «изменение лица с помощью ИИ» и «изменение голоса с помощью ИИ».

▲Полиция продемонстрировала, как использовать Deepfake для фальсификации видеоконференции с участием нескольких человек.

Теперь, когда дело дошло до этого, что мы можем сделать, чтобы защитить себя?

Если кто-то использует Deepfake, чтобы вас обмануть, одним из способов является использование лазеек ИИ, но у него есть срок годности.

Например, во время видеозвонка, если мы подозреваем, что лицо собеседника было заменено искусственным интеллектом, мы можем предложить собеседнику выполнить определенные действия, например, поднести руку к лицу и несколько раз быстро провести пальцем по экрану. или значительно повернув голову.

Если модель, лежащая в основе замены лица ИИ, специально не оптимизирована для окклюзии рук, она будет обнажена, и лицо может появиться на тыльной стороне руки или может внезапно исказиться.

Принцип поворота головы тот же. Если на этапе сбора данных другая сторона намеренно не соберет материал поворота головы более чем на 45 градусов, то посадка лица будет неестественной.

Но в будущем такие недостатки, видимые невооруженным глазом, обязательно постепенно уменьшатся.

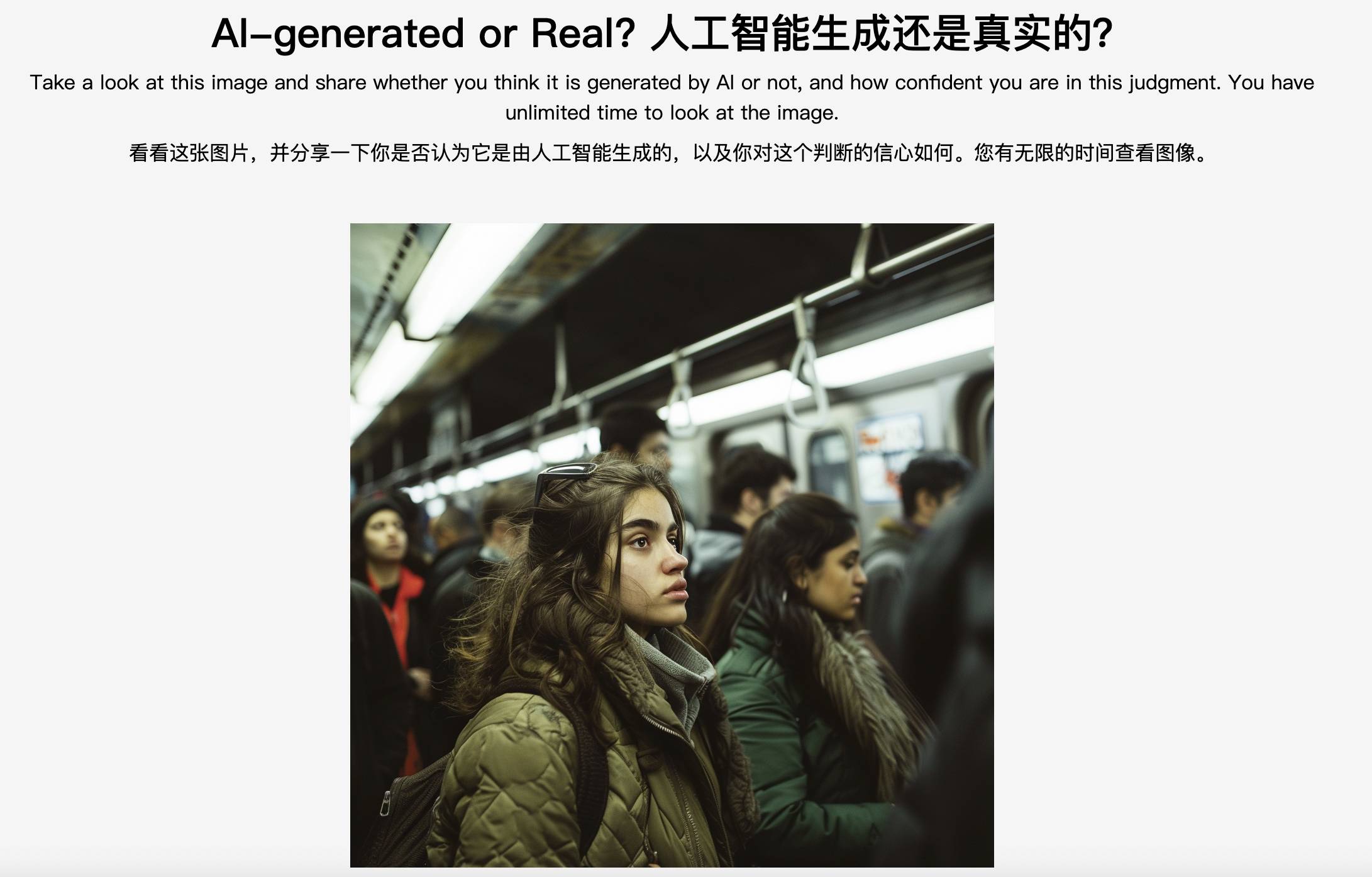

▲Тест Северо-Западного университета «Устранение неполадок»: созданный ИИ или реальный?

Чэнь Пэн пошутил, что если мошенники думают, что вы жирная овца, ожидающая заклания, и намеренно хотят обмануть вас, лишить вас информации в социальных сетях и потратить несколько дней на оптимизацию вашей модели, то эффективность этих методов не гарантирована.

Если видео не имеет этих недостатков, значит ли это, что это настоящее видео? Это неправда.

Что касается того, эффективен он или нет, то он, конечно, не может быть полностью эффективным или на 100% эффективным, но в определенной степени он эффективен.

Говоря более профессиональным языком, зрительное восприятие человека очень хорошо работает на семантическом уровне, например, позволяет легко различать значение объектов или сцен, но когда дело доходит до обработки низкоуровневых нюансов на уровне пикселей, восприятие способность не так хороша, как у модели.

С этой точки зрения Чэнь Пэн считает, что обычные люди с треском не смогли отличить Deepfake. Эксперты, возможно, все еще смогут бороться, потому что они видели слишком много и обладают относительно всесторонними возможностями анализа и могут видеть, что что-то не соответствует правилам.

Никто из нас не Левенгук, и у нас нет острого зрения, но человеческая природа остается неизменной. Поэтому мы можем подтянуть и традиционную линию психологической защиты, не имеющую ничего общего с техникой – будьте осторожны при плавании.

Мошенничества часто следуют одной и той же схеме: воровство конфиденциальности, использование страха, жадности и эмоциональной ценности для придумывания историй, выдача себя за знакомых или маскировка себя, чтобы завоевать доверие, а конечная цель — деньги.

▲Продукт RealBelieve компании Realai Smart будет выдавать ранние предупреждения во время видеозвонков.

Имейте это в виду, а затем будьте более бдительны, не переходите по незнакомым ссылкам, не давайте случайно коды подтверждения, старайтесь не слишком выставлять свое лицо, голос, отпечатки пальцев и другую личную биометрическую информацию в Интернете, получать подозрительные телефонные звонки, и иметь разное мнение, когда дело касается денег. Способы проверки личности друг друга, например, спрашивать о вещах, которые знают только друг друга.

Как гласит старая поговорка, лучшее, что можно сделать, — это атаковать сердце. Как только мы осознаем, что нас могут обмануть, нас можно не обмануть.

Магия против магии, ИИ побеждает ИИ

Недостаточно повысить осведомленность о борьбе с мошенничеством. Инцидент с «Комнатой N 2.0» в Южной Корее демонстрирует еще одну форму дипфейкового зла. Люди сидят дома, а горшки приходят с неба.

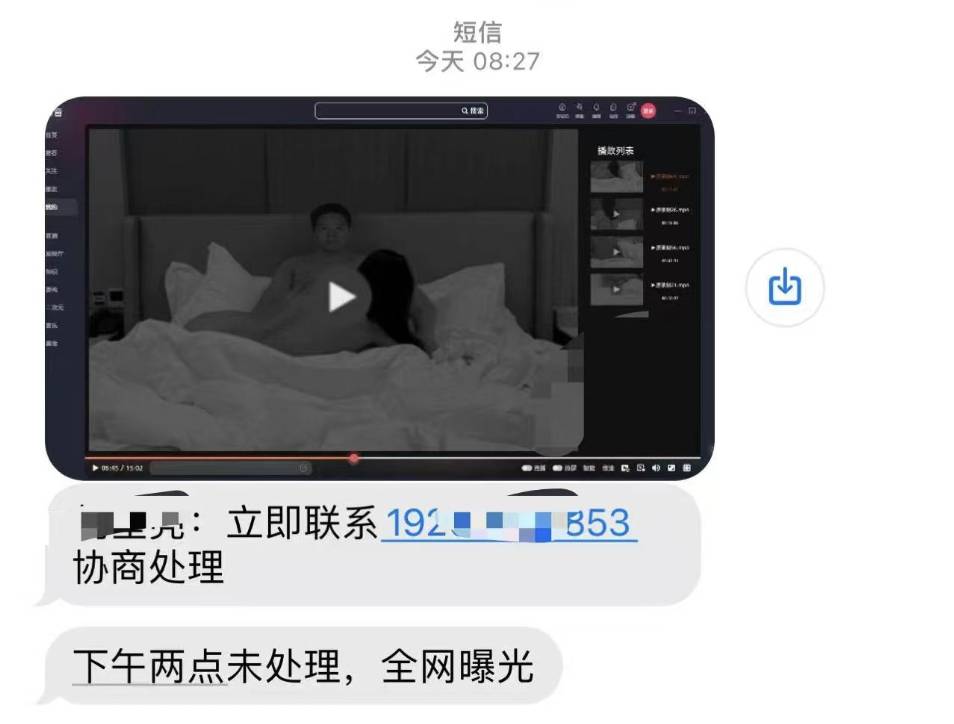

Жертвы фейковых фотографий обнаженной натуры могут столкнуться с «порноместью» — преступники угрожают распространить дипфейковые материалы, чтобы шантажировать и преследовать жертв, причиняя более серьезный вторичный вред.

Но этот серп может быть поднят и над нашими головами: представьте, что банда мошенников взяла ваши фотографии из ниоткуда, объединила их в вульгарные видеоролики, отправила вам текстовые сообщения с угрозами, и если вы не переведете деньги, они будут разоблачены. по всему Интернету. Как вы можете проявить себя?

Жуйлай Мудрость, где работает Чэнь Пэн, действительно сталкивалась с подобными личными делами. Другая сторона сказала, что его лицо изменилось на видео, и можно ли его очистить?

Конечно, есть способы: магия против магии, ИИ побеждает ИИ.

Чэнь Пэн сообщил, что существует два основных технических пути подделки ИИ: активная защита и пассивное обнаружение.

Давайте сначала поговорим об активной защите. Когда мы публикуем фотографии в социальных сетях и не хотим, чтобы их использовали другие, мы можем внедрить в них какой-то визуально незаметный шум.

Если кто-то другой использует наши фотографии для обучения модели, ИИ не сможет хорошо извлечь визуальное представление из-за этого невидимого вмешательства, и конечный результат может быть искажен или размыт. Это называется «атакой состязательного образца». "

«Полууязвимый водяной знак» — еще один метод активной защиты. Если после добавления водяного знака кто-то другой отредактирует нашу фотографию, водяной знак будет уничтожен, и мы будем знать, что изображение было обработано и не заслуживает доверия.

Водяные знаки не могут напрямую предотвратить подделку изображений, но они могут обнаружить и подтвердить подлинность изображений.

▲Похожие исследования проводятся за рубежом. Adobe инициировала стандарт C2PA, используя параметры метаданных как способ определения источника изображений.

Конечно, порог активной защиты выше, поэтому нужно принять меры предосторожности, прежде чем они произойдут, и заранее провести некоторую обработку изображений.

Более распространенная ситуация заключается в том, что мы не можем ее предсказать. Мы получаем «обнаженные фотографии» самих себя, но это также первый раз, когда мы «откровенны» сами с собой. В это время необходимо использовать пассивное обнаружение.

Realai Intelligence имеет ряд продуктов искусственного интеллекта, отвечающих за обнаружение подделок, в том числе платформу генеративного обнаружения контента искусственного интеллекта DeepReal, брандмауэр безопасности лицевого искусственного интеллекта RealGuard и так далее.

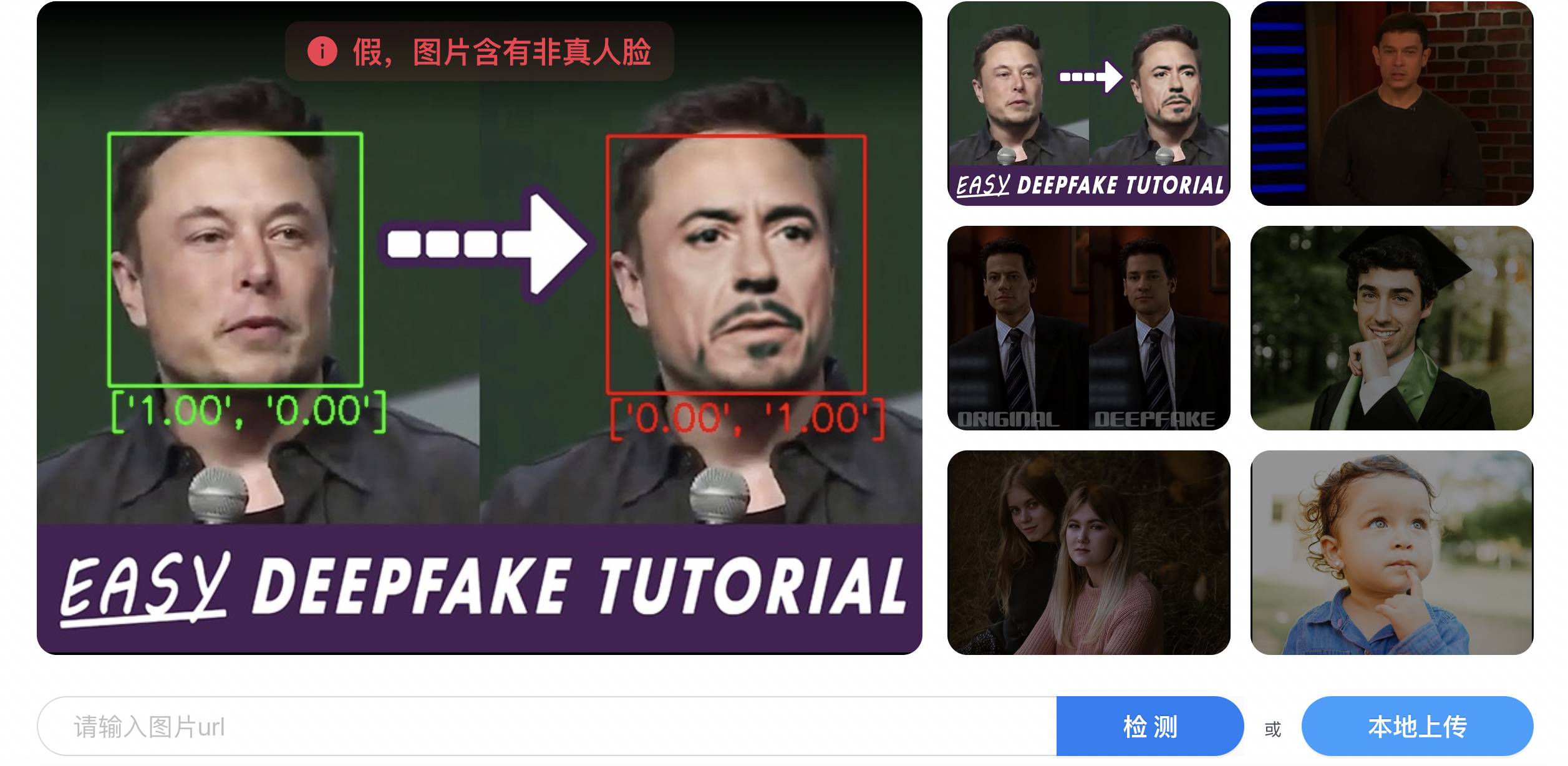

▲ДеапРеал

Проще говоря, использование ИИ для идентификации ИИ делится на два этапа: сначала извлекается большое количество признаков подделки, а затем моделируется на основе этих образцов, чтобы позволить ИИ изучить правила идентификации подделки.

Искаженные цвета, необоснованные текстуры, неестественные выражения лиц, рассинхронизация звука и видео, неправильная форма радужной оболочки и непоследовательные блики двух зрачков — все это учебные материалы для ИИ.

Среди них точность подделки видео может быть выше, чем у изображений, поскольку видео состоит из серии непрерывных изображений, что дает больше информации, которую можно использовать для подделки, чем одно изображение, например, появление персонажа между разными изображениями. кадры, непрерывность действия.

По сути, подделка ИИ немного похожа на использование человеческих глаз для поиска неисправностей, а также использует недостатки самой модели ИИ.

▲ Исследователи Китайской академии наук открыли миру модель искусственного интеллекта для обнаружения Deepfake.

Но постепенно дефекты обязательно исправятся, поэтому возникает очень острый вопрос: сначала подделка, а потом аутентификация? Если да, то не будет ли подделка всегда на полшага позади подделки?

Чэнь Пэн ответил, что созданная технология, возможно, немного опережает технологию подделки, но у них есть внутренняя красно-синяя лаборатория атаки и защиты, которая имитирует Deepfake, одновременно защищаясь от Deepfake, и постоянно совершенствует возможности обнаружения Deepfake.

Если появляется какая-либо новая технология Deepfake, они могут быстро воспроизвести ее, а затем проверить на продукте обнаружения. «Когда появляется новая технология, даже если я ее еще не видел, я все равно могу ее обнаружить в определенной степени».

Более того, сама модель также обладает определенной способностью к обобщению. Она видела много контента Deepfake и может в определенной степени точно идентифицировать и обнаружить его, если сталкивается с невидимым контентом.

▲ Такие платформы, как Bilibili, будут маркировать развлекательный контент, меняющий лицо с помощью ИИ.

Короче говоря, подделка и обнаружение подделок с помощью ИИ — это «игра в кошки-мышки», состоящая из долгосрочного противостояния и взаимной конкуренции.

Вот почему Чэнь Пэн изучает алгоритмы подделки ИИ:

Анти-Deepfake слишком конфронтационен и требует долгосрочных инвестиций. В отличие от многих продуктов искусственного интеллекта, о нем можно забыть после того, как вы его закончите.

Несмотря на это, он по-прежнему настроен относительно оптимистично: «Используйте законы и правила для контроля, платформы управляют контентом, индустрия предоставляет технологии и инструменты, а средства массовой информации информируют больше людей о рисках. Если многогранное управление достигнет определенного уровня, произойдет определенно будет послабление».

В будущем при серфинге в Интернете мы можем попасть в такой несколько абсурдный сценарий: проверочный код позволяет доказать «я человек», а Deepfake позволяет доказать «я не я».

Технология не может полностью обнаружить все злонамеренные намерения, но людям не стоит слишком беспокоиться. Успех Deepfake — это только конечный результат, но предотвращение Deepfake может начаться в любой момент.

Как сказал Чэнь Пэн, даже очень простой продукт искусственного интеллекта — это очень систематический проект.

Мы являемся частью более крупной системы. Пусть пострадавшие выскажутся, пусть виновные будут наказаны, пусть вмешаются технологии, предотвращающие злые дела, и пусть концепция общества улучшится хотя бы на дюйм. справедливое использование будущего.

# Добро пожаловать на официальную общедоступную учетную запись WeChat aifaner: aifaner (идентификатор WeChat: ifanr). Более интересный контент будет предоставлен вам как можно скорее.

Ай Фанер | Исходная ссылка · Посмотреть комментарии · Sina Weibo