ToF против LiDAR: в чем разница?

В последнее время вокруг LiDAR на новых устройствах Apple так много шумихи, что легко забыть, что мобильная дополненная реальность может работать и по-другому. Но это возможно и происходит, особенно с инструментами ToF, которые достигают новых высот в телефонах Samsung.

Независимо от того, являетесь ли вы разработчиком, ищете новое устройство или просто любопытным, стоит потратить некоторое время, чтобы распаковать эти сокращения и изучить все тонкости определения глубины на мобильных телефонах.

Что такое ToF?

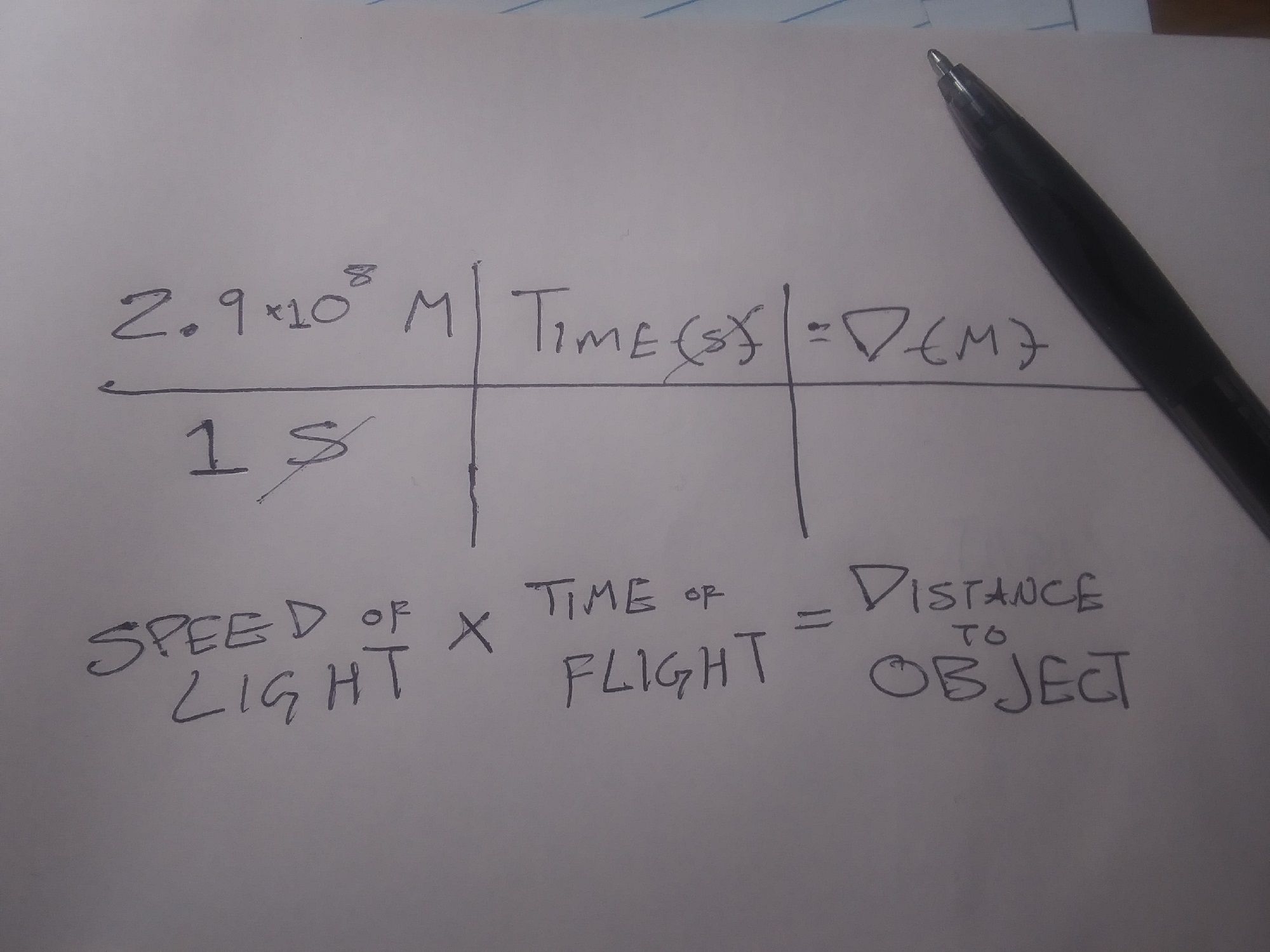

ToF – сокращение от Time of Flight.

Технически ToF означает использование скорости света (или даже звука) для определения расстояния. Он измеряет время, которое требуется свету (или звуку), чтобы покинуть устройство, отразиться от объекта или плоскости и вернуться к устройству, все деленное на два, показывает расстояние от устройства до объекта или плоскости.

Итак, связь такова, что весь LiDAR – это тип Time of Fight, но не все Time of Flight – это LiDAR. Для простоты, когда мы говорим о ToF, мы имеем в виду оптическое измерение расстояния, не включая LiDAR.

Итак, если LiDAR и оптический non-LiDAR ToF используют свет для определения расстояния и трехмерного картографирования, чем они отличаются?

Что такое лидар?

LiDAR – это сокращение от Light Detection and Ranging . Эта технология использует лазер или решетку лазеров в качестве источника света в уравнении, подробно описанном выше.

Одно показание LiDAR можно использовать для измерения таких вещей, как ширина комнаты, но несколько показаний LiDAR можно использовать для создания «облаков точек». Их можно использовать для создания трехмерных моделей объектов или топографических карт целых областей.

Хотя LiDAR может быть новым для мобильных устройств, сама технология существует уже довольно давно. В немобильных условиях LiDAR используется для всего, от картографирования подводной среды до обнаружения археологических памятников.

Чем отличаются LiDAR и ToF?

Функциональное различие между LiDAR и другими формами ToF заключается в том, что LiDAR использует импульсные лазеры для построения облака точек, которое затем используется для построения трехмерной карты или изображения. Приложения ToF создают «карты глубины» на основе обнаружения света, обычно через стандартную камеру RGB.

Преимущество ToF перед LiDAR состоит в том, что ToF требует менее специализированного оборудования, поэтому его можно использовать с меньшими и менее дорогими устройствами. Преимущество LiDAR заключается в простоте, с которой компьютер может считывать облако точек по сравнению с картой глубины.

API глубины , созданный Google для устройств Android, лучше всего работает на устройствах с поддержкой ToF и работает, создавая карты глубины и распознавая «характерные точки». Эти характерные точки, часто являющиеся барьерами между светом разной интенсивности, затем используются для определения различных плоскостей окружающей среды. По сути, это создает облако точек с более низким разрешением.

Как ToF и LiDAR работают с Mobile AR

Карты глубины и облака точек – это круто, и для некоторых людей и приложений их достаточно. Однако для большинства приложений AR эти данные должны быть контекстуализированы. И ToF, и LiDAR делают это, работая вместе с другими датчиками на мобильном устройстве. В частности, эти платформы должны понимать ориентацию и движение вашего телефона.

Определение местоположения устройства в сопоставленной среде называется одновременной локализацией и сопоставлением или «SLaM». SLaM используется для других приложений, таких как автономные транспортные средства , но для мобильных приложений AR наиболее необходимо размещать цифровые объекты в физической среде.

Это особенно верно для опыта, который остается на месте, когда пользователь не взаимодействует с ним, и для размещения цифровых объектов, которые кажутся позади физических людей и объектов.

Еще один важный фактор при размещении цифровых объектов как в LiDAR, так и в ToF-приложениях – это «якоря». Якоря – это цифровые точки в физическом мире, к которым «привязаны» цифровые объекты.

В приложениях мирового масштаба, таких как Pokemon Go, это делается с помощью отдельного процесса, называемого «Геотегирование». Однако в мобильных приложениях дополненной реальности цифровой объект привязан к точкам в облаке точек LiDAR или к одной из характерных точек на карте глубины.

LiDAR лучше, чем ToF?

Строго говоря, LiDAR быстрее и точнее, чем Time of Flight. Однако это становится более значительным с более технологически продвинутыми приложениями.

Например, ToF и Google Depth API испытывают трудности с пониманием больших плоскостей с низкой текстурой, таких как белые стены. Это может затруднить приложениям, использующим этот метод, точное размещение цифровых объектов на некоторых поверхностях в физическом мире. У приложений, использующих LiDAR, меньше шансов иметь эту проблему.

Однако вряд ли эта проблема возникнет в приложениях, в которых используются более крупные или более разнообразные по текстуре среды. Кроме того, большинство мобильных потребительских приложений AR включают использование AR-фильтра на лице или теле пользователя – приложение, которое вряд ли столкнется с проблемами из-за больших нетекстурированных поверхностей.

Почему Apple и Google используют разные датчики глубины?

Выпуская свои LiDAR-совместимые устройства, Apple заявила, что они включили датчики, а также другое оборудование, чтобы «открыть больше профессиональных рабочих процессов и поддержать профессиональные фото и видео приложения». Релиз также назвал их LiDAR-совместимый iPad Pro «лучшим в мире устройством для дополненной реальности» и рекламировал приложения Apple для измерения.

Google не дал столь откровенных объяснений, почему их API глубины и новая линейка поддерживающих устройств не используют LiDAR. Помимо работы с LiDAR, что делает устройства Android более легкими и доступными, есть еще одно важное преимущество доступности.

Поскольку Android работает на мобильных устройствах, произведенных несколькими компаниями, использование LiDAR будет способствовать предпочтению LiDAR-совместимых моделей в ущерб всем остальным. Более того, поскольку для этого требуется только стандартная камера, API глубины обратно совместим с большим количеством устройств.

Фактически, Google Depth API не зависит от устройства, а это означает, что разработчики, использующие платформу Google AR для создания опыта, могут разрабатывать приложения, которые работают и на устройствах Apple.

Изучали ли вы зондирование глубины?

В этой статье основное внимание уделяется LiDAR и ToF в мобильной дополненной реальности. Во многом это потому, что эти более сложные переживания требуют самого большого объяснения. Это еще и потому, что эти впечатления самые веселые и многообещающие.

Тем не менее, подобные подходы с распознаванием глубины являются основой многих более простых и практичных инструментов и инструментов, которые вы можете использовать каждый день, даже не задумываясь. Надеемся, что чтение ToF и LiDAR даст вам больше признательности за эти приложения.