Wall-facing Intelligence завершила новый раунд финансирования в сотни миллионов юаней и выпустила вторую версию MiniCPM, высокопроизводительной небольшой стальной пушки.

Вдохновляющая история о том, как добиться больших результатов с помощью мелочи, случается не только в истории предпринимательства, но и в крупномасштабных сквозных моделях.

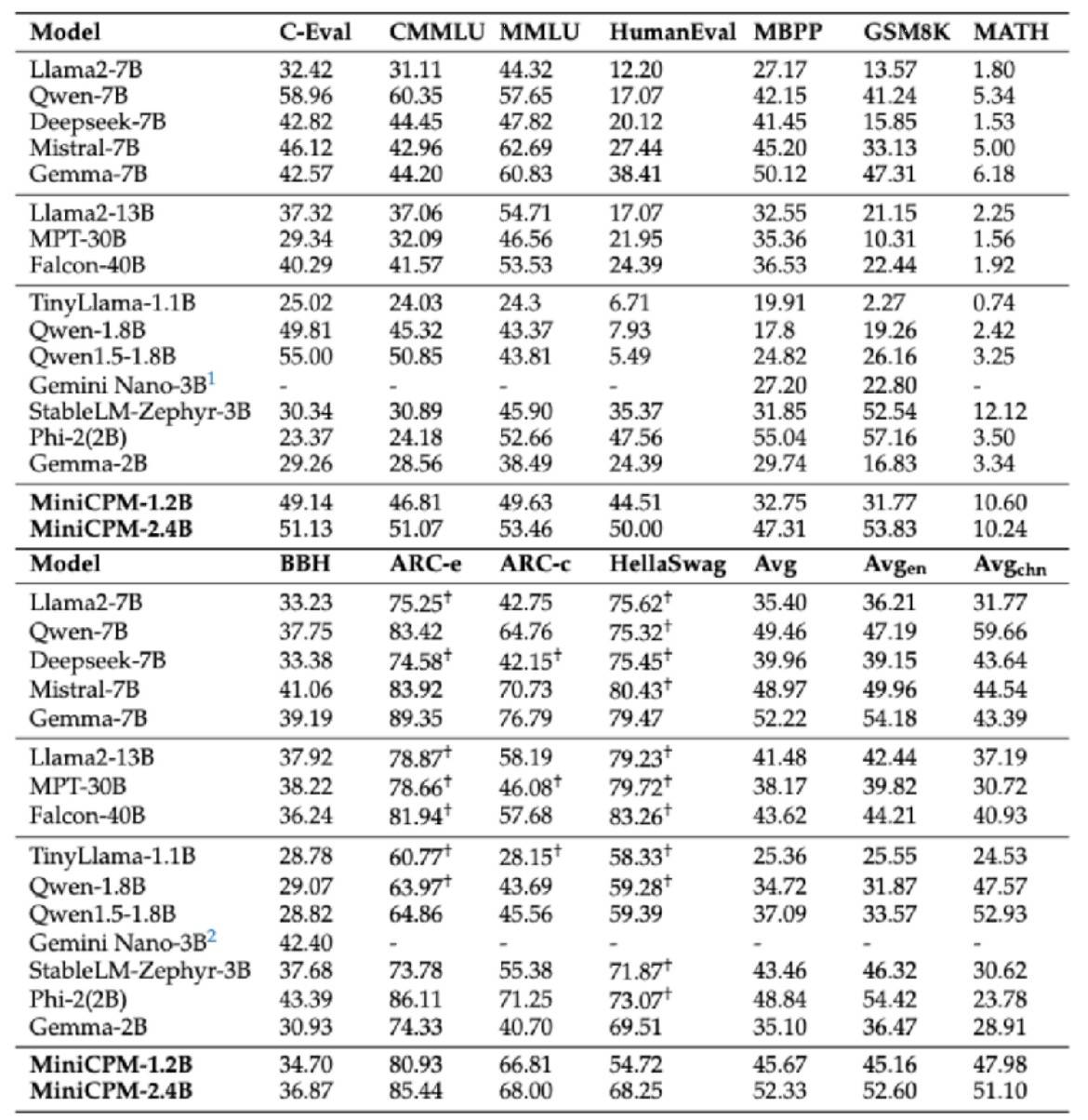

В феврале этого года компания Wall-facing Intelligence официально выпустила флагманскую крупномасштабную модель 2B Wall-facing MiniCPM, которая не только превзошла эталон производительности «европейской версии OpenAI», но и в целом опередила модель Google Gemma. 2Б, а по объему даже превосходили модели 7Б и 13Б уровня, такие как Llama2-13B и т.д.

Недавно Wall-Facing Intelligence также завершила новый раунд финансирования в несколько сотен миллионов юаней, возглавляемый Primavera Ventures и Huawei Hubble, а затем Пекинским инвестиционным фондом индустрии искусственного интеллекта и др. Чжиху, как стратегический акционер, продолжает инвестировать и поддерживать, а также стремится ускорить инвестиции. Содействовать эффективному обучению больших моделей и быстрому внедрению приложений.

Сегодня большая модель маленькой стальной пушки MiniCPM, обращенной к стене, гонится за победой и открывает вторую серию из четырех выстрелов. Основная тема – «маленький, но сильный, маленький, но полный».

Среди них мультимодальная модель MiniCPM-V2.0 значительно расширила возможности оптического распознавания символов и обновила лучшие характеристики оптического распознавания среди моделей с открытым исходным кодом. Общий текст сцены сопоставим с Gemini-Pro и превосходит всю серию моделей 13B.

В списке Object HalBench, который оценивает иллюзии больших моделей, MiniCPM-V2.0 и GPT-4V работают почти одинаково.

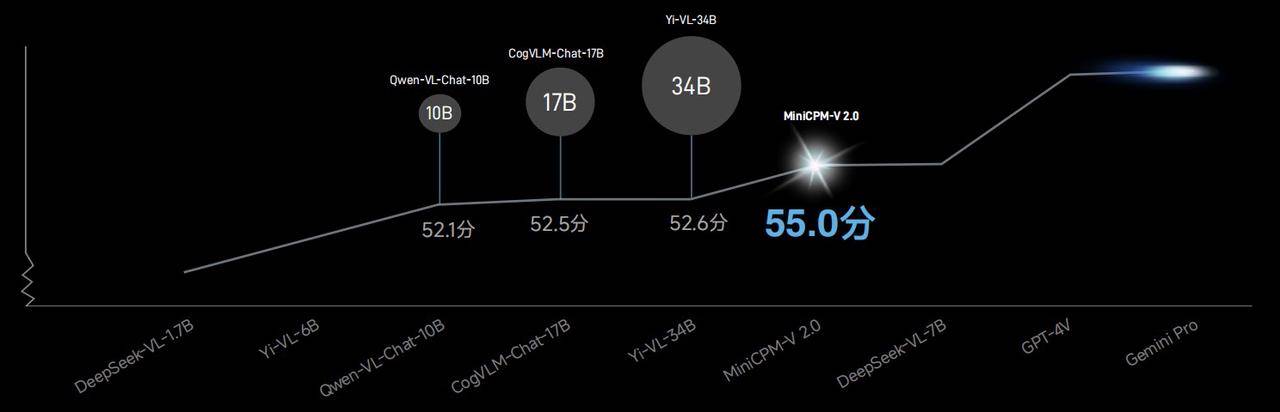

В списке OpenCompass, который объединяет 11 основных тестов оценки, общие возможности мультимодальной модели MiniCPM-V2.0 превосходят Qwen-VL-Chat-10B, CogVLM-Chat-17B, Yi-VL-34B и т. д. с оценкой 55,0. Более крупная модель.

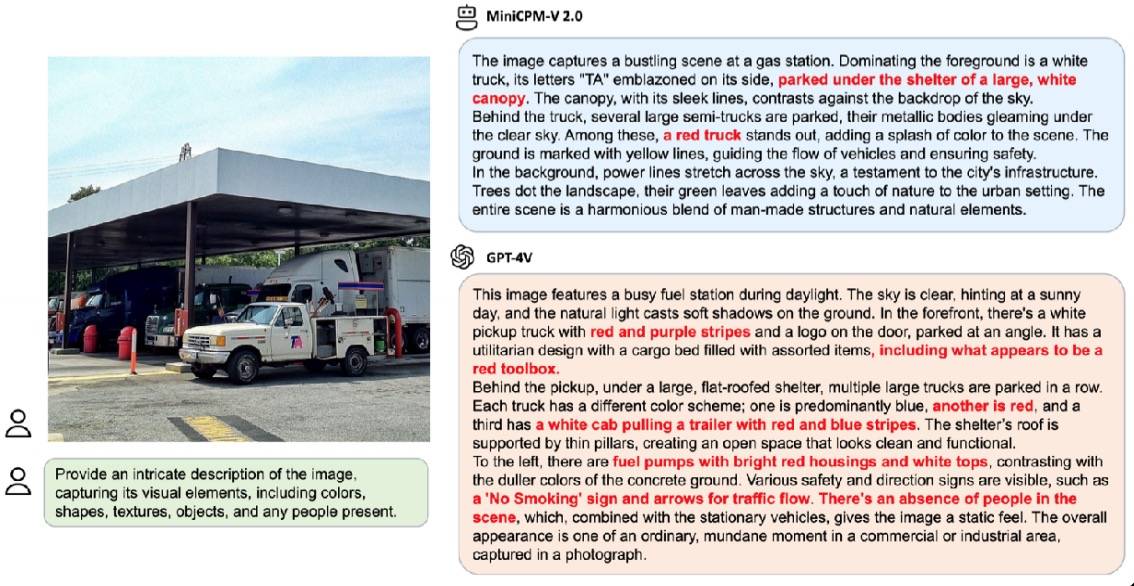

В официальном демонстрационном случае, когда его попросили подробно описать сцену одной и той же картинки, GPT-4V ответил 6 галлюцинациями, тогда как MiniCPM-V2.0 имел только 3 галлюцинации.

Кроме того, MiniCPM-V2.0 также начал углубленное сотрудничество с Университетом Цинхуа для совместного исследования сокровища музея Университета Цинхуа – Слипов Цинхуа.

Благодаря своим мощным мультимодальным возможностям распознавания и рассуждения MiniCPM-V2.0 может легко справиться, будь то распознавание простого слова «ке» или сложного слова «Я».

В конкуренции с аналогичными китайскими эталонными мультимодальными большими моделями точность распознавания MiniCPM-V2.0 находится далеко впереди.

Распознавание точных деталей предъявляет более высокие требования к четкости изображений, а традиционные большие модели обычно справляются только с небольшими изображениями размером 448 × 448 пикселей.Как только информация сжимается, модель становится трудночитаемой.

Но это не проблема для MiniCPM-V2.0. В официальном демонстрационном случае, когда мы сталкиваемся с обычным изображением городской уличной сцены, MiniCPM-V2.0 может с первого взгляда фиксировать ключевую информацию, даже если ее не обнаруживает невооруженный глаз». Family Mart» также можно легко захватить.

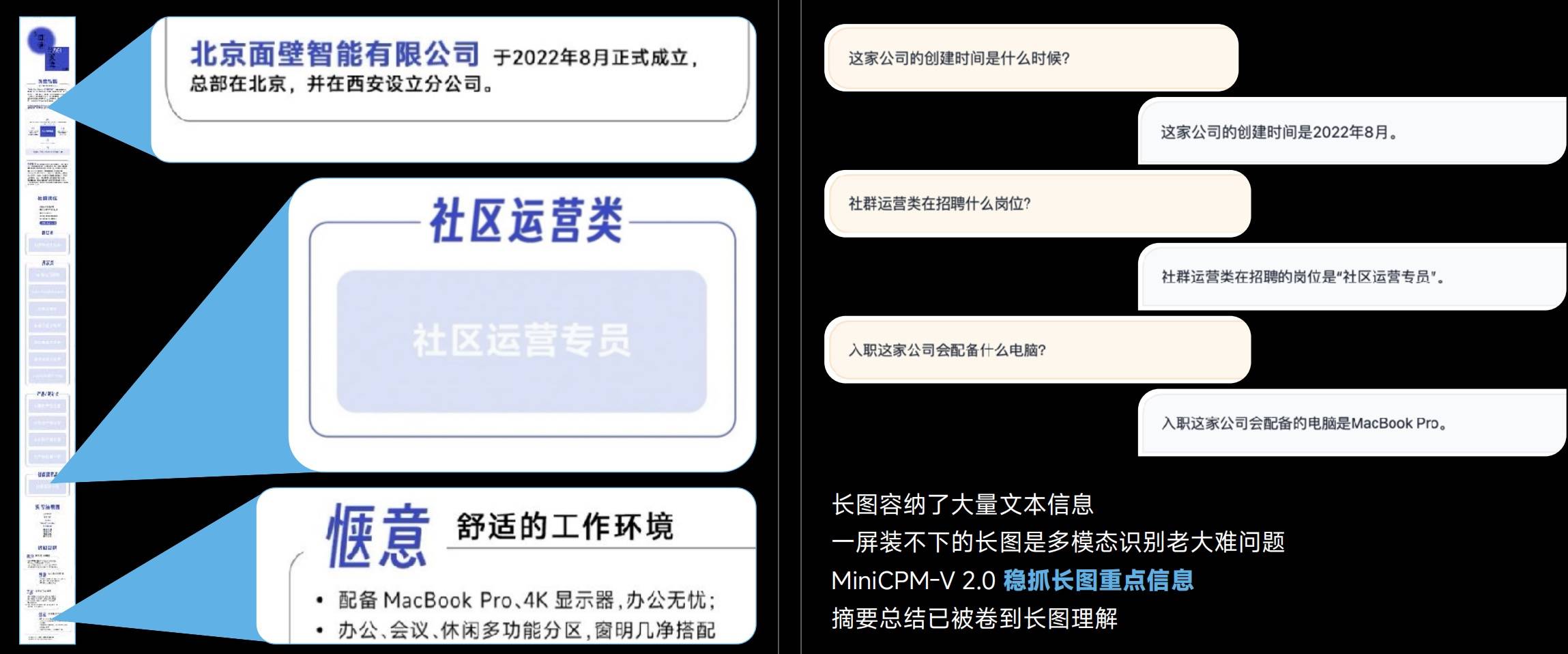

Длинные изображения содержат расширенную текстовую информацию, и мультимодальные модели часто не могут распознавать длинные изображения, но MiniCPM-V 2.0 может четко уловить ключевую информацию длинных изображений.

MiniCPM-V 2.0 может обеспечить распознавание без потерь — от 448×448 пикселей до 1,8 миллиона больших изображений высокой четкости и даже с максимальным соотношением сторон 1:9 (448 * 4032).

Понятно, что эксклюзивная технология LLaVA-UHD фактически используется для эффективного кодирования изображений высокой четкости MiniCPM-V 2.0.

- Модульное визуальное кодирование: изображение исходного разрешения делится на фрагменты переменного размера, обеспечивая полную адаптацию к исходному разрешению без заполнения пикселей или искажения изображения.

- Модуль визуального сжатия: использует общий уровень повторной выборки перцептрона для сжатия визуальных токенов фрагментов изображения. Количество токенов доступно независимо от разрешения, а вычислительная сложность ниже.

- Метод пространственной модификации: используйте простые шаблоны символов естественного языка, чтобы эффективно определять относительное положение фрагментов изображения.

По возможностям китайского оптического распознавания MiniCPM-V 2.0 также значительно превосходит GPT-4V. По сравнению с «беспомощностью» GPT-4V, его способность точно идентифицировать изображения еще более ценна.

За этой возможностью стоит поддержка технологии кросс-модального и межъязыкового обобщения, которая может решить проблему нехватки высококачественных крупномасштабных мультимодальных данных в китайской сфере.

Возможность обработки длинного текста всегда была важным критерием измерения моделей.

Хотя возможность длинного текста 128 КБ не является чем-то новым, для MiniCPM-2B-128K, размер которого составляет всего 2 КБ, это определенно заслуживает похвалы.

Самая маленькая модель длинного текста размером 128 КБ, модель длинного текста MiniCPM-2B-128K, расширяет исходное контекстное окно 4K до 128K, превосходя ряд моделей 7B, таких как Yarn-Mistral-7B-128K, в списке InfiniteBench.

Благодаря внедрению архитектуры MoE производительность недавно выпущенного MiniCPM-MoE-8x2B MoE улучшилась в среднем на 4,5%, превзойдя всю серию моделей 7B и более крупные модели, такие как LlaMA234B, при этом стоимость вывода составляет всего 69,7% от Gemma- 7Б.

MiniCPM-1.2B доказывает, что понятия «маленький» и «мощный» не исключают друг друга.

Несмотря на то, что прямые параметры были уменьшены вдвое, MiniCPM-1.2B по-прежнему сохраняет 87% полной производительности модели 2.4B предыдущего поколения. Согласно множеству общедоступных авторитетных списков испытаний, модель 1.2B очень эффективна, и ее комплексная производительность превосходит Qwen 1.8B и Qwen 1.8B Отличные результаты с Llama 2-7B и даже с Llama 2-13B.

Демонстрация записи экрана модели MiniCPM-1.2B на мобильном телефоне iPhone 15, скорость вывода увеличена на 38%. Он достиг 25 токенов/с в секунду, что в 15–25 раз быстрее скорости человеческой речи.В то же время объем памяти сокращается на 51,9%, стоимость снижается на 60%, а модель реализации становится меньше. но сценарии использования значительно расширяются.

В поисках моделей с большими параметрами компания Face Wall Intelligence выбрала уникальный технический путь — разрабатывать модели меньшего размера и с максимально высокой производительностью.

Выдающиеся характеристики небольшой стальной пушки MiniCPM, обращенной к стене, полностью доказывают, что «маленький» и «сильный», «маленький» и «полный» не являются взаимоисключающими атрибутами, а могут гармонично сосуществовать. Мы также с нетерпением ждем появления новых таких моделей в будущем.

# Добро пожаловать на официальную общедоступную учетную запись aifaner в WeChat: aifaner (идентификатор WeChat: ifanr). Более интересный контент будет предоставлен вам как можно скорее.

Ай Фанер | Исходная ссылка · Посмотреть комментарии · Sina Weibo