Отец ChatGPT предупредил, что ИИ может истребить людей, 350 авторитетов ИИ подписали совместное открытое письмо

Сегодня вышло важное открытое письмо в области ИИ.

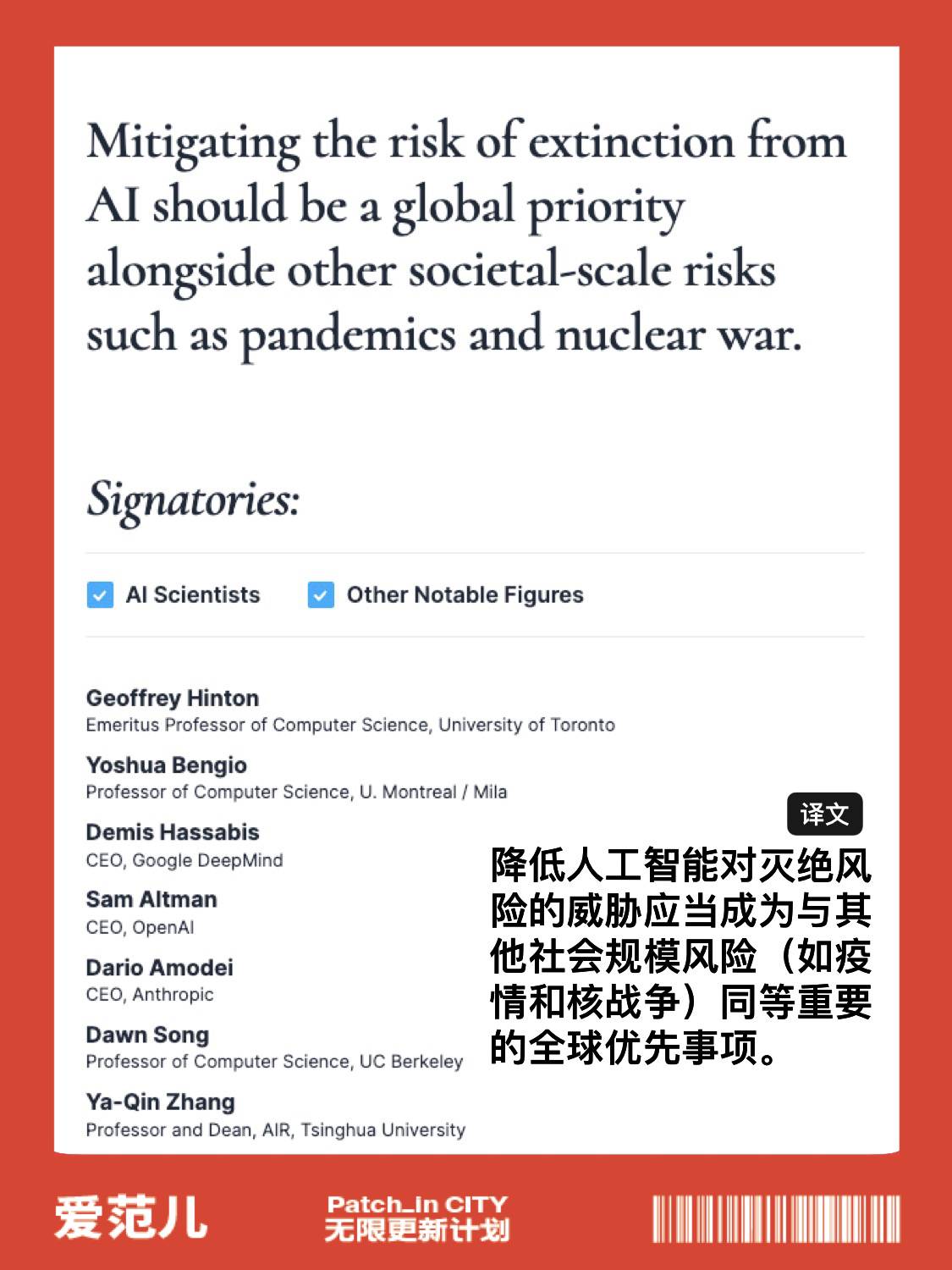

350 специалистов по ИИ, в том числе «отец ChatGPT» Сэм Альтман, подписали совместное открытое письмо и выразили обеспокоенность тем, что разрабатываемая в настоящее время технология ИИ может представлять экзистенциальную угрозу для человека.

В письме содержалось только одно заявление: снижение риска исчезновения ИИ должно быть глобальным приоритетом наряду с другими рисками общественного масштаба, такими как пандемии и ядерная война.

Присоединяйтесь к подписи открытого письма

https://www.safe.ai/statement-on-ai-риск

Среди подписантов три ведущих руководителя компаний, занимающихся искусственным интеллектом:

- генеральный директор OpenAI Сэм Альтман;

- Демис Хассабис, генеральный директор Google DeepMind;

- Дарио Амодеи, генеральный директор Anthropic;

Что еще более важно, в списке есть два «крестных отца» искусственного интеллекта, Джеффри Хинтон и Йошуа Бенжио.

Более 350 руководителей, исследователей и инженеров, работающих над искусственным интеллектом, подписали открытое письмо, выпущенное некоммерческой организацией Центр безопасности искусственного интеллекта, утверждая, что искусственный интеллект может привести к вымиранию человечества и должен рассматриваться как связанный с эпидемиями. риск равен ядерной войне.

Растет обеспокоенность по поводу потенциальной угрозы для общества и занятости, которую может представлять разработка моделей искусственного интеллекта, таких как ChatGPT, и многие призывают к более строгому регулированию индустрии ИИ, которая в противном случае нанесет непоправимый ущерб обществу.

ИИ продолжает стремительно расти, но соответствующие методы надзора и аудита не поспевают за ним, а это значит, что никто не может гарантировать безопасность инструментов ИИ и самого процесса использования инструментов ИИ.

На прошлой неделе Сэм Альтман и два других руководителя OpenAI предложили создать международную организацию, подобную Международному агентству по атомной энергии, для безопасного надзора за развитием ИИ.Он призвал ведущих международных производителей искусственного интеллекта к сотрудничеству и попросил правительство усилить контроль. передовых производителей искусственного интеллекта.

На самом деле, еще в марте открытое письмо о прекращении исследований ИИ на 6 месяцев распространилось по всему Интернету.

В письме содержится призыв ко всем экспериментаторам с ИИ немедленно приостановить исследования моделей ИИ, более совершенных, чем GPT-4, как минимум на 6 месяцев, чтобы убить эти ужасные фантазии в их колыбели.

Скорость прогресса ИИ поражает, но соответствующие методы надзора и аудита не поспевают за ними, а это значит, что никто не может гарантировать безопасность инструментов ИИ и самого процесса использования инструментов ИИ.

Совместное письмо было поддержано многими известными личностями, включая лауреата премии Тьюринга 2018 года Йошуа Бенжио, Маска, Стива Возняка, соучредителя Skype, соучредителя Pinterest, генерального директора Stability AI и т. д. достиг 1125 до крайнего срока.

Первоначальный текст открытого письма выглядит следующим образом:

Искусственный интеллект обладает интеллектом, способным конкурировать с людьми, что может представлять серьезные риски для общества и людей, что подтверждено большим количеством исследований [1] и признано ведущими лабораториями искусственного интеллекта [2]. Как говорится в широко признанных Принципах искусственного интеллекта Asilomar, передовой искусственный интеллект может представлять собой серьезную трансформацию в истории жизни на Земле, и поэтому его планирование и управление должны осуществляться с соответствующим вниманием и ресурсами.

К сожалению, даже в последние месяцы лаборатории искусственного интеллекта были вовлечены в безудержную гонку по разработке и развертыванию все более мощных цифровых умов, которые никто не может понять, предсказать или надежно контролировать, даже если они сами создатели не могли этого сделать.

Теперь, когда современные системы искусственного интеллекта конкурируют с людьми в выполнении общих задач [3], мы должны задать себе вопрос:

- Должны ли мы позволять машинам наводнять наши информационные каналы, распространяя пропаганду и ложь?

- Должны ли мы автоматизировать все работы, включая те, которые приносят удовлетворение?

- Должны ли мы развивать нечеловеческие умы, которые в конечном итоге могут превзойти и заменить нас?

- Стоит ли рисковать, выходя из-под контроля цивилизации?

Эти решения не должны приниматься неизбранными лидерами технологий. Только когда мы уверены, что влияние системы ИИ положительно, а риски управляемы, мы должны разрабатывать мощные системы ИИ. Эта уверенность должна быть обоснованной и расти вместе с потенциальным воздействием системы. В недавнем заявлении OpenAI об искусственном интеллекте говорится, что «в какой-то момент может возникнуть необходимость получить независимую оценку, прежде чем начинать обучение будущих систем, а также для современных усилий договориться об ограничении скорости роста вычислений, используемых для создания новые модели." Мы согласны. Сейчас тот самый момент.

Поэтому мы призываем к немедленному мораторию на все лаборатории ИИ сроком не менее 6 месяцев на обучение систем ИИ, более мощных, чем GPT-4. Эта приостановка должна быть общедоступной и поддающейся проверке, и в ней должны участвовать все ключевые игроки. Если такой мораторий не может быть введен быстро, правительство должно вмешаться и ввести мораторий.

Лаборатории ИИ и независимые эксперты должны использовать эту паузу для совместной работы над разработкой и внедрением общего набора усовершенствованных протоколов проектирования и разработки ИИ, которые должны тщательно проверяться и контролироваться независимыми внешними экспертами.

Эти протоколы должны гарантировать, что системы, придерживающиеся их, безопасны без разумных сомнений [4]. Это не означает приостановку разработки ИИ, а просто делает шаг назад от всегда опасной гонки к более крупным, непредсказуемым моделям черного ящика и их новым возможностям.

Исследования и разработки в области искусственного интеллекта должны быть направлены на повышение точности, безопасности, объяснимости, прозрачности, надежности, согласованности, надежности и лояльности существующих надежных, передовых систем.

В то же время разработчики ИИ должны работать с политиками, чтобы значительно ускорить разработку систем управления ИИ. Они должны как минимум включать:

- Новый компетентный регулирующий орган, занимающийся ИИ;

- Надзор и отслеживание высокопроизводительных систем искусственного интеллекта и больших пулов вычислительной мощности;

- Системы провенанса и водяных знаков для отличия реального контента от синтетического, отслеживания утечек моделей;

- Надежная экосистема аудита и сертификации, ответственность за ущерб, причиненный ИИ;

- Адекватное государственное финансирование технических исследований безопасности ИИ;

- Учреждение-ветеран, занимающееся массовыми экономическими и политическими изменениями, которые вызовет ИИ, особенно последствиями для демократий.

Человечество может наслаждаться процветающим будущим с помощью ИИ. Добившись успеха в создании мощных систем ИИ, мы теперь можем наслаждаться «летом ИИ», в течение которого мы пожинаем плоды использования этих систем на благо всех и предоставления обществу возможности адаптироваться.

Общество нажало на кнопку паузы перед лицом других технологий, которые могут иметь катастрофические последствия для общества [5]. Здесь мы можем сделать то же самое. Давайте насладимся долгим ИИ-летом вместо того, чтобы бросаться в осень неподготовленными.

#Добро пожаловать в официальный публичный аккаунт Айфанер в WeChat: Айфанер (идентификатор WeChat: ifanr), в ближайшее время вам будет представлен более интересный контент.

Ай Фанер | Оригинальная ссылка · Просмотреть комментарии · Sina Weibo